AI修复老照片,让历史“活”过来

本文来自微信公众号“光锥智能”(ID:guangzhui-tech),作者:陈思,编辑:罗宁,36氪经授权发布。

牺牲的烈士,露出微笑、用温柔的目光看着今日之中国......

已故的亲人,用慈祥的笑容看着儿孙们幸福的生活......

利用人工智能技术,不仅能让黑白照片彩色化,甚至可以让静态人物动起来。这在技术界早已不是什么新鲜事,但最近有了不少新的用武之地。

在龙华烈士墓前,

摆满了鲜花,

延年和李大钊相遇了。

他们的对话令人动容:

“先生,他们爱我”

“延年,因为你爱他们”

这是一位网友在观看电视剧《觉醒年代》之后写的一段纪念先烈的文章节选。相信看过此剧的人都会对剧中陈独秀的两个儿子陈乔年、陈延年就义前的微笑印象深刻。

这一幕的出现让无数观众落泪。

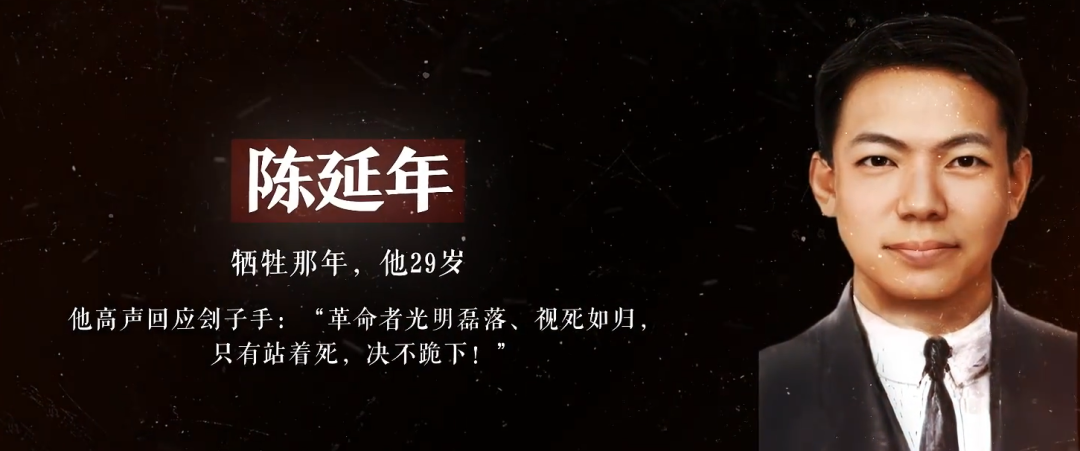

为了纪念烈士,有人找到了陈延年烈士真实的照片,利用人工智能技术为照片上色,并让他露出“真实的”微笑:

有网友在看到这张照片后说:当百年前就义的烈士看到今日之中国,想必也会这样欣慰地微笑吧。

使用AI修复烈士照片的这位网友名叫“大谷Spitzer”,你或许曾看过他的一些其他修复作品:

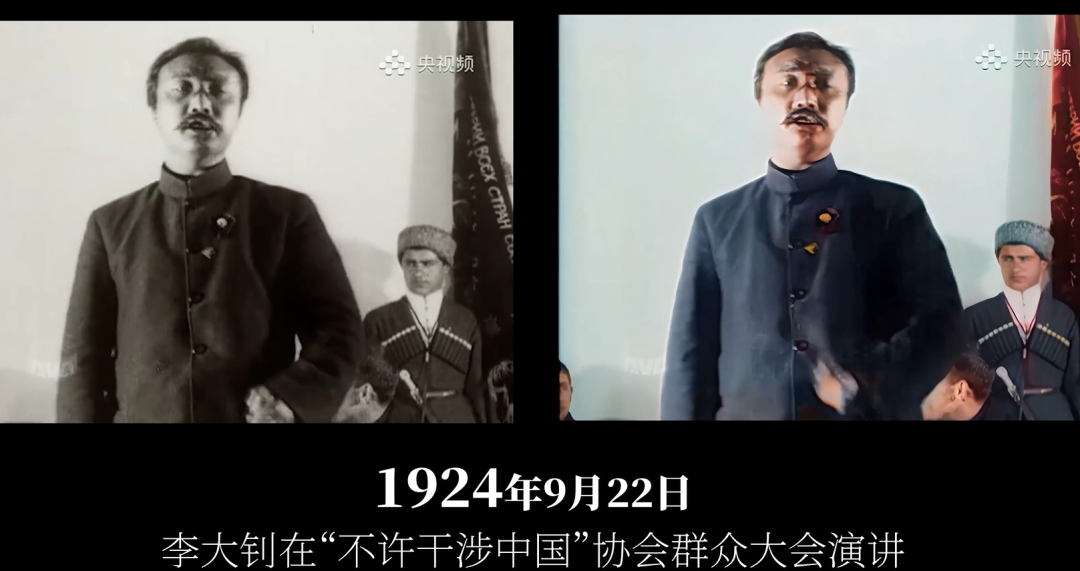

他曾经修复过李大钊于1924年9月22日在莫斯科大剧院演讲时的影像,这也是李大钊同志目前唯一留存的视频录像,相当珍贵。

从视频截图可以看出,经过AI修复的影像不仅清晰度高,对人物细节的渲染也十分到位,比如上图中李大钊同志的头发与胡须的细节,在AI修复后显得非常细致。

可能你会有疑问,大谷是如何做到的?或者说,AI技术是如何让原本黑白的影像变得鲜活起来?

AI如何给老照片上色?

照相技术诞生之初,照片都是黑白的,到了1940年代彩色照片才流行起来。所以在早些年如果你想将黑白照片变成彩色,需要手工进行,费时费力。因为当时用的是水彩、油画、蜡笔产色,所以起来并不是那么真实。

如今,人工智能技术大行其道,甚至可以毫不费力地完成这项工作。

17岁英国少年Finnian Anderson和18岁芬兰少年Oli Callaghan携手合作,开发了Colorise Bot,用户只需要在Twitter上传照片和视频并@Colorise Bot,就能在几秒内上色。

(原图与修复后地效果 | 来源:原作者博客)

作者之一的Finnian Anderson在博客上的一篇文章揭示了这项技术背后的秘密。

受内存及性能限制,他们没有选择TensorFlow进行底层框架搭建,而是使用Caffee搭建了原始网络,然后用开源数据集ImageNet中的图像对模型进行训练。

根据他们发布在GitHub上的内容可以知道,他们引用的是加州伯克利大学的 Richard Zhang 等人开发出来的着色方法。其原理简单来说,就是给出一张黑白图片,然后预测图片上物体可能的颜色,不一定能完全还原物体本身的颜色,但合理即可。

比如苹果,红色、青色都是人们普遍认知里合理的颜色,在训练过程中,如果模型给苹果上色的结果是这两种或者与之接近的,那么都可视为成功。

(训练结果 | 来源:原作者GitHub)

当然,模型对物体颜色的预测也是被大量的图片数据“喂”出来的,就比如上图中的汽车,原本的颜色可能是蓝色或者黑色,但是因为模型在识别了大量汽车的图片后学会了汽车可以有红色、黑色、白色、银色等等,因此给上图里的汽车染成红色也是合理的。

不过,大谷使用的开源AI上色项目有别于上面这一种。

根据大谷的微博,它使用的上色工具有两种:DeOldify和Deep Exemplar-Based Colorization。虽然都可以用来上色,但是这两种工具的原理有所不同。

前者使用的是一种名为NoGAN的新型GAN训练方法。大致的原理可以理解为,同时训练两个神经网络,一个叫鉴别器,另一个叫生成器。鉴别器会使用大量真实的彩色图片训练,而生成器则会根据输入的黑白图像随意上色,鉴别器根据学会了的彩色图片来判断上色的真实性。

比如,鉴别器学会了树叶可以是绿色的、黄色的、红色的,干枯后可以是黑色的;这个时候生成器给一张树叶图片染成了蓝色,那鉴别器就会判断这个结果是假的,生成器要重新给图片上色,直到出现合理的色彩。

而后者的原理就相对简单了,给定参考彩色图像,卷积神经网络会直接将灰度图像映射到输出彩色图像。

(图片来源:Deep Exemplar-Based Colorization论文)

如上图所示,目标图像是最左边的黑白图像,如果给神经网络一个穿红衣服的女士的图像为参考,那么输出的结果里,人物的衣服颜色也是红色,肤色甚至也会更接近参考图像人物的肤色。

由于大谷的图像、视频修复里采用了不止一种开源项目,因此本文对于其原理就不做过多分析了,上述结论想必已经能够部分解答读者们的疑问。

此外,大谷还采用了一些开源的辅助工具,比如旷视科技和北大共同推出的,用来给视频补帧的RIFE,它可以让老视频变得更加流畅;以及用于去除视频噪点和模糊的BasicSR等等。

AI还原的色彩准确吗?

如前文所述,AI修复的图像色彩只是“合理”,未必与真实的情况相符。不过,这也并不耽误AI还原色彩对历史学家的帮助。

爱尔兰国立大学教授John Breslin和Sarah-Anne Buckley将数字技术与历史研究结合在一起,他们将很多历史照片由黑白变成彩色。教授们使用的AI工具是前文提到的DeOldify,在训练时,DeOldify会分析大量普通彩色照片,看看各种颜色与不同的形状、纹理是如何匹配的。

当软件面对黑白照片时,它会努力搞清对象的颜色是什么,比如草、树、海洋的颜色,根据纹理判定它们是绿色或者蓝色。

当然AI也有局限性,爱尔兰的一草一木有自己的特质,美国软件有时无法正确识别。

Breslin解释说,世界许多地区的房屋可能铺有陶瓦,呈现橙色或褐色,爱尔兰一般用石板瓦,呈现灰色或者黑色。此时,同为历史学者的Sarah-Anne Buckley就会参与进来,手动修正颜色和阴影。

Constance Markievicz是爱尔兰历史上比较有名的政治家,他的眼睛到底是什么颜色呢?AI无法判断。怎么办?1890年代至1950年代,曾有很多移民前往美国,Constance Markievicz是其中之一,历史学家查看纽约埃利斯岛留下的乘客纪录,断定眼睛的颜色是蓝色。

即使学者们如此严肃,还是有很多同行不认可,他们认为像DeOldify这样的软件只是带来误导,不能增强照片效果。Breslin并不认同,他认为自从有摄影以来人们一直就在做同样的探索,而且即使用AI上色也并不是想取代原照片。

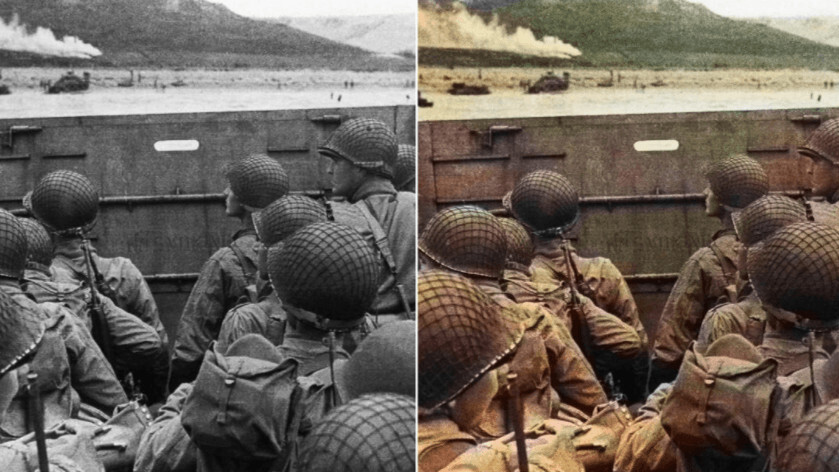

Jordan Lloyd是一名视觉历史学家,他为出版商、私人客户提供服务,给老照片上色,不过不是用计算机上色。虽然AI也能完成同样的工作,但无法达到Jordan Lloyd的要求。他说:“诺曼底纪念活动时,我曾发布一张照片,将登陆D-Day登陆的照片变成彩色。History Channel也曾展示照片,自动着色,虽然是同一张照片,但看起来很糟糕。” DeOldify、DeepAI和Algorithmia能在几秒内将黑白照片变成彩色,Jordan Lloyd却要花几十个小时才能处理一张照片。

对于Jordan Lloyd来说AI不足为惧,因为它老是出错,颜色不准确。更糟糕的是连计算机专家也不明白AI为何会出错。DeOldify联合创始人Jason Antic指出:“这是一个‘黑盒’,AI从数据中抽取任何可能的规则。”

DeOldify算是很先进的,它用一百万张黑白照片训练过,这些黑白照是从彩照转化而来的。尽管如此,DeOldify还是错误连连,部分是因为灰度图缺乏彩色照片独有的关键数据。

前文提到的论文作者,来自加州伯克利大学研究人员Richard Zhang说:“着色实际上是很有难度的,因为我们要从1D转到3D。”色相,饱和度和亮度决定了我们对彩色的感知,但灰度图里只有亮度。许多不同的颜色可能有相同的亮度,即使它们在现实中非常不同,在黑白照片中也会呈现出相同的灰度。

为了解决这一问题,计算机专家尝试用对象识别软件增强算法。Richard Zhang说:“对于照片的某些部分,我们可以确定颜色是什么。例如,我们知道天空一般是蓝色的,蔬菜是绿色的,山一般是褐色的。如果不确定,比如衬衫的颜色,上色系统就只能猜测。”

正因如此,Jason Antic并不认为AI会成为研究历史的重要工具。他认为,图片的色彩与时间、地点、环境都有关,这些AI不太可能知道。

谷歌机器学习专家Emil Wallner倒是乐观一些,他认为最终AI能做到准确识别。他在邮件中回复称:“最难的部分在于开发一个机器学习模型,它能识别图片中的图案,它要寻找相关联的历史信息并推理,看看是否可以利用信息来判断照片中某物的颜色。”Emil Wallner相信开发这样的算法是可能的,只是要提供一些环境信息给AI。

所以说,用AI给黑白照片上色很有趣,但离完美还很遥远。

AI如何让老照片动起来的?

搞明白了上色的原理,那如何让静态照片动起来呢?

说到这里就不得不提到一家名为MyHeritage的公司。

当用户进入MyHeritage网站并上传照片后,MyHeritage Photo Enhancer会增强照片,然后让它动起来,动画中的人物甚至可以微笑、眨眼、移动。

(光锥智能笔者用自己的照片测试的结果)

据了解,该网站采用的是一种名叫Deep Nostalgia的技术,它能让静态照片中的人移动起来,就像视频一样。

有意思的是,这家公司本身是做基因检测技术的,但为什么会忽然做起来动态老照片的活计?

或许MyHeritage创始人、CEO Gilad Japhet能解答,他说:“使用Deep Nostalgia技术,看到珍贵的家族照片活起来,你会发出惊叹。看到祖先的脸在视频动画中活起来,你会忍不住遥想当年他们在现实中是怎样的,这样你与家族历史就能以新的方式联系起来。”

不过遗憾的是,Deep Nostalgia并不是一项开源技术,目前在MyHeritage网站也只能免费试用5张图片,我们在这里无法深度解答它作用的原理。

但是根据一些网友的分析,Deep Nostalgia极有可能脱胎于曾经在网络上风靡一时,且最终臭名昭著的深度换脸开源模型:DeepFake。

DeepFake火爆的源头是有人利用这项技术,将《神奇女侠》女主角盖尔加朵的脸,换成了某色情片女主角的脸,并上传到了互联网。

当时大多数网友对这项技术的态度是:坚决抵制!因为它对于人们的隐私造成了非常大的威胁,甚至后来一度发生过有人利用DeepFake和AI语音合成伪造政坛高管发言的案件。

说回DeepFake的技术原理,整个流程分为三部:数据提取、训练、合成。

还是以前面盖尔加朵的案例讲解。可以简单理解为,模型先从别的视频、图像里把盖尔加朵的脸“抠”出来,据说这个模型会给人脸标记36个关键点坐标,根据这些坐标能计算人脸的角度,最终抠出来的人脸是摆正后的人脸。

然后再根据算法,对人脸进行各种角度的变换和扭曲,以适配最终合成的角色的脸,最后融合到目标图像或视频里。当然,这其中还有更复杂的技术细节,这里就不再多赘述了。

如果Deep Nostalgia确实脱胎于DeepFake,那么其背后的技术原理应该不会有太大差别,只希望MyHeritage等拥有同样技术的公司能够将它用在正道,不要重蹈DeepFake的覆辙。

AI修复老照片不只带来感动

今年父亲节,一位网友给自己的父亲送上了一份特殊的礼物。

他通过百度飞桨PaddleGAN生成对抗网络复原了爷爷的动态老照片,并实现了微笑、眨眼等各种表情,仿佛在与儿子交流,诉说这些年的思念,弥补了父亲没能见到爷爷最后一面的遗憾。

在国外的社交平台上,也有网友用类似的技术修复已过世的亲人的照片,同样带来了满满的感动。

正如Gilad Japhet所说,当我们看到肤色鲜艳、表情生动的革命先烈,或者已故的家族长辈以这样的方式出现在我们面前时,我们对他们的怀恋会更深一层,与他们的联系也仿佛更加紧密了一些。

科技如何向善?或许这是一种正确的打开方式。

参考资料:

https://www.digitaltrends.com/features/colorize-bot-twitter/

https://www.usatoday.com/story/tech/2021/02/25/deep-nostalgia-technology-animates-faces-still-photos/6814516002/

https://www.cnn.com/style/article/old-ireland-color-photos-breslin/index.html

https://scienceline.org/2021/01/ai-cant-color-old-photos/