四次事故两死两伤,特斯拉为啥总是撞上白色卡车?

编者按:本文来自微信公众号“车东西”(ID:chedongxi),作者:晓寒,编辑:肖涵 ,36氪经授权发布。

特斯拉又出事故了!

据外媒报道,就在几天前,美国底特律一台白色Model Y在一个T字路口正面撞上了一台大型卡车。Model Y车头较低,其直接钻进了卡车底部车辆严重损毁。

事故发生在当地时间凌晨3:20分左右,事发时车内一男一女两名乘客严重受伤,并被送往当地医院救治,卡车司机则并未受伤。

▲近日特斯拉在底特律撞上白色卡车

2016年和2019年,特斯拉在美国出现过两次致命事故。都是在打开L2级自动驾驶系统的同时,车辆以垂直方向撞上了大型卡车,最终导致车内人员丧生。

2020年,台湾一台Model 3在高速上也撞上了一台侧翻的卡车。

▲2019年特斯拉事故车辆,驾驶员不幸丧生

▲2020年事故现场监控画面

这三起事故有很高的相似性,因此特斯拉再次发生类似事故后,也引起了强烈关注,同时又在不断提出一个灵魂问题:

为什么被称为量产车最强的L2级自动驾驶系统,却总是躲不开一台白色卡车?

答案其实并非是特斯拉技术不强,也根本不是白色卡车就是特斯拉的“天敌”。

而是因为对静态车辆的检测,属于当下以“摄像头+毫米波雷达”作为主传感器的L2级自动驾驶方案的一个世界性难题,各家的系统对静止车辆都很头疼。

比如今年2月份,一台蔚来ES8在开启L2级自动驾驶系统巡航时,先后撞了一个行人和一台静止的五菱宏光。(可参考文章《蔚来ES8开L2撞人又撞车,为啥装24个传感器都躲不开?》)

01. 尚未确认特斯拉是否开启了L2

正如前文所言,这起事故之所以收到了中外一些媒体的关注,核心是因为特斯拉的车型曾经出现过开L2撞卡车,并致驾驶员丧生的严重事故。

但从目前外媒的报道和推特上知情网友的消息来看,目前尚无法确认事故发生时车辆是否开启了L2级自动驾驶系统。

▲事故现场

因此这起事故的原因并非与特斯拉L2级自动驾驶系统有关。

当然,即使是2016年和2019年的两起致命撞卡车事故,从责任划分上来说也是驾驶员的问题。

▲2016年类似事故现场

因为特斯拉的Autopilot系统属于L2级自动驾驶,一是只能在有限的场景下工作,二是需要驾驶员全程监控路况并随时准备接管。

比如垂直方向有大型卡车时,就属于系统不工作的场景,需要驾驶员及时接管车辆。

去年3月23日,美国国家运输安全委员会(NTSB)针对两起特斯拉Autopilot L2级自动驾驶系统致人死亡的事件发布了最终报告。报告表明,两起事故当中,驾驶员都过度依赖特斯拉L2级自动驾驶功能,从而出现注意力不集中的现象,最终导致事故发生。

▲NTSB在其网站上的发布了最终调查报告

NTSB认为,卡车驾驶员在路口没有停车,直接左转驶入高速公路,属于危险驾驶行为。特斯拉Model 3驾驶员过度依赖特斯拉L2级自动驾驶技术,导致注意力不集中。NTSB最终认定,事故原因是特斯拉Autopilot L2级自动驾驶系统在驾驶员脱手时没有及时提醒,与设计使用条件不一致,最终导致发生碰撞事故。

其中一起事故,就是2019年3月1日出现的Model 3撞上卡车致使驾驶员死亡的事故。

就算没有开启L2,那特斯拉的AEB自动紧急制动系统为什么也失灵了呢?

特斯拉的AEB系统可以手动关闭,因此如果驾驶员当时关闭了AEB,那么系统自然就不会工作了。

02. 事故可能性分析 传感器配置要背锅

从美国监管机构的报告可以看出,垂直方向撞卡车的事故,明显是超过了特斯拉L2系统的工作范围,又加上驾驶员没有及时接管所造成的。

那么问题来了,为什么被公认为“量产车最强L2”的Autopilot系统,就是躲不开一辆活生生的大卡车呢?

与车东西此前报道蔚来ES8事故的结论一致:这起事故的根本原因是“摄像头+毫米波雷达”的传感器配置,很难识别静止车辆或缓行车辆。

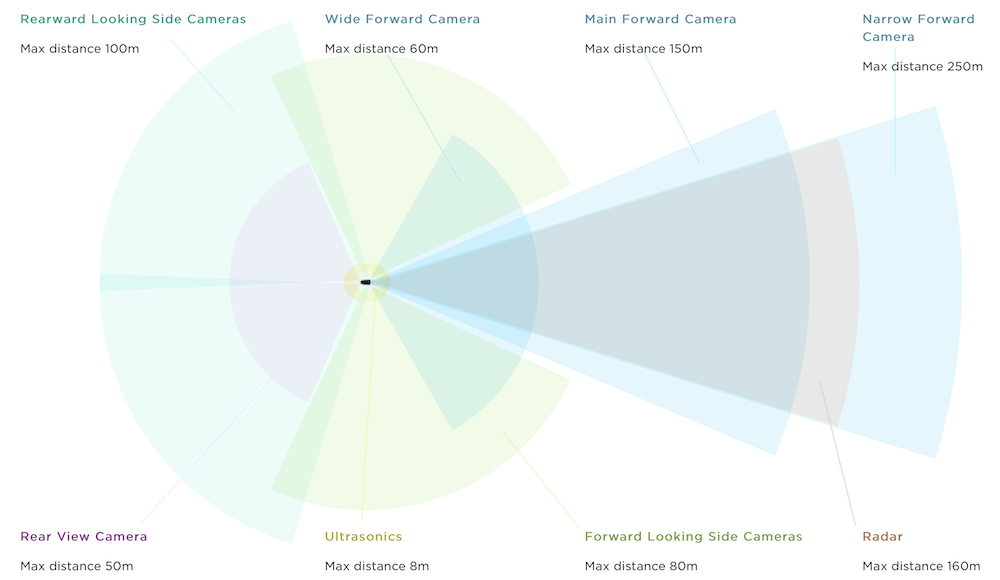

与Model 3一样,特斯拉Model Y周身搭载了8个摄像头,1个大陆的毫米波雷达,和12个超声波雷达。

▲特斯拉传感器配置

在开启L2级自动驾驶系统(Autopilot、NOA或EAP系统)时,车辆主要依靠前视摄像头和毫米波雷达探测前方物体。

特斯拉虽然是三目前视摄像头,但并没有使用立体视觉,三个摄像头主要是焦距不同,看的视野范围不同。

所以总的来说,特斯拉与目前绝大部分L2级自动驾驶系统都一样,都是视觉+毫米波雷达的传感器方案。

不管是使用基于规则的视觉算法还是使用深度学习技术,视觉在感知外界物体时永远做不到100%准确,甚至经常会出错。

比如笔者自己的特斯拉在出地库时,就会莫名把墙壁识别为公交车。又比如最近很火的一个抖音视频中,特斯拉在空无一人的墓地,就莫名识别出了行人。

▲特斯拉在无人墓地识别出行人

此外,还出现过把公交车身上的人物照片识别为行人、把路边广告屏幕上的停车标志识别为真实停车标志的案例。

而靠反射毫米波来探测目标的雷达不会“见鬼”,前方有东西就有回波,没有东西就没有回波。

正是因为视觉出错概率很高,雷达更“靠谱”,因此大部分L2系统会在视觉的基础上再引入毫米波雷达的探测结果进行验证。

如果摄像头发现前方有车辆,雷达也确认了前车的位置和速度,就可以做出刹车的动作。

如果用这些误识别的结果来做驾驶决策,显然会出现更多的问题。特斯拉自然知道这一点,因此在实际中并不会对纯视觉的感知结果进行反应。

所以这起事故的原因就很明确了,不管视觉有没有识别到前车,一定是毫米波雷达没有给出结果,所以最终系统没有反应。

03. 毫米波雷达天生缺陷 害怕静止车辆

毫米波雷达即然不会“见鬼”,那么为啥会识别不到前方的卡车呢?

东南大学国家毫米波重点实验室毫米雷达技术专家、毫米波雷达公司隼眼科技CTO张慧多次向车东西分析了背后的原因。

从最底层的工作原理来说,毫米波雷达主要是依靠多普勒效应来感知移动目标。多普勒效应的特性是,动态对动态最容易感知、动态对静态较难感知、静态对静态极难感知。

这是因为如果前方车辆静止,目标信息容易和地杂波等掺杂在一起,需要一定的算法才能从中分辨出目标。而如果是一个行驶中的汽车,基于其多普勒信息,从而比较好探测到目标。

所以如果卡车静止或者移动速度很慢,雷达的算法就无法知道前方有物体。

但这种可能性并不大,因为各大雷达公司已经做出了一些感知算法,可以识别静态物体。

真正的难点是,现在的雷达没有高度信息,并且空间分辨率不足。

没有高度信息,意味着雷达很难区分横穿马路的路牌和桥下的车;空间分辨率不足,意味着两个距离很近的物体,其回波会被混在一起,很难知道有几个目标。

所以雷达公司和一些车企在拿到雷达的反射数据后,会通过算法直接将一些静止物体,或者疑似静止的物体过滤掉,以避免产生错误的反应。

比如本次事故场景中,因为卡车是垂直Model Y方向行驶,如果同时行驶速度又很慢的话,因为缺乏径向多普勒分量,雷达的识别算法很容易将其当成静态目标过滤掉了。

如果毫米波雷达把目标过滤掉了,所以不管视觉能否看到这台卡车,都不起用了。

04. 结语:车企仍在不断优化L2级自动驾驶

回到这起事故,特斯拉当时是否开启了自动驾驶系统还没有确定,事故原因还需要等待当地警方和特斯拉官方调查。实际上,即便开启了L2级自动驾驶系统,白色卡车这一场景也有些极端。对目前量产L2级自动驾驶系统来说,还有不少场景无法处理。

针对L2级自动驾驶系统存在的种种问题,车企也给出了自己的解决方案。一方面,自动驾驶算法不断优化,通过“影子模式”、上路测试等方法,让自动驾驶系统不断成熟,同时不断增加L2级自动驾驶的功能。另一方面,随着硬件成本的下降,不少车型已经规划搭载激光雷达,避免类似事故发生。