AI 一个月训练出“虚拟替身演员”能跳、能打斗,又一批人类工友即将失业

据外媒 Inverse 报道,加州大学伯克利分校的研究人员开发出了一种新的 AI 系统,该系统生成的计算机动画特技演员能够重现武术的基本动作,未来将有可能取代人类特技演员。

“这是对深度学习和动画所做的一次相当大的飞跃,”伯克利分校研究生 Pang 在今年8月的SIGGRAPH会议上发表的研究报告中说。“很多相关工作都是在模拟自然运动,但它们没有/无法提供多种技能运用的通用方法。它和以人类动作为标记的「运动捕捉」技术看上去很相似,但本质上不同。我们的技术正朝着(塑造)虚拟替身演员迈进。”

该项目相关的一篇论文《DeepMimic》发表在 ACM Trans 杂志上。随后该团队在 GitHub 上提供了代码和动作捕捉数据供其他人试用。

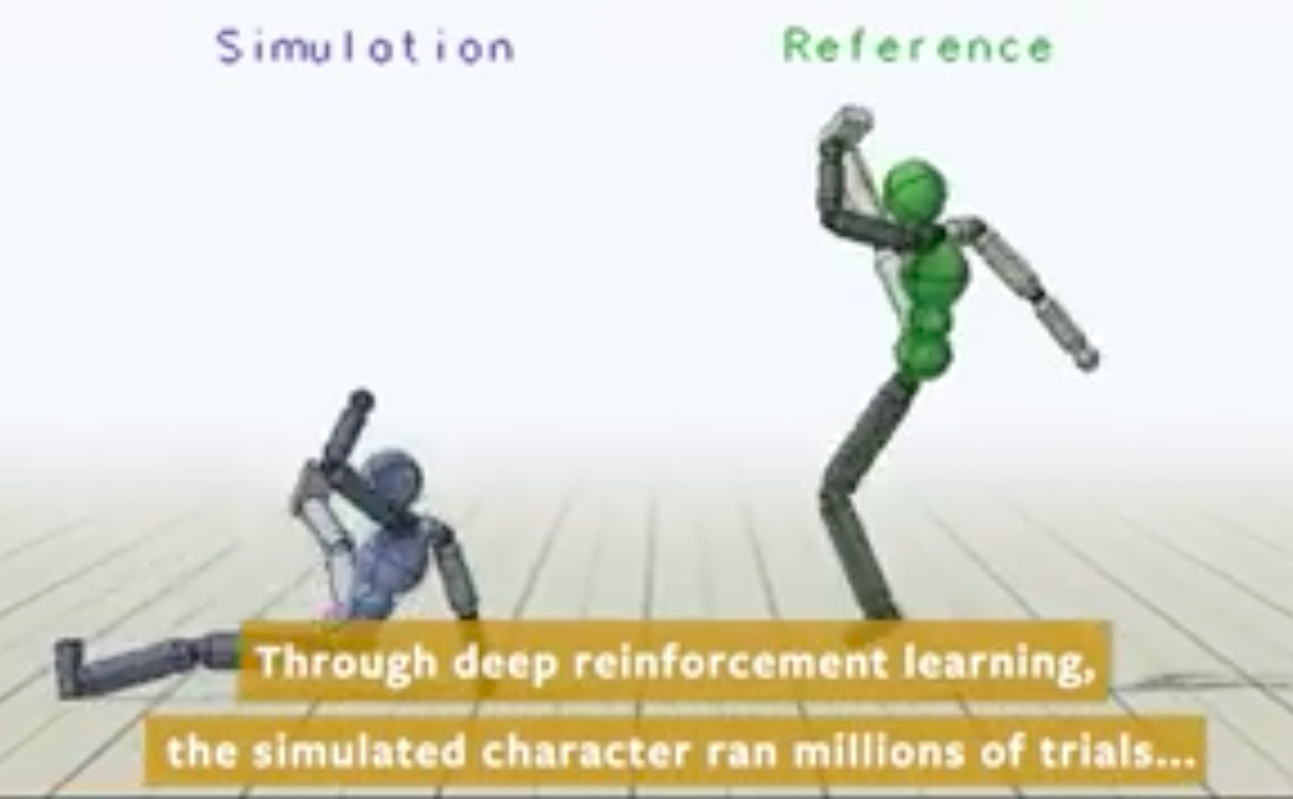

该团队使用「深层强化学习技术」(RL,reinforcement learning)来教导系统如何移动。它从现实生活中获取动作捕捉数据,将其输入系统,并让系统在模拟中练习这些动作,模拟时间相当于一个月,每天24小时训练。DeepMimic学习了25种不同的动作,比如踢腿和后空翻,每次比较它的结果,看它与原始动作捕捉数据的接近程度。

与其他可能反复尝试并失败的系统不同,DeepMimic将移动分解为多个步骤,以便在某一时刻失败时,它可以分析其性能并在适当的时刻进行调整。(点击查看原文及演示视频)

“随着这些技术的进步,我认为他们将开始在电影中发挥越来越大的作用,”Pang 告诉 Inverse。“然而,由于电影通常不存在互动,这些模拟技术可能对游戏和VR产生更直接的影响。”

事实上,对于这些使用「RL」训练的模拟角色,独立游戏就是很好的试验场景。但它们可能需要更长的时间才能准备好应用在AAA级游戏里,因为使用模拟字符需要对传统的开发渠道进行相当大的调整和改变。Pang表示,已经与一些游戏开发商和动画工作室讨论过这项工作的可能应用,但暂未透露细节。

该科研团队表示,「角色动画」的长期目标是,将数据驱动的行为规范,与能够在物理模拟中执行类似行为的系统相结合,从而让角色能够对扰动和环境变化做出真实的响应。加州大学伯克利分校的实验结果展示了,RL方法可以被用来学习、模范非常多的示例动作,实现用户指定的目标。

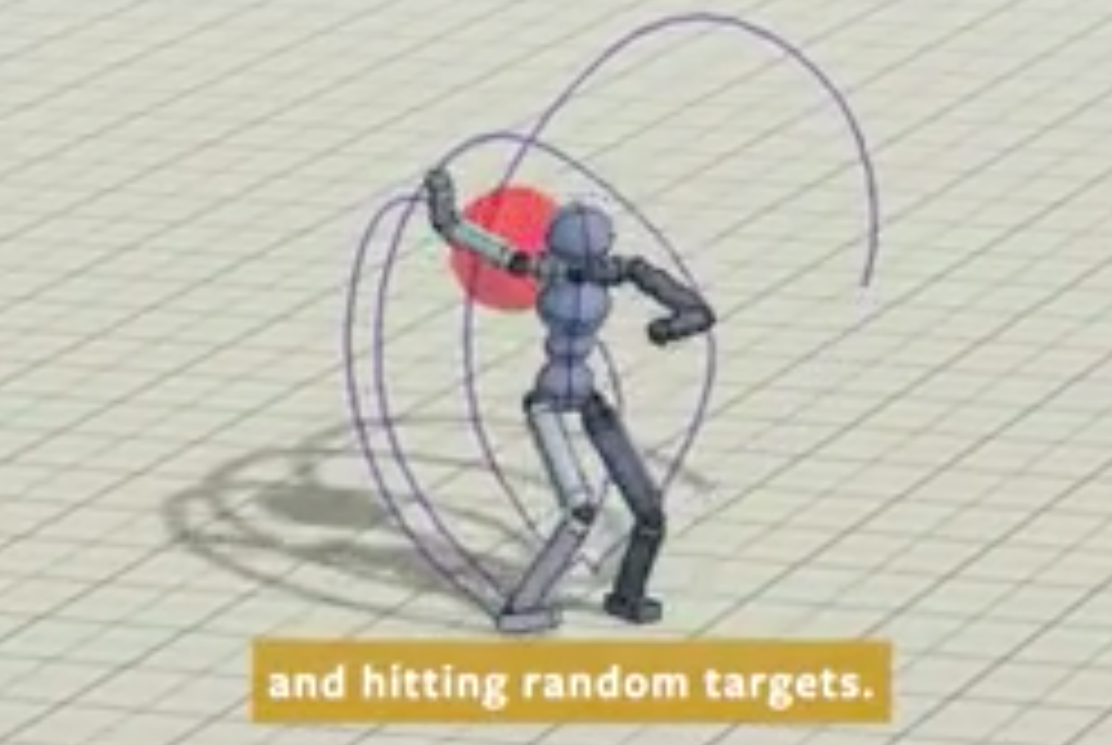

其方法是,处理关键帧运动、高度动态的动作,如动作捕捉的翻转、旋转和重定向运动。通过将动作模仿目标与任务目标相结合,来训练角色在交互设置中做出智能反应,例如,沿着想要的方向行走或向用户指定的目标扔球。

因此,研究人员用“运动剪辑”来定义所需的样式,使角色具备基于RL和物理动画的灵活性和通用性。他们尝试了多种方法,将多个片段集成到学习过程中,以开发具备多技能代理功能的动画角色。并且使用了多个角色(人类、阿特拉斯机器人、双足恐龙等)和多种技能来演示结果,包括移动、杂技和武术。