2017年,AI在人类设计的所有游戏中都打败了人类

编者按:本文来自网易科技,编译:李擎,选自:NEW ATLAS;36氪经授权发布。

在20世纪的大部分时间里,国际象棋是人工智能研究人员的一个基准。早在上世纪50年代初,约翰?麦卡锡提出了“人工智能”一词,他曾把国际象棋称为“人工智能领域的果蝇”,这一说法来源于早期对果蝇的研究对遗传学领域的影响。

上世纪90年代末,IBM的“深蓝”与世界冠军加里-卡斯帕罗夫进行了一系列国际象棋比赛。

在1997年,深蓝最终击败了卡斯帕罗夫,这是机器第一次在比赛中击败世界冠军。到本世纪早中期,这项技术已经进步到了一定程度,在几乎所有不同玩法的游戏中,机器都在不断地打败国际象棋大师。

自然而然地,人工智能开发者开始转向其他更复杂的游戏,以测试他们日益复杂的算法。在过去的12个月里,人工智能跨越了一系列的新门槛,最终在各种不同的游戏中击败了人类玩家,从古老的围棋游戏到动态互动的纸牌游戏,德州扑克。

从国际象棋到围棋

上世纪90年代末,机器终于彻底打败了国际象棋大师后,一位来自普林斯顿的天体物理学家评论说,“可能要等上一百年,电脑才能在围棋中打败人类——甚至可能更长。”

于是计算机科学家们又把研究的注意力转向围棋,这是一个来自中国的古老的策略游戏,非常容易学会,但是很难做到精通。

在过去的十年中,机器学习的发展创造了真正有竞争力的人工智能围棋选手。2014年,谷歌开始开发一个名为AlphaGo的深度学习神经网络。在经历了几年的接近成功之后,开发团队尝试了一些不同的东西。

在2016年末,一个名为“Master”的神秘网络围棋选手出现在了亚洲热门游戏服务器Tygem上。在接下来的几天里,这个神秘的玩家在于许多世界冠军的比赛中占据了主导位置。到2017年1月4日,官方确认“Master”实际上是DeepMind的AI AlphaGo的最新版本。

2017年5月,AlphaGo “Master”打败了柯洁——世界上排名第一的围棋选手。在AlphaGo和柯洁对战的三场比赛中,这台机器一直处于优势地位,但最令人吃惊的是,在10月份的时候,谷歌已经研究出了一个比“Master”更先进的AlphaGo版本。

根据《自然》杂志的一篇文章中,AlphaGo Zero是一种革命性的算法,它能够迅速地自学围棋。这个系统一遍又一遍地与自己对战,掌握了不同情况下的游戏方法。经过21天的学习,AlphaGo Zero已经达到了“Master”的水平。40天后,它就已经超过了之前所有版本的技能水平。

到2017年12月,DeepMind推出了一个更先进的系统版本。这款名为AlphaZero的新人工智能可以在几小时内掌握多种游戏。经过8个小时的自我训练,该系统不仅可以击败之前的AlphaGo Zero,还可以完全掌握国际象棋和日本将棋。

掌握扑克牌中的“欺诈”术

尽管围棋游戏的复杂度已经非常之高,但对于人工智能来说,围棋和扑克采用是两种完全不同的模式。要想在扑克游戏中取胜,你需要掌握一定的欺诈技能。欺诈以及识别他人的欺诈是在纸牌游戏中取胜需要掌握的关键技能。

经过十多年的尝试,在2017年,两项独立研究显示,人工智能终于打败了一流的扑克牌专业人士。来自加拿大阿尔伯塔大学的研究人员推出了一个人工智能系统,DeepStack,它可以用一种人工智能形式的“直觉”来全面控制人类扑克玩家。

卡内基梅隆大学的一个研究小组在2017年1月举办了一场更加公开的活动,当时它的Libratus AI系统花了20天时间,与四名专业的扑克玩家一起玩了12万局无限注“德州扑克”。尽管专业人士每天晚上都在讨论他们可以利用人工智能的哪些弱点,但这台机器每天都在改进自身,修补游戏玩法中的漏洞,改进策略。

人类的大脑无法与机器匹敌,在经过近一个月的不间断游戏之后,这台机器总共赢了170万美元,而这4位专业人士中的每一位都损失了数千美元的虚拟货币。其中一名专业玩家对《连线》杂志说:“在这次激烈的比赛中,我感觉自己在和一个作弊的人比赛,就好像我的牌可以被他看到一样。我不是在指责它作弊。这其实是一件好事。”

埃隆·马斯克的AI研究

2015年,埃隆·马斯克和一小群投资者成立了一个名为OpenAI的项目。该项目旨在探索人工智能系统的发展,尤其是在强化学习方面。在这种系统中,机器可以教会自己如何在特定的任务中提高自己的能力。

2017年8月,OpenAI团队将目光投向了征服Dota 2,这是一场名为“The International”的大型电子竞技锦标赛中的核心比赛。Dota 2是一款非常受欢迎且非诚复杂的多人在线对战游戏,在竞技游戏领域是一项严肃的比赛。

在仅仅两周的学习之后,OpenAI机器人就加入到了这场锦标赛中,随后击败了世界上的几名顶尖选手。目前人工智能系统只被训练过较为简单的一对一版本的游戏,但OpenAI团队正在研究如何让AI掌握五对五的“团队”游戏。

AI通过分工玩转“吃豆人”游戏

几年前,谷歌DeepMind对其人工智能在49款雅达利2600的游戏中进行了训练。只要有和人类玩家相同的输入,AI就会知道如何玩这些游戏并在游戏中获胜。事实证明,有些游戏确实比其他游戏更难以驾驭,在这些经典的、众所周知非常困难的游戏中,20世纪80年代的一款电子游戏“吃豆人”尤其具有挑战性。

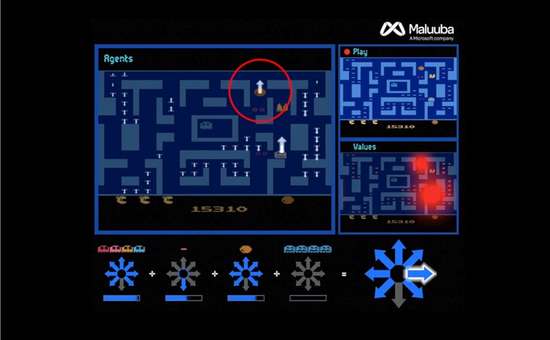

2017年,谷歌收购了一家名为Maluuba的深度学习创业公司,并将其并入DeepMind。Maluuba的新型机器学习方法被称为“混合式奖赏架构”(HRA)。将这种方法应用到吃豆人系统中,该系统创建了150多个个体代理,每一个都有特定的目标——比如找到一个特定的豆子,或者避免幽灵。

HRA方法生成一个高级代理,类似于高级经理。在做出每一步的最终决定之前,这个高级代理会评估所有来自下级代理的建议。这种方法被委婉地称为“分而治之”,即把复杂的任务分解成更小的部分。

在将这个方法应用到吃豆人之后,AI很快就掌握了如何获得999990分的高分,这是之前没有人或人工智能能做到的。

AI将开始设计游戏

如果人工智能能在几乎每一场比赛中击败我们,那我们下一步该干什么?

法尔茅斯大学的一名研究人员最近公布了一种机器学习算法,他声称这一算法可以为我们创造出自己的游戏,我们从零开始玩游戏。这个人工智能系统名为Angelina,它每天都在不断改进自己,但目前它已经可以利用从维基百科共享到在线报纸以及社交媒体等各种来源的数据集制作游戏。

那么这一切意味着什么呢?

也许2017年最重大、最可怕的发展是强化学习系统的巨大进步。这些程序可以有效地教会它们自己如何掌握新技能。例如,最近的AlphaZero迭代可以在几天的自主学习之后,在一些游戏中获得超能力。

一项对350多名人工智能研究人员进行的大规模调查显示,人工智能还不足以打败我们。这项调查预测,在10年内,人工智能将会比我们更优秀,到2049年它将能够写出一部畅销小说,到2053年,它将会比人类在外科手术中表现的更好。事实上,该调查得出的结论是,到2060年,人工智能将有50%的几率能够完成我们所能做的所有事情,并且效果会更好。

2017年无疑是人工智能在日益复杂的游戏中打败人类的里程碑式的一年,尽管这看起来是一项微不足道的成就,但它的影响是巨大的。许多这些人工智能开发公司正迅速将目光投向现实世界的挑战。

谷歌DeepMind已经将AlphaGo Zero的系统应用到了其他领域,并进行了一项有关蛋白质折叠的全面研究,以期揭示治疗阿兹海默和帕金森等疾病的治疗方法。

“最终,我们希望利用像这样的算法突破来帮助解决各种现实世界问题中亟待解决的问题,”DeepMind的共同创始人兼首席执行官杰米斯?哈扎比斯(Demis Hassabis)说,“如果类似的技术可以应用于其他结构性问题,比如蛋白质折叠、减少能源消耗或寻找革命性新材料,那么取得的突破将有可能加强人类对这个世界的理解,并对我们所有人的生活产生积极影响。”