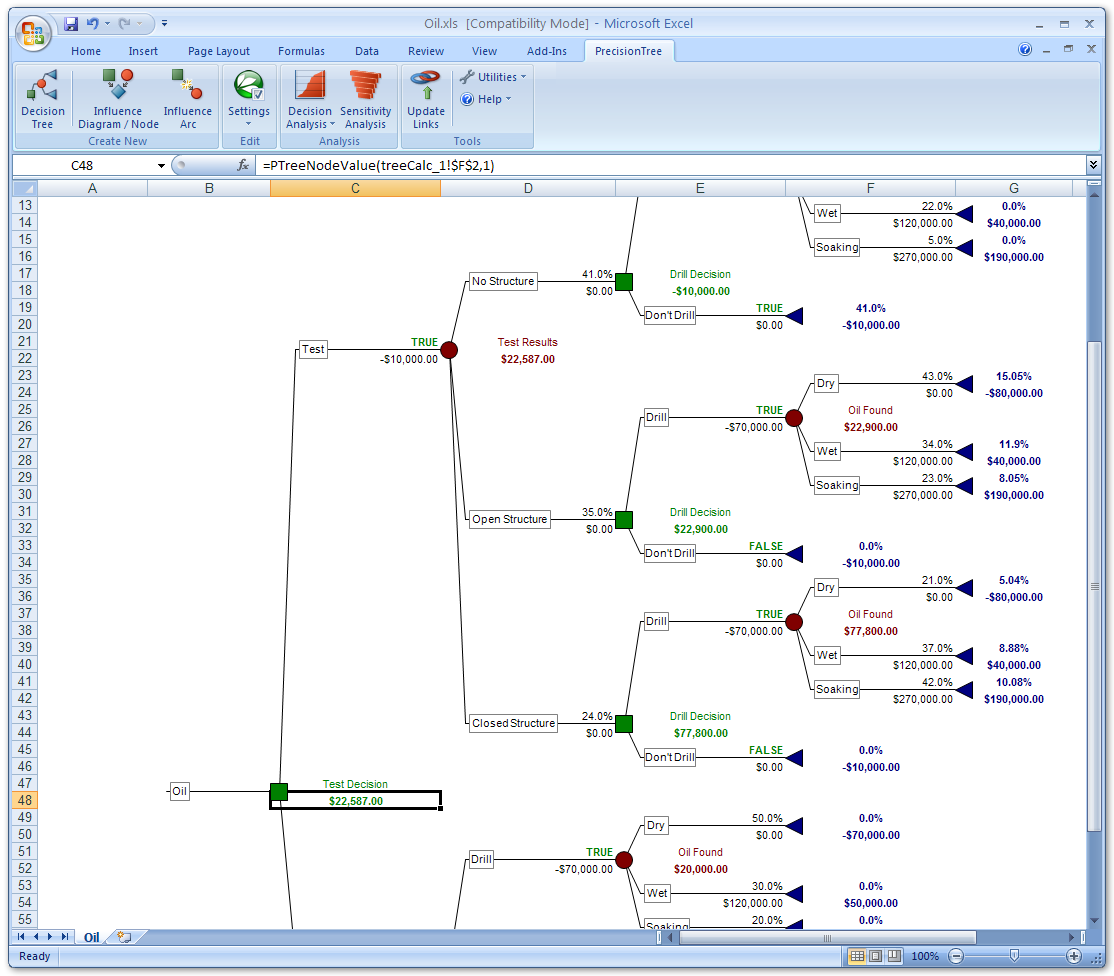

决策树仍是最好的数据挖掘算法

转载时间:2021.05.27(原文发布时间:2011.06.14)

255

阅读次数:255次

数据挖掘算法:理由如下:

*决策树是白箱「white box」,意味着可以生成简单易懂的规则。你可以通过查看决策树清楚明白各个分支,明白某个分支的影响,并且将其和其他分支进行对比。

*决策树术为非参数「non-parametric」,意味着无需特定的数据分流。决策树可以轻松应对连续变量和类别变量。

*决策树可以像处理变量的任何常规值那样处理缺失值。

*决策书操作方便。你可以选择设定决策树的深度,分支的最小观测值数,每个分支的树叶。

*决策树是最好的独立变量选择算法之一。如果你想做一个逻辑(线性)回归模型或神经网络,但首先需要减少变量数的话,那么你可以用决策树:速度快,并且可以考虑变量之间的互动。

*决策树是弱学习器「weak learner」。咋一看好像是一个缺点,如果你想在系综「ensembles」中大量使用弱学习器的话,弱学习器表现很棒,因为当独立模型都为弱学习器的话,系综会变成非常强大的算法。

*决策树可以识别子集。每个终端或中间树叶都可以被视为一个子集。

*决策树在有很多观测值和变量的情况下运行速度依然很快。

*决策树可用于监督和监督学习。

*决策树简单。是一种简单算法。无需复杂的数学知识就可以看懂。

*决策树可生成高质量模型,可以从数据中提取大量信息,尤其适合在系综中使用。

*决策树可轻松处理非平衡数据集如果你有0.1 %可靠目标和99.9%不可靠目标,那么你可以试试决策树。

理由够多了吧?你还能找到这么漂亮的算法吗?

作者:

zyxo

数据分析相关的软件

行业专家共同推荐的软件

限时免费的数据分析软件

新锐产品推荐

消息通知

咨询入驻

商务合作