打破人工智能算法黑箱

本文来自微信公众号“腾云”,作者:张吉豫

张吉豫:中国人民大学法学院副教授、中国知识产权法学研究会理事、北京大学计算机博士

AlphaGo战胜了人类顶尖围棋选手,无人驾驶汽车开始在公路上运行,擅长聊天的机器人可以成为你的朋友,人工智能离我们越来越近,带来很多希望的同时也引起了不少的忧虑和质疑,因为让人摸不透的复杂算法就像是一个黑箱。那么这个黑箱究竟应不应该被打破?又该如何打破呢?

人工智能的挑战已经到来

自去年AlphaGo战胜人类顶尖围棋手之后,人工智能这一概念真正成为了社会各界关注的焦点,也为各国政府所重视。

今天各类人工智能相关系统以深度学习算法为突出代表,凭借当今计算机系统及云计算平台提供的强大计算能力,以及欣欣向荣的传统和移动互联网、物联网所带来的日益丰富多样的数据资源,为人们提供了一幅可信的发展图景,相应的算法已在许多领域付诸使用,引起了无限热情期盼,也带来了众多质疑和担忧。

无论期盼或是担忧,我们都正在见证着一个新的信息时代的开启。在这个时代,许多让我们一时还琢磨不透的人工智能算法,在进行着认知、学习、预测和决策,可能为我们提供医疗、法律、金融等方面的建议或决策,也可能直接操控汽车、无人机,甚至大规模杀伤性武器。如果回顾信息技术的发展历程,我们有理由相信,这一次技术创新和应用推广的发展速度也许会超乎我们的想象。

人们常说,法律总是滞后于社会发展。面对互联网技术带来的社会影响,我们刚刚建立起有一定体系的理论和规范,人工智能的挑战就已经到来。这一次,在政府、产业、资本和学术界的共力之下,面对人工智能可能带来的巨大社会影响,恐怕并无太多时间留给法律和政策制定者来慢慢观察和考量。

追求可解释性依然是我们信赖的思维模式

在时下热议的人工智能相关伦理、算法歧视、算法正确性、安全性等问题中,有一个问题被时常提起,即以深度学习算法为代表的人工智能算法的可解释性问题。

人类理性的发展历程使我们相信,如果一个判断或决策是可以被解释的,我们将更容易了解其优点与不足,更容易评估其风险,知道其在多大程度上、在怎样的场合中可以被信赖,以及我们可以从哪些方面对其进行不断改善,以尽量增进共识、减少风险,推动相应领域的不断发展。这样的思维范式或许是诞生在人工智能时代之前的稍显过时的思维模式。

例如舍恩伯格等在《大数据时代:生活、工作与思维的大变革》一书中就提出,大数据技术引发思维变革;应更为关注事务之间的相关关系,而不是探索因果关系1。或许随着科技和社会的发展,未来会演化出新的思维范式,但目前这仍然是我们最成熟、最具共识、最可信赖的思维模式,我们仍然需要能够对重要问题的决策作出解释。

由此,许多国家和地区已经开始探索在一些法规中对此予以一定的回应。IEEE、ACM等行业协会和计算机科学家们也在积极行动,以期促进算法的可解释性。

例如,IEEE协会2016年的关于人工智能及自动化系统的伦理设计白皮书中,在多个部分都提出了对人工智能和自动化系统应有解释能力的要求。

美国计算机协会美国公共政策委员会也在2017年初发布了《关于算法透明性和可问责性的声明》(Statement on Algorithmic Transparency and Accountability),提出了七项基本原则,其中之一即为“解释:鼓励使用算法决策的系统和机构对算法过程和特定决策提供解释。这在公共政策中尤为重要”。

2017年10月,美国加州大学伯克利分校的研究者们发布了《对人工智能系统挑战的伯克利观点》2一文,从人工智能的发展趋势出发,总结了九项挑战和研究方向,其中一项即为“可解释的决策”。

该文中特别指出,在一些领域,人们希望知道人工智能程序的特定输入所具有的哪些性质导致了特定的输出结果。

例如,人们可能希望知道,一个X光片中的哪些特征(例如大小、颜色、位置、形式等),导致了特定的诊断结果,以及这些特征的小扰动会使诊断结果发生怎样的变化;还有哪些类型的输入会导致类似的诊断结果,等等。

人工智能的算法黑箱并不会比自然现象更难以分析

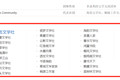

▲机器学习是人工智能的一种途径或子集,它强调“学习”而不是计算机程序,

一个系统可以从自身的错误中学习来提高它的模式识别能力。

这些看法认为增强人工智能算法的可解释性具有积极意义,但是,增强可解释性是否是可能的呢?

诚然,以深度学习为代表的人工智能算法经常被描述成一个无人理解的黑箱。但正如莱西格(Lawrence Lessig)教授在其经典著作《Code 2.0:网络空间中的法律》中所反复强调的,当前技术本身是怎样,并不等同于技术必须是怎样。实际上人工智能算法的输出仍然是由数据和代码决定的,并不会比自然现象更难以分析和解释,更何况其设计者还可以通过一些机制从内部增强其可解释性。

一方面,人们可以研究如何更好地从观察的角度来解释人工智能算法。我们至少可以将人工智能算法作为一个客观事物来进行观察、实验和分析。

例如,我们可以通过观察算法对于不同输入所产生的输出,来尝试了解其规律。更进一步地,对于比较复杂的人工智能算法系统,人们也可以通过搭建一套自动测试分析系统来进行辅助分析。

其实法学界就有研究者进行过初步的相关研究。例如,新加坡国立大学法学院的Seng Kiat Boon教授在斯坦福大学学习期间做了一个有意思的研究工作,针对网络上侵犯知识产权内容的“通知-删除”规则的自动处理系统进行了分析。

在现在的技术背景下,很多知识产权人及各类维权代理机构会借助一定的技术手段,让软件自动检测网络上的侵权内容,并自动向网络平台发送发现侵权内容、要求删除的通知;面对每天接收到的大量侵权通知,很多平台已经从主要依靠人工受理转变为利用算法来自动处理。

Seng教授采用一些基本的技术方法,从网上资源库中收集和分析了超过50万个“通知-删除”实例,来剖析谷歌等平台的“通知-删除”自动处理系统的特性3。当然,这个例子中只是运用了简单的技术手段,但相信未来的一个方向是,人们可以用信息技术来解析信息技术,用算法来辅助理解算法。

在这一方面,除了系统设计者自身,社会上的相关用户、研究者以及新闻记者都可能进行相关分析研究。分析能力和分析条件的提高也将是问题研究、社会监督的重要支撑。

另一方面,可以研究如何更好地设计兼顾可解释性的算法和系统。在传统软件错误检测实践方面,软件工程师们可能通过在算法中加入特定调试语句来记录调试信息,或者在编译程序时编译为调试模式,帮助自己或其他软件工程师理解程序代码执行的情况、各个关键变量的变化情况,等等,从而帮助定位算法错误。很多计算机硬件也提供一定的调试支持。

在设计人工智能算法和系统时,也同样可以加入一些增强可解释性的模块,并利用人工或机器辅助来进行解释。《对人工智能系统挑战的伯克利观点》一文中,加州伯克利大学的研究者们就提出,支持可解释决策的一个要素是人工智能系统能够记录和忠实重现导致特定决策结果的计算过程。

由此,应该来研究能够支持交互式诊断分析的人工智能系统,忠实重现过去的执行情况,帮助确定输入中的哪些特征导致了特定结果,并在可能的情况下为因果推理提供系统支持。

当然,这样的方式可能导致算法运行速度的降低,甚至一些辅助机制可能影响算法的精确度。因此,研究者们需要在这一领域深耕细作,不断提出在可解释性和算法效率等方面均令人满意的方案。

此外,亦有学者建议,将关键决策过程中使用的人工智能算法开源,并公开相关数据。这无疑是增加透明性和可解释性的一种途径,但并不是增强算法可解释性的彻底解决方案,也涉及许多其他问题。

一方面,这可能涉及企业的商业秘密、个人隐私等问题,并不适用于全部场景;另一方面,代码和数据开放本身并不意味着就满足了社会对于算法可解释性的需求。

我们可以看到,很多拥有数据和代码的企业都无法直接对自己的算法做出充分解释。在兼顾可解释性的算法和系统设计以及配套解释方法和工具方面,仍然需要深入研究。

多种途径加强对可解释性的研究和推广

那么,我们可以如何来促进支撑算法可解释性的相关研究呢?

研究者的兴趣自然是一项重要动力。除此之外,政府的鼓励和支持、行业的伦理和规范、市场的需求以及相关知识产权带来的激励、法律法规的要求等,都可能成为激励算法可解释性相关研究的措施。

如果我们把目光投向软件正确性验证及安全性保障领域,可以看到,尽管有研究兴趣、一定的市场需求和知识产权的激励,而且在测试方法等方面确实不断有新的研究,但相应的研究开展程度远不及信息技术的其他很多领域。

一方面这可能由于问题本身的困难性,另一方面也反映出仅凭研究兴趣和简单的市场和知识产权激励,并不足以推动其充分发展。对于消费类软件的错误、漏洞,人们已司空见惯;时不时的系统崩溃,大家也都习以为常。

可是,消费类软件中的错误或许并不会引起过多的问题和严重损害,但在当前及未来的一些关键领域和情境下,人工智能系统却可能影响人的基本权利、自由和生命安全。

由此,在既有激励的基础上,我们有必要通过行业的伦理规范和标准、政府的鼓励和支持、适当的法律责任分配以及监管机制等多种途径,来加强对人工智能算法可解释性的研究和应用推广。

算法的可解释性是我们更好地掌握和控制人工智能的基础。美国华盛顿大学法学院的Ryan Calo曾提出,跨学科实用主义的传统或许是网络法最伟大的遗产4。

在信息技术高速发展的今天,法律和政策研究者除了将目光投向其宏观特性,也应该对相应的变化有所了解,并进行积极影响,使其更好地服务于我们的社会,推进人类追求的美好价值的实现。

Luke Dormehl在《算法时代》中将算法比喻成船只。“船只的发明同时带来了海难⋯⋯但算法同时也发挥了极其重要的作用,帮助我们在每天产生的多达2.5艾字节(是人脑信息储存量的100万倍)的数据海洋中航行,并得出切实可行的结论。”Sara Baase教授在《火的礼物:人类与计算技术的终极博弈》一书中将计算技术比作火。

火“使我们的生活更加舒适、健康和愉快。而它同时也拥有巨大的破坏力,有可能因为意外,也可能是故意纵火⋯⋯渐渐地,我们已经学会如何高效地使用它,如何安全地使用它,以及如何更有效地应对灾难,无论是自然的、意外的,亦或是故意造成的。”期待通过共同努力,我们可以更好地掌握人工智能算法,来帮助我们解决各种难题,建设更加美好的社会。

1.[英] 维克托·迈尔-舍恩伯格、肯尼思·库克耶: 《大数据时代: 生活、工作与思维的大变革》,盛杨燕、周涛译,浙江人民出版社2012 年版。

2.Ion Stoica, etc., “A Berkeley View of Systems Challenges for AI”, Technical Report No. UCB/EECS-2017-159, http://www2.eecs.berkeley.edu/Pubs/TechRpts/2017/EECS-2017-159.html, October 16, 2017.

3.参见Seng, Daniel Kiat Boon, 'Who Watches the Watchmen?' An Empirical Analysis of Errors in DMCA Takedown Notices (January 23, 2015). Available at SSRN: https://ssrn.com/abstract=2563202. Seng, Daniel Kiat Boon, The State of the Discordant Union: An Empirical Analysis of DMCA Takedown Notices (Jan 31, 2014). 18 Va. J. L. & Tech. 369 (2014).

4.Ryan Calo, “Robotics and the Lessons of Cyberlaw”. California Law Review, Vol. 103, No. 3, pp. 513-63 (2015)