早到、早退又迟到,Google 如何差点错过手机摄像头的未来?

编者按:本文来自极客公园,作者:宋德,编译自Wired,原文标题《How Google Goggles Won, Then Lost, the Camera-First Future》,36氪经授权发布。

随着科技行业走向相机优先的未来交互,人们开始用摄像头交流、游戏和工作,Google 又重新回到了原点,用同样的想法,尝试完成上一次没有完成的事业。

在今年 5 月的 Google I/O 上,CEO Sundar Pichai 激动地向观众们介绍 Google 最新的 AR 产品 Google Lens,他展示了 Lens 精准的识别能力,和一连串智能化的操作体验。对陌生的观众来说,这是无比激动人心的,但对那些曾经密切关注 Google 的观众而言,这一幕却异常熟悉。

早在 2009 年,Google 就公开展示了一款类似的产品,Google Goggles,它曾经是创始人谢尔盖·布林和拉里·佩奇逢人便提的公司骄傲,却在发布两年之后销声匿迹,如今也已经鲜为人知。在这近 10 年中究竟发生了什么?最先看到手机摄像头未来的 Google 为何在 AR 技术接近成熟的今天成为了行业的后来者?在这篇文章中你将发现这些问题的答案。

Google 对增强现实(AR)技术的第一次尝试,起源于酒吧里的一次争吵。

那是 2008 年,一个资历比较老的 Google 工程师 David Petrou 正在布鲁克林的一家酒吧中向他的朋友们介绍他脑海中的新技术,「有一天,你只要拿起手机,对准一个东西,就可以在网络上搜索到它。」

他打了个比方,这就像孩子指向一个物品问那是什么。基于在 Google 观察到的前沿技术,他认为这种技术已经能够实现了。

但他的朋友们在当时不怎么相信他,他们觉得这是天方夜谭,计算机视觉不过是科幻小说中的情节。

Petrou 愤怒地离开了酒吧,回到家里,他开始编写程序。尽管他没有计算机视觉方面的技术背景,但因为曾经在 Google Bigtable 项目(一个适用于云计算的数据储存系统,后期发展为独立 app)有过一天的工作经验,他自学了 Java 语言,学会了编写安卓应用,并潜行开始钻研 Google 在计算机视觉方面的研究成果。

一个月的闭关修炼之后,Petrou 完成了第一个模型,这个模型也在日后演变成了著名的 Google Goggles。

现在 Petrou 还留有早期的演示视频。他被拉进了一个视频会议室里,另一边是用户体验的设计师 Ted Power。在他开始演示之前,Petrou 解释了这个产品,「这是通用图像标记,图像可以在 Google 中被搜索到,在后端我们会用该图片的一些特点来标记它。」

为了更好地解释它,Petrou 使用了 Google 当时最新的安卓手机 G1,拍了几张报纸上有关国会监督艾克森美孚(ExxonMobil)的文章。片刻之后,手机识别出了文章里所有的单词,在黑色背景上用白色字体重新排版出来。比起一个手机 app,它看起来更像是 Windows 系统中的 DOS 命令窗口,但即使如此,它仍然让在座的 Google 员工们感到惊讶——除了文章末尾的时候它将艾克森美孚拼成了 Em<onMobile。

几分钟后,Petou 展示了一张亮度过高的照片,照片里是 Power 的办公桌,散放着几本书,一些电线,图片的中心是一台 MacBook 电脑。将图片上传给 app 的 10 秒钟后,app 弹出了 10 个描述词,其中包含「房间」、「室内」和「笔记本」甚至「MacBook」这样的单词,让 Petrou 为之兴奋不已。不过,也有「诺基亚」这样不相关的词语。

随后 Petrou 解释道,「要想提供完美的结果,我们还有很长的路要走。」

最初版本的 Google Goggles 模拟图

Goggles 的第一个版本能做的事并不多,效果也一般,但通过图片搜索在当时仍然是一件非常神奇的技术。在接下来的几年里,在苹果开发 ARKit 和微软推出 HoloLens 之前,在其他厂家开始探索 AR 应用之前,Goggles 为智能手机与真实世界之间的交互提供了一个非常重要的早期例证。

可是后来 Goggles 流产了。智能手机第一个伟大的 AR 实践在被其他人抄袭之前,就自我终结了。

著名的喜剧演员罗宾·威廉姆斯曾经开玩笑说爱尔兰人是如何保存文明的:他们喝几瓶吉尼斯黑啤,然后把存放文明的地点忘得一干二净。

Google 和智能手机的摄像头也是一样。近十年前,Google 的工程师们已经在研究那些如今你在 SnapChat、Facebook 甚至 iPhone X 和其他许许多多地方看到的新创意,随着科技行业走向相机优先的未来交互,人们开始用摄像头交流、游戏和工作,Google 又重新回到了原点,用同样的想法,尝试完成上一次没有完成的事业。

而这一次,它希望自己不会太迟。

眼见为实

在 Petrou 最开始研究 Goggles 时,他并不知道有没有其他 Google 员工也在做一样的事。在 2006 年,Google 收购了 Neven Vision,这家公司拥有当时最先进的计算机视觉工具。Google 的想法很明确,在照片分享应用 Picasa 中应用这项技术。

「它可以很简单地检测出照片里是否有人,甚至在以后,能够识别人类、地点和东西。」Picasa 的产品经理 Adrian Graham 在博客中说道,「这项技术会让你轻松地整理并找到你感兴趣的图片。」

几年后,随着 Neven Vision 的技术进一步投入到 Picasa 中,该公司的创始人 Hartmut Neven 开始了更深层次的思考:「我们被《终结者》启发,当施瓦辛格走入酒吧,它能够识别出所有的东西。」Shailesh Nalawadi 说道,他是原先 Neven Vision 的产品经理,如今是 Mavin Inc. 的 CEO,「我们就在想,如果把图片与数据库匹配,那我们是不是就能知道图片里有什么了。」

最终,Neven Vision 的团队与 Petrou 合作,他们开始打造一个更好的原型系统,一个能够识别图书、音乐专辑、画作、地标性建筑和其他许多知名度较高的图像。如果你拍了一张照片,花 20 秒的时间上传并分析它,这个 app 就能够分析出图片中的东西。这虽然很原始,但还算行得通。

Google 内部的很多项目都是以同样的方式开始,一个人着手打造一个新鲜的产品,然后向周围的人展示,吸引到他人的注意后集中资源进一步打造它。对 Goggles 的团队来说,几乎每一个人都被 Petrou 简陋的应用打动到,两位公司高管,工程副总裁 Vic Gundotra 和研究事务副总裁 Alan Eustace 尤其如此,他们在后来成为这个项目的有利支持者。

Google 的员工们开始讨论,当这个应用能够识别所有东西的时候,正式对外发布后会收获怎样的反响。「Google 的每一个员工都明白这是很有可能的,这不是什么特别的技术,但它却能够引起变革。」Nalawadi 回忆说,「我们正处于风口浪尖,我们可以完成它。」他把这项技术比作自动驾驶,大胆并充满未来感,但又完全是自然的。如果你能够拿起手机对准一样东西然后发问:那是什么呢?你有什么理由拒绝这样的操作呢?这太 Google 范了。

在 2009 年的 12 月,Google 在位于山景城的计算机历史博物馆正式发布了 Goggles,演示的产品只有几项简单的功能:识别地标、艺术品和一些消费级产品,仅此而已。

Google 对这个产品表达了谨慎且乐观的态度,这是 Google Labs 的一部分,在 app 安装介绍中 Google 就直白地表示 Goggles 有哪些东西无法识别。但人人都清楚他们的计划,Gundotra 在发布会上说:「今天,Google Goggles 对某些特定物品的识别做得很好,但我们的目标是让它能在视觉上识别任何图像。今天,你必须拍张照片让它识别,未来,你只要指向它... 我们可以把它当做现实世界里的鼠标指针。」

不过,在公司内部,Goggles 还面临这一系列的技术问题。他们知道,理想中「鼠标指针」的未来还需要多年的探索。「我们一直都清楚,它更像是一个研究项目,」一个前 Google 工程师说道。就算是最领先的计算机视觉技术仍然相当原始,并且因为当时 Google 还没有在机器学习和神经网络上大量投入,所以 Goggles 当时能做的也只是简单的特征匹配而已。

有些问题是 Google 自己无法解决。比如智能手机的摄像头还不够先进,人们也不知道如何很好地利用它们。就算用户能够拍出不错的照片,图片里也很有可能存在着各种各样的其他物体;Google 不知道用户是想了解路边的树,还是长凳,或者猫猫狗狗,或者一个路标。

文本识别技术可以帮助机器识别物体,但只能是非常标准的字体,视角上弯曲或者手写的字体对算法来说是一个非常大的挑战,其他差距很小的东西也是,比如不同型号的汽车等。

标志很简单,植物却很难,条形码简单,动物却是几乎不可能的。很多物品就算能够识别,在 3G 网络下也需要花费很长的时间。

最令人沮丧的是,Google 甚至不能使用它最擅长的技术,最近似终结者的面部识别技术。「如果网络上有 6 张标记出你的照片,那么当我们拿到第 7 张时,我们有 90% 的几率能够在前 10 的搜索结果中提供给你正确答案。

但 Google 知道,他们不能一次性推出所有功能,用户和监管部门会担心 Google 知道他们多少隐私和秘密,正因为这个原因 Google 不能立刻使用面部识别功能。

Goggles 的团队仍在不断尝试让用户更频繁地使用他们的 app,Goggles 成为了一个数独的终极解决方案,一个翻译工具,一个条形码扫描器,所有这些都给了人们再次使用这款应用的理由。

Petrou 仍记得他们有开发一个叫做「虚拟涂鸦」的功能,用户可以在 AR 世界里绘画,然后把它留在那个虚拟的世界里。这一功能与 Facebook 在 2017 年开发者大会上展示的 Facebook Camera 平台上的功能如出一辙,而 Google 在数年前就有了这样的想法,但他们却始终没有发布这项功能。

「破碎的眼镜」

Google 继续开发 Goggles,但很快这个项目便停滞不前,Google 曾经想要为 Goggles 打造一款独立的 iPhone 应用,但最后却把它植入到了 Google 的母应用里,并且,很快地,又在母应用中移除了这项功能。

2011 年以后,Google 很少再谈起 Goggles,到 2012 年,这个项目已经基本上被抛弃了。

笔者交流过的大多数人对 Goggles 项目的死亡都持有不同的看法。其团队的一员认为这项技术有一定的瓶颈,于是他们选择了放弃。还有些人表示拿着相机四处走的使用方式让不少人感到不适,人们还不能适应这样的使用方法。

但所有人都认为,有一件事可能会是罪魁祸首。

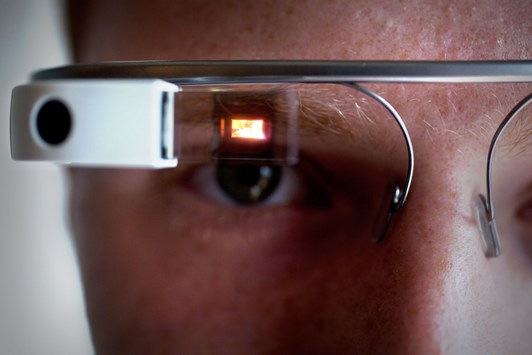

2011 年的时候,Google 提交了一项专利申请,「头戴式显示器,显示物理交互的视觉表现,兼具视野以外的输入式交互界面。」这些复杂的文字只是在表达一样东西:Google Glass。

Petrou 表示,「我们从来没有质疑过智能手机」可以是视觉搜索的一个有效场景。但其他人则表示 Goggles 团队从一开始就知道智能手机并不是应用该技术最理想化的设备。最终,他们发现,用户更愿意使用一个他们不需要举起或管理的设备,这时眼镜就会合理许多(隐形眼镜的话更好)。

不过,这些技术似乎都需要数年的时间,而且对设备的计算能力、电池效率和网络连接情况有着非常高的要求,也正是因为这些原因,Google 的工程师们仍旧将智能手机作为应用平台。

但实用性并不是每个人都追求的。据 Goggles 团队的一位前成员表示,某种程度上来说,Google 的高管喜欢 Goggles 单纯是因为它展示起来非常酷炫。所以拉里·佩奇和谢尔盖·布林两位创始人就非常喜欢将 Goggles 展示给外人看,后来有了 Google Galss,一个更加酷炫、有未来感的产品,相比之下 Goggles 就被比下去了。

事实上,Google Glass 始终是 Google 最重视的产品之一,布林在 2012 年的 Google I/O 上打断了一场演讲,只为了让观众观看戴着 Google Glass 的跳伞运动员在空中翻跟头,然后降落在会议大厅的屋顶上。在一个名为「One day...」的视频中,Google 展示了智能眼镜加持的增强现实生活的美好愿景。布林甚至把 Google Glass 带去了 2013 年的 TED 现场,激动地向观众描绘一个解放双手的智能设备。Google Glass 提供了一个激动人心的未来图景,启发了 Google 公司内外的许多科学家与工程师,而它的实用与否,这时似乎没那么重要了。

然而,此时的 Goggles 团队已经逐渐分崩离析了,成员大多去了别的团队,Google Glass,谷歌地图,YouTube 等等,甚至有些人直接离开了 Google。到 2014 年年中,已经没有人在维护 Goggles 的安卓 app 了。

回到起点

就在 Google 放弃 Goggles 项目的时候,其他科技公司开始注意到这一技术的价值。2011 年,Snapchat 推出了一个阅后即焚的社交应用,随即转型将智能手机的摄像头作为其社交平台。苹果、Facebook 等公司也紧跟着开始重视增强现实技术,并应用在自己最新的产品中。

而在 Google 内部,底层技术不会被浪费,事实上,它的进展比以往任何时候都要快。高级产品总监 Aparna Chennapragada 表示,「因为深度学习,这项技术有了跳跃式的发展,和语音技术的快速进步一样,图像搜索也开始崛起。」通过收购 DeepMind,投资 AI 芯片,以及 Google 在整个人工智能行业内所作的思考,这项技术得到了更好和更快的改进。

第一个得到应用的产品就是 Google Photos。在这个 app 里图像识别终于得到了最好的应用,而 Google 也如愿以偿地引入了它引以为傲的面部识别技术。

这些年来,大部分当初限制了 Goggles 的技术困境已经得到了有效的解决,手机摄像头已经非常出色,陀螺仪、GPS 等环境采集的传感器也能够为应用增加更多的附加信息。

如今,数十亿智能手机用户每天都愿意打开他们的手机分享生活的瞬间,后端的技术有了进步,前端的交互也更加容易,现在很少有人愿意带个面具或者画个脸谱拍照,但他们却非常乐意用手机应用去这么做。

这一切解释了为什么,Google 的 CEO Sundar Pichai 愿意在今年 5 月的 I/O 上再一次发布 Goggles,不同的是,这次它换了一个名字:Google Lens。

Google 产品管理总监在今年 10 月的硬件发布会上演示 Google Lens

「Google Lens 是一个基于计算机视觉技术的应用组,它能够帮助你理解你正在看着的东西,并让你基于它所获取的信息采取行动。」Pichai 说道。

他在现场做了一些演示,对花草植物的识别、摄像头对准 WiFi 的用户名和密码时手机自动连上 WiFi 等,一切都与 Goggles 如此相似,甚至,视频演示里的应用目前还无法在大众产品中实现的「单纯秀炫技」也与当年一模一样。现在,Google Lens 能做的也是 2010 年时 Goggles 能做到的,只不过它比当时要快得多。

人们很容易怀疑,Google 是否在思考人们如何使用手机相机的时候浪费了这么多年的技术优势。公司里一部分人非常清楚,人们迟早会使用手机屏幕来探索这个世界,Google 可能很早就预见到了这点,但在实际的竞争中,竞争者们用更加吸引、打动用户的产品击败了 Google。

Google Pixel 2

虽然 Google 本可以早早入局,但现在仍然不算太迟。他们确实有着巨大的内在优势,搜索引擎的优势和长期对用户个性化数据的积累都会帮助到 Google,而他们也在 Goggles 的实践中学到了一课。

这一次,Google Lens 不再是一个独立的应用,它融入了许许多多 Google 的产品中——比起一个你很少去打开的应用,Google Lens 这一次存在于 Google Photo 和 Google Assistant 等用户原本就经常使用的 app,Google Lens 将无处不在,而用户也已经对它的存在习以为常。

对 Google 来说,它已经把 Lens 作为公司的一个长期发展的项目,一个集结了诸多使用案例的平台。Pichai 将 Lens 比作刚刚起步的 Google,因为当初 Google 理解互联网,搜索才能够做成,而如今,Google Lens 正尝试着去理解这个世界。下一次,当 Google 再次尝试可穿戴的计算设备时,Lens 一定会作为一个基础型技术存在其中,那样的产品,展示起来依旧会让人兴奋难耐。