研究人员开发了一副反人脸识别的眼镜,戴上它你就是另外一个人!

关心图像识别研究的朋友可能知道,为了评估和改进AI的识别能力(鲁棒性),研究人员会设计一些“对抗性”图像,它们主要被用来欺骗机器视觉系统。

36氪之前就介绍过麻省理工大学的一项研究,他们用算法生成 “对抗性”图像并将其附加到了3D打印模型上,之后用这些模型去骗谷歌的图像分类AI。

测试的结果有多夸张呢?3D打印的乌龟玩具被认成了步枪,AI眼中的棒球竟然是一杯浓缩咖啡。

AI对3D物品的错认足以引起我们对诸如自动驾驶、智能监控等系统的担忧,因为这些都很依赖AI的图像识别能力。而如果当下正受追捧的人脸识别技术也被“对抗性”图像攻破,那么我们日常生活中类似刷脸支付、刷脸过检等行为岂不是存在着巨大的安全风险?

新的研究证明,这份担心非常有必要。因为现在,能欺骗人脸识别系统的眼镜已经出现了。

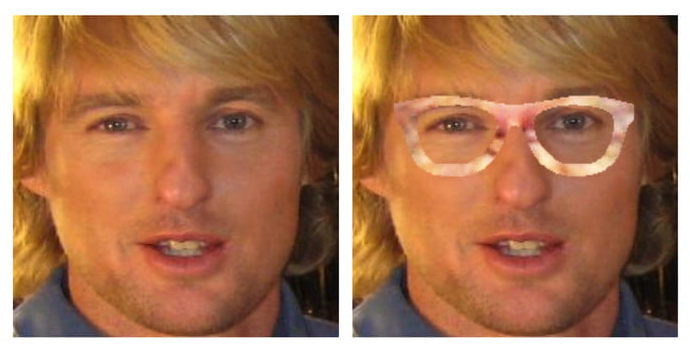

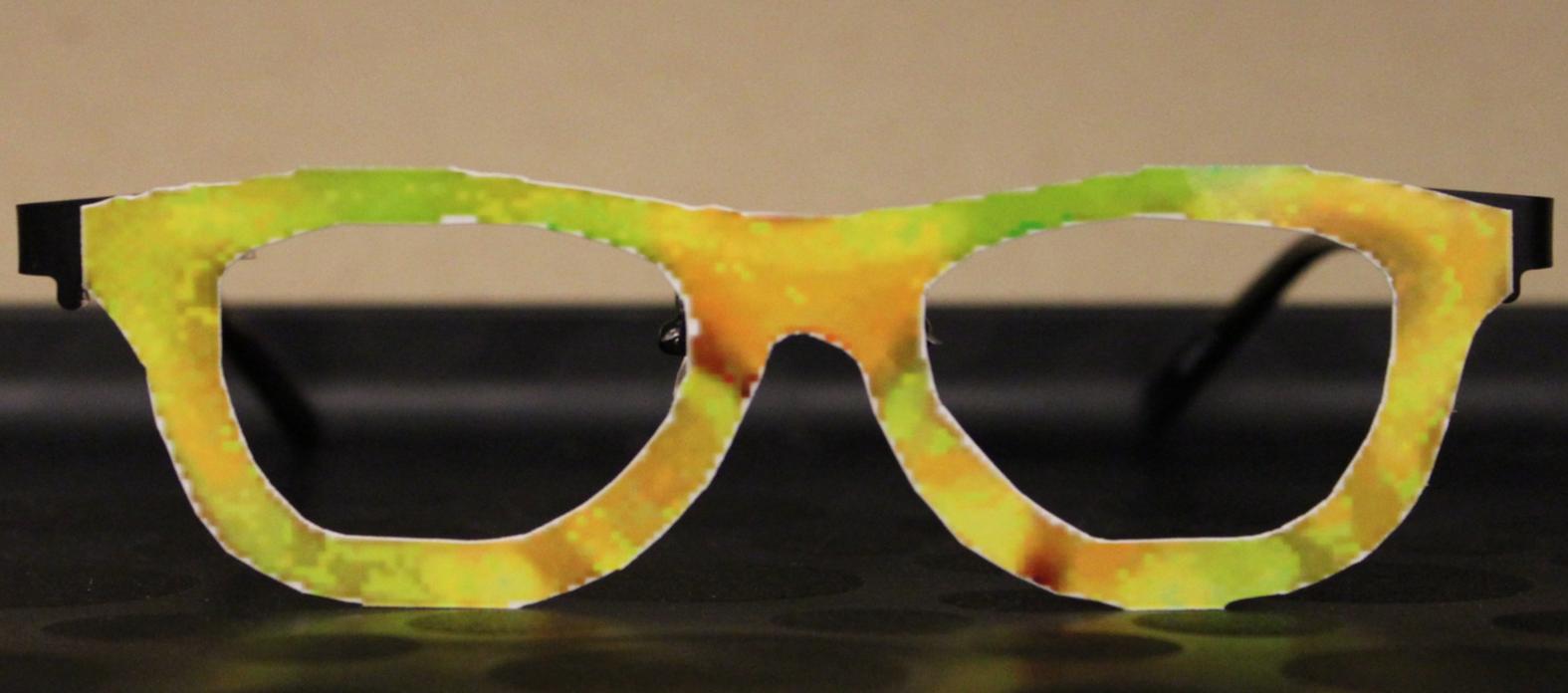

与一些浮夸的伪装面具不同,它们看上去还比较普通。图片来源: Carnegie Mellon University(下同)

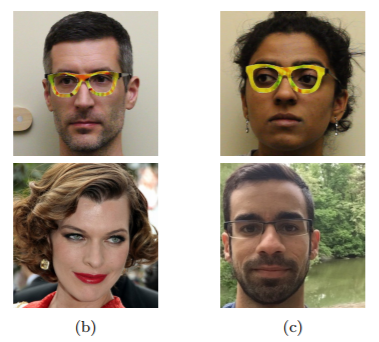

这副反面部识别眼镜由美国卡耐基梅隆大学和北卡罗来纳大学的研究人员合作开发,一共有五种。使用者戴上眼镜后能够成功骗过面部识别系统的“眼睛”。

一名男性在佩戴后被识别成了女演员米拉 · 乔沃维奇。而他的女同事则成功扮演了一个中东男人。

研究人员兼联合开发者Mahmood Sharif在接受Vice采访时说,眼镜被设计用来误导基于神经网络学习的面部识别系统,它成功骗过Face++的概率为90%。Face++是一款专注人脸检测、分析和识别的软件。

该面部识别软件的神经网络是基于对人脸像素颜色的分析来猜测一个人的身份的,被测者脸上任何轻微的变化都会影响到整个识别系统。

Sharif表示,他们通过优化算法找到了可以躲过系统识别的眼镜颜色,并且保证颜色可以平滑过渡(类似于自然图像)。这些图案会扰乱面部识别系统的感知,影响AI读取它们的准确性。

研究人员透露,这种眼镜可以由用户自行打印出来。

目前,这些反面部识别眼镜已经针对 VGG 和 OpenFace 深度神经网络系统进行了测试,结果显示欺骗成功。

我们的研究表明,基于深度神经网络的面部识别是一种特殊的算法, 可以被一个不做任何改变只是简单戴了一副眼镜的人所误导。

也就是说,面部识别系统非常容易受到攻击,试想如果反面部识别眼镜被犯罪分子戴着的话,他们就能轻而易举地逃过公共系统地监控或者以别人的身份进入某家公司。

不过,对这副眼镜的评价很大程度上也取决于我们如何看待面部识别技术。一方面,注重隐私的人会对眼镜的前景感到兴奋, 因为它可以帮我们绕过公共场合的众多监控。一个数据是,如果我们生活在一个城市地区,平均每天会被拍到70次, 并且还可以被面部识别技术认出来。

另一方面,面部识别也经常被用来保障我们的安全, 比如国内机场正在大量应用人脸识别系统进行安检,以识别潜在的危险人物。

出于安全考虑,两个大学的研究人员已经将他们的研究结果递送给了自己国家的运输安全管理局(TSA) , 并建议TSA考虑在未来安检时,检查乘客身上看似普通的物品, 比如眼镜和珠宝等。因为这些小玩意儿可以被用来当作欺骗面部识别系统的工具。

"随着社会对面部识别技术的依赖越来越强, 我们有时会忘记它可能失败。在安全性要求高的场合里部署深度神经网络,我们需要更好地理解如何让人脸识别在恶意干扰面前变得更强大。"研究人员在他们的论文中写道。

论文最近发表在了arxiv.org上, 题目是《对抗性生成网络:对最先进人脸识别技术的神经网络进行攻击》。

题图来自Getty Images