把乌龟看成枪,拿棒球当咖啡,谷歌的图像识别AI好像对这个世界有点误解?

从自动驾驶汽车到智能监控摄像头再到面部识别技术,我们正在慢慢学着相信AI,相信机器视觉系统识别不同图像的能力。但是麻省理工大学的一项新研究却发现,AI识别好像没那么靠谱,因为它竟然把一只3D打印的乌龟识别成了一把步枪。

不管怎么变换角度,识别结果都是步枪(rifle) 动图来自Labsix

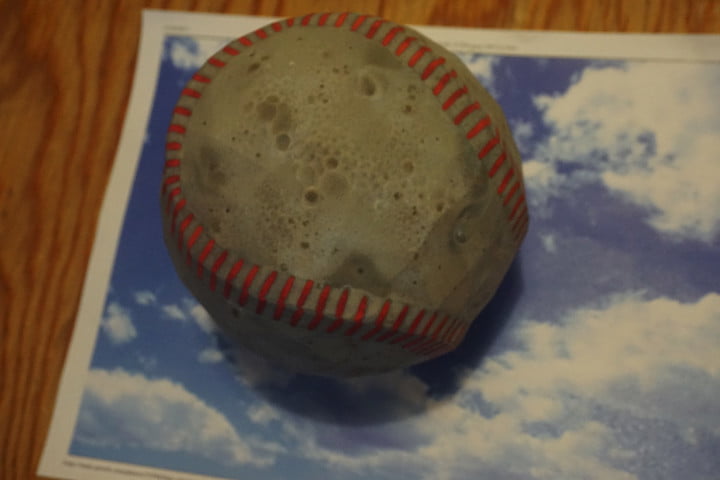

更加让人嘀笑皆非的识别测试还有:3D棒球在谷歌AI的眼中成了浓缩咖啡,可爱的猫咪有时竟被认成鳄梨酱。

AI认为这个棒球是浓缩咖啡 图片来自digital trends

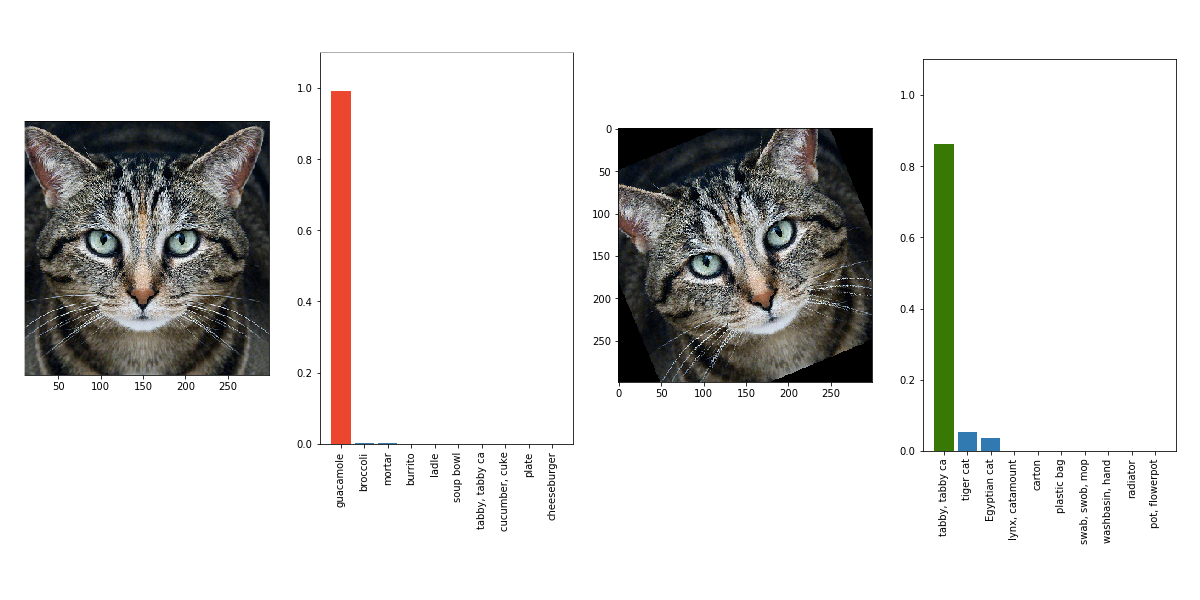

左边的图像已被改变,识别结果是鳄梨酱。 稍微倾斜,它又再次被识别为一只猫。

图片来自the verge

这令人眩晕的识别结果是怎么回事?

据了解,麻省理工大学CSAIL实验室的研究人员创建了一种叫做Expectation Over Transformation (EOT)的算法。该算法可以识别任何带纹理图案的3D模型,然后生成能微妙改变原先纹理的“对抗性图像”。附带对抗性图像的3D物品能够骗过谷歌的图像识别AI,使它认为自己看到的完全是别的东西。

上文提到的那只3D打印乌龟就是所谓“对抗性图像”的一个例子。在人工智能领域,对抗性图像主要被设计用来欺骗机器视觉系统。如果测试时AI系统出现了识别幻象,那就意味着找到了该系统的一个漏洞。这种感觉就像小时候每次考试的出题人一样,因为他们要负责在试卷上给学生挖坑。

产生对抗性示例是评估和改进AI系统鲁棒性(即健壮性)的关键步骤。对抗性图像不会干扰人类,但却很容易骗过人工智能。因为人类在进行视觉识别时可以通过语境或者经验来判断,而AI要基于海量图片进行长时间的深度学习才能识别某个对象。Google就曾动用1.6万个计算机处理器,分析了1000万张图片,才让AI学会识别YouTube视频中的猫。

除了采用对抗性图像之外,MIT的这个研究还有一个创新之处:基于3D物体,因为早期旨在欺骗AI视觉系统的研究主要采用的是2D图像。

实际上,研究人员在物体数学维度的选择(最终采用3D打印物品)上也是有原因的。论文的作者Anish Athalye表示,早期的欺骗实验主要集中在改变图片的像素上,因为AI是通过识别像素来确定看到的是物体还是人的。

但是这种一点一点调整像素的方式没给图片带来明显的变化,而且测试也会受到照明条件或相机质量的限制,攻击实验的效果不太好。基于此,团队决定用新算法生成对抗性图像,并将其附加到3D打印模型上进行测试,这样的话攻击AI识别系统的角度就变多了。

最后研究人员得出结论:AI图像识别系统有时根本不知道自己看到的是什么。

这就很危险了。想象一下,如果一个安全系统使用AI来标记枪支或者炸弹,却将它们识别成了西红柿或者咖啡,再比如自动驾驶汽车上应用了图像识别AI,但它在任何地方看到的都是停车标志……

研究人员此次测试的是Google开发的图像分类器Inception-v3,尽管它还不是一个商业系统,但是也离商业化不远了。而随着AI技术和深度学习系统的普及,来自对抗性图像的攻击就是一个人们必须考虑和解决的实际问题。

“我们的研究表明,对于AI神经网络来说,这种对抗性例子比以前想象的要多很多,”Athalye说。

既然人工智能识别图像的方式出现了问题,那么研究如何防范这种对抗性图像的攻击也就变得很关键。不过让人忧虑的是,虽然攻击测试目前并没有针对其他机器视觉软件进行,但迄今为止,还没有出现任何针对对抗性图像的修补程序。一直致力于推动AI技术发展的大公司们也动作寥寥。

作为对抗性图像的早期关注者,Google此次对the verge提出的 “旗下部署的AI应用是否受到保护”不予置评,但发言人称公司最近已经就这一主题提交了几份研究报告。

Facebook今年7月发表了一份研究报告,称将引入一种名为Houdini的产生对抗性图像的方式来训练AI系统,但目前还没看到后续的消息。

亚马逊AWS通过API销售自己的图像识别AI,称其算法能防御对抗性图像的攻击,而且还在不断改进。据了解,AWS将噪音和负面图像添加到了用于AI训练的数据库中。

未来,AI 将给几乎所有行业带来革命性的改变。普华永道今年6月发布的人工智能相关报告称,到2030年,AI将为世界经济贡献15.7万亿美元。但是MIT的新研究却发现了一个AI识别的明显漏洞,暴露了这一新兴技术存在的巨大安全风险。

眼看AI识别在现实世界中的应用越来越普遍,但在面对对抗性图像的攻击时又显得如此脆弱,如果我们找不到应对这些问题的有效方法,人类为世界经济描绘的15.7万亿的美好蓝图最后可能也就只是一张图了。