算法导致「茧房」「回音室」?学术研究说 NO

来源|方可成的新闻实验室

使用社交媒体以及带有算法推荐功能的资讯类APP,是否会导致我们只看得到自己感兴趣的、认同的内容,进而让大家都活在自己的小世界里,彼此之间难以认同和沟通?从几年前开始,就有不少人担心这种负面后果。

这种担心在2016年左右到达高峰。Facebook创始人扎克伯格在回顾2016年的时候,就将“我们能见到的观点是否足够多元”和“信息是否真实”列为两大主要的挑战——也就是说,这个问题的严重性是和假新闻相仿的。比尔·盖茨也在2017年初接受采访时表示:科技让你和观点相似的人聚在一起,让你看不到不一样的观点,“这个问题比我以及其他很多人预料的都要严重。”

近几年来,学术界也投入了大量的资源研究这一问题,传播学、计算机科学、经济学等学科都有学者在研究相关课题。由于学术出版流程较慢,从2016年左右开始的研究,直到2018年才逐渐大规模发表。

出人意料的是,大部分学术研究的结果都没有支持“社交媒体和算法推荐导致视野变窄”这样一种简单的结论,而是展现出了更加复杂的图景。

概念:“信息茧房”是一个很少被使用的说法

在中文世界里,很多人使用“信息茧房”这一概念来描述社交媒体和算法推荐带来的视野变窄问题。虽然这一概念最初来自西方(翻译自“information cocoon”),但英文学术界其实很少使用这一概念。在谷歌学术搜索“information cocoon”,得到的大多数结果是中文期刊论文的英文摘要。

那么,欧美的研究者们用什么概念来描述这一问题?最常见的是“信息回音室(echo chamber)”,有时被使用的还有“过滤气泡(filter bubble)”。

为什么这两个概念比“信息茧房”要更加适合?首先,“回音室”突出的是“人们听到和自己类似的声音”,也就是所谓“回音”,而“茧房”则只营造了“束缚”的感觉,难以传达“意见同质性”这一特质。其次,“过滤气泡”强调的是社交媒体上的人际关系以及算法推荐功能带来的信息过滤效果,而“茧房”同样不能表达这种含义。

因此,在本文的讨论中,我们也采用“信息回音室”这一概念,而不使用在英文世界中并不流行的所谓“信息茧房”。

我系统性地阅读了近年来发表在一流学术期刊上的针对“信息回音室”和“过滤气泡”效应的学术研究,发现大部分研究都显示:使用社交媒体和算法推荐app的人,并没有明显出现视野变窄的现象,大多数人阅读的内容依然有相当的多样性。我将主要的相关论文列在了文末的参考文献中。

为什么社交媒体和算法推荐并没有导致“信息回音室”现象?从这些论文中,我们大致能总结出几个方面的因素。

因素1:算法是有不同类型的

当人们在讨论“算法导致信息回音室”的时候,往往是将“算法”视作一种单一的、同质性的存在,似乎普天下只有一种算法。实际上,算法有着多种类型,并且在不断的调整、变化中。

明尼苏达大学计算机系的几位研究者,做出了第一篇针对算法推荐系统在用户层面的“过滤气泡”效应的实证研究(参考文献10)。他们使用的是来自电影评分和推荐网站MovieLens的数据。这个网站有点像我们熟悉的豆瓣网,不过只有电影内容。从1997年上线以来,这个网站已经运行了二十余年,用户数超过二十万。

注册使用该网站、对自己看过的电影进行一些评分之后,网站会向你展示“Top Picks For You”,也就是根据算法向你首选推荐的电影,类似于豆瓣的“猜你喜欢”。

这里的重点是:MovieLens所使用的算法叫做item-item collaborative filtering (CF)算法,也就是“基于物品的协同过滤算法”。

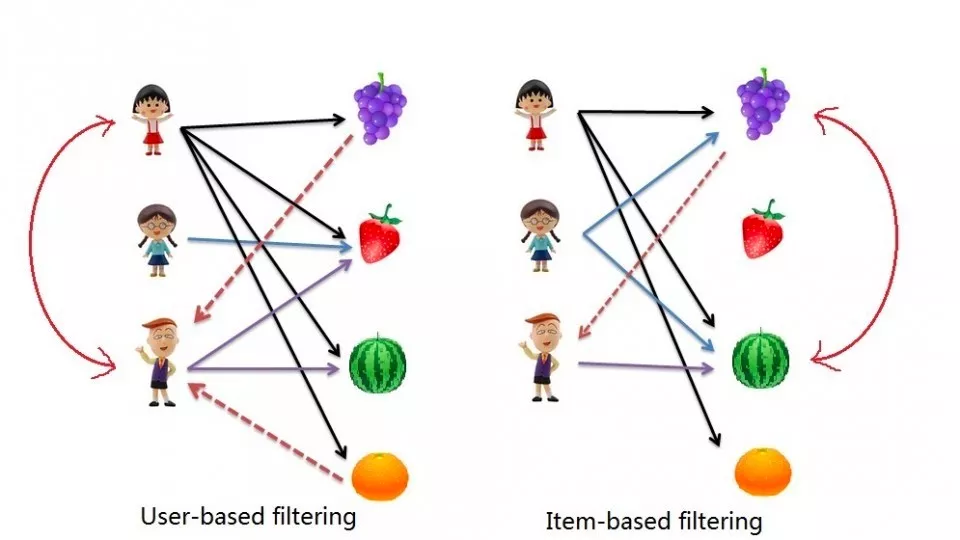

“协同过滤算法”的基本思路是:计算兴趣爱好的相似程度,把东西推荐给“臭味相投”的人。常见的协同过滤算法有两种,一种是基于用户的(user-based),也即计算用户之间的相似性,如果A和B的兴趣相近,那么A喜欢的电影,B也很有可能喜欢。另一种是基于物品的(item-based),也即计算物品之间的相似性,如果电影C和电影D很相似,那么喜欢电影C的人,可能也会喜欢电影D。

协同过滤算法图示:左边是基于用户的算法,右边是基于物品的算法

基于物品的协同过滤算法被广泛使用于各类推荐系统中,包括亚马逊的商品推荐系统。今日头条的算法中也有一个主要部份是协同过滤。

也正因为被广泛使用,因此这篇论文的研究者认为,他们的研究结果可以推广到电影推荐之外的其他算法推荐系统中。

研究者们选取了21个月的数据。他们将用户分为两组,一组是根据算法推荐选择电影观看的,叫做“跟随组”;另一组是不理会算法推荐的电影,叫做“不理会组”。他们发现:算法向“跟随组”推荐的电影,一直要比向“不理会组”推荐的电影更加多元化。也就是说,根据算法的推荐选择电影,然后进行打分,其实会让算法更好地学习到你的喜好,并且给你推荐更多样的片子;而如果不根据算法的推荐来看电影和打分,反而会让算法给你推荐更窄的片子。看起来,这种协同过滤算法其实能够帮助用户打开视野,探索更多样的内容。

以上计算的是算法展示的电影,那么,用户们实际上消费的电影是不是真的变得窄化了呢?分析显示:是的,大家看的电影多样性下降了。不过,令人吃惊的是:“跟随组”的下降幅度其实不大(从26.67到26.3),而“不理会组”的多样性下降却比较大(从26.59到25.86)。也就是说,在不使用算法推荐的情况下,用户的视野反而变窄得更快。

研究者指出:基于内容的推荐算法可能会比较严重地窄化用户的视野,但协同过滤算法则不会,因为它依据的不是你之前看了什么,而是和你相似的其他人喜欢什么,这有助于向你推荐你自己本不会接触到的更多样内容。

因素2:我们的社会关系是复杂的

在大多数使用了算法推荐的平台上,也都融入了社交关系的元素。例如,Facebook的信息流(news feed),虽然是基于算法排序的,但同时也是被社交关系决定的——算法决定的是信息呈现的次序,但并不能决定有哪些信息会被排序,因为那取决于你有哪些好友,关注了哪些专页(page,一个专页类似于一个微信公号)。今日头条等资讯类APP也是一样,你可以在上面关注人和号,然后你关注的人阅读和分享的内容进一步影响你能读到的内容。

2018年发表于学术期刊《Digital Journalism》的一篇论文(参考文献2),研究了Facebook用户们是否生存在信息回音室之中。两位研究者获取了1000名丹麦Facebook用户在14天内的时间线数据。

研究者们通过两种方式来测量用户是否处在信息回音室之中。第一种方式,是看大家在Facebook上分享的外部链接(比如一则指向媒体网站的新闻报道)有多相似,如果一群人分享的链接基本一致,就可以认为他们都生活在同一个回音室之中。数据分析发现:以分享的外部链接来测量的话,只有少于10%的参与者可以被认为处在回音室或者过滤气泡之中。

第二种方式,是看大家在Facebook上撰写发布的内容是否相似。研究者们使用了计算机自动分析文本主题模型的方法,计算每位用户发布内容的相似性。分析结果显示,以这种方式计算的话,少于27.8%的用户生活在Facebook的回音室或过滤气泡中。

这两个数字都大大低于预期,说明算法排序的社交媒体平台上并不存在很严重的回音室现象。但这篇论文更有意思的发现是:要预测一个用户是否生活在回音室之中,最佳的指标是用户个人的“社会性”。具体来说,如果一个用户的好友数越少,关注的专页越少,加入的群组越少,那么他(她)就越有可能身处回音室之中。反之,一个广结好友、关注了大量专页的用户,生活在回音室之中的机率是很小的。

这表明,即便是在算法推荐的平台上,用户自身的行为对其接触到的信息是否多元,也有着非常重要的影响。我们在算法推荐平台上看到的内容,从来就不是单纯被机器决定的。

因素3:我们并非只读特定内容的生物

“社交媒体和算法推荐导致信息回音室”这一判断成立的一个重要前提是:我们只会点击那些我们熟悉的、赞同的内容,不断让机器加深对我们的印象:原来他们只喜欢看这些!

但在现实中,这个前提是过于简化的,乃至是错误的,因为我们远不是那么机械、呆板的动物,我们也很清楚:只读特定内容,并不是一件对我们有利的事情。

从认知心理学的角度来说,人们确实有“确认偏见”(confirmation bias),也即更愿意相信自己已经认同的内容。但是,人们的认知偏见中也包括这样的成分:我们更容易注意到那些奇特的、超出我们预料的内容。我们都有这样的体验:看到一个意想不到的标题时,会更忍不住去点击,想看看究竟。这也就导致了,即便仅仅根据我们的点击行为来推荐内容,也不大可能走进一个越来越窄的死胡同。

从成本和收益的经济学角度来说,那些我们不熟悉的、意料之外的内容,往往对我们更有帮助,因为它们可能会补上我们的知识盲区,提醒我们注意那些有意无意被忽略掉的内容。阅读更多元的内容,会让我们收益更多。因此,如果你是一个带着提升自我的目的去阅读的人,往往也更不会只去点击那些兴趣之内、预期之内的内容。

在2018年发表于学术期刊《Information, Communication & Society》的一篇论文中(参考文献4),研究者们发现:总体而言,人们对于信息回音室效应的担心是被夸大了的。尤其是,那些对政治感兴趣的读者,实际上会受到好奇心的驱使,去消费更多样的内容,视野并不会受限。

实际上,我们所面对的是一个选择极大丰富的媒介环境。在这样的环境下,人们出于各种各样的原因,有动力去获得多样的内容。在这样的基础之上,基于阅读行为的算法推荐更不太可能限制住人们的视野。

因素4:我们喜欢夸大媒体的负面影响

绝大部分学术研究之所以没有发现信息回音室效应,可能还有一个原因,那就是我们“心口不一”:明明实际上看的是很多样的内容,嘴上却喜欢说自己被社交媒体和算法限制住了视野,喜欢抱怨媒体的负面影响。这就是奈特基金会2018年的一篇研究报告(参考文献8)发现的:我们没有陷入到过滤气泡中,但是我们却喜欢表现得好像自己陷入其中。

在这则研究中,研究者找来一群受试者,先让这群受试者报告他们最近阅读或者观看了哪些媒体;同时,研究者又通过网页浏览历史跟踪这些受试者实际上消费了哪些媒体。简单来说就是听其言,观其行。先看受试者自己怎么说,再看他们实际上怎么做,然后比较两者之间的差异。

结果显示:受试者向研究人员过度报告了自己常看的一些媒体(通常是和自己的态度相近的媒体),而没有报告另一些自己看过的媒体(和自己的意见相反的媒体)。举个例子,在美国的语境下,如果你是一个自由派,你平常可能既看自由派的媒体,也接触到了保守派的媒体,但是在向研究人员报告自己的媒体消费情况时,你只报告了自由派媒体,而隐藏了自己消费的保守派媒体。在保守派身上,类似的情况同样成立,他们告诉研究人员他们最主要的信息来源是保守派的福克斯新闻,但是研究人员从他们的网页浏览记录中发现,他们也会看自由派的CNN和《纽约时报》。

为什么受试者会过度报告其中的一些媒体而隐瞒另一些媒体?该研究认为,这是因为人们越来越把自己的媒介偏好和媒介消费当作是一种政治表达和政治宣示的手段,即:我看什么媒体代表了我是什么样的人,以及我相信什么。这种现象,推广到其他国家的其他语境下同样也成立——比如,一些之前喜欢看咪蒙的人,可能嘴上也号称自己从来不看咪蒙,因为看咪蒙被视为一种身份象征。

这也是为什么绝大多数针对信息回音室现象的学术研究,都不会直接去问用户:你觉得自己生活在算法导致的信息回音室中吗?人其实很难正确回忆总结自己的行为,往往是根据自己的信念来对事实进行扭曲和粉饰。所以,人们对信息回音室现象的批判,在一定程度上可能是因为“我觉得有信息回音室,我不喜欢算法这种东西,所以我认为自己阅读的内容是同质的”——而实际上,我们的视野并没有明显缩窄。

结语:影响视野宽度的三个层面

总结关于社交媒体和算法推荐是否导致信息回音室现象的学术研究,我们可以发现,影响我们阅读视野的其实有三个层面的因素:个体、社会和技术。

在个体层面,我们有着多样的阅读动机,受到各种认知偏见的影响,可能倾向于点击某些特定类型的内容,但绝不仅仅局限于自己认同的那些。

在社会层面,我们在大多数APP上都存在着社交关系,以及主动选择关注的帐号,这些都对我们能接触到的内容产生重要影响。一个在APP上拥有丰富社交关系的人,不太可能陷入狭窄的视野当中。

在技术层面,算法推荐有着不同的类型、不同的原理。被广泛使用的协同过滤算法,实际上并不会缩减人们的视野,甚至有时能打开更大的世界。

在这些因素的共同作用下,社交媒体和算法推荐并未形成明显的信息回音室和过滤气泡效应。退一万步而言,即便我们依然担忧技术可能带来的负面影响,我们也应该认识到:只要我们在个体层面保持着对多样信息的好奇心和求知欲,在社会层面维持更加多元的社交关系,我们就有足够的能力去抵消这种可能的负面影响。很多时候,真正把心灵关闭、把视野缩窄的不是算法、不是他人,而是我们自己。

主要参考文献:

Auxier, B. E., & Vitak, J. (2019). Factors Motivating Customization and Echo Chamber Creation Within Digital News Environments. Social Media+ Society, 5(2), 1-13.

Bechmann, A., & Nielbo, K. L. (2018). Are We Exposed to the Same “News” in the News Feed? An empirical analysis of filter bubbles as information similarity for Danish Facebook users. Digital journalism, 6(8), 990-1002.

Cardenal, A. S., Aguilar-Paredes, C., Cristancho, C., & Majó-Vázquez, S. (2019). Echo-chambers in online news consumption: Evidence from survey and navigation data in Spain. European Journal of Communication, 1-17.

Dubois, E., & Blank, G. (2018). The echo chamber is overstated: the moderating effect of political interest and diverse media. Information, Communication & Society, 21(5), 729-745.

Flaxman, S., Goel, S., & Rao, J. M. (2016). Filter bubbles, echo chambers, and online news consumption. Public opinion quarterly, 80(S1), 298-320.

Fletcher, R., & Nielsen, R. K. (2018). Are people incidentally exposed to news on social media? A comparative analysis. New media & society, 20(7), 2450-2468.

Gentzkow, M., & Shapiro, J. M. (2011). Ideological segregation online and offline. The Quarterly Journal of Economics, 126(4), 1799-1839.

Grossman, M. (2018). Partisan Media and Political Distrust. Knight Foundation.

Nguyen, A., & Vu, H. T. (2019). Testing popular news discourse on the “echo chamber” effect: Does political polarisation occur among those relying on social media as their primary politics news source?. First Monday, 24(5).

Nguyen, T. T., Hui, P. M., Harper, F. M., Terveen, L., & Konstan, J. A. (2014, April). Exploring the filter bubble: the effect of using recommender systems on content diversity. In Proceedings of the 23rd international conference on World wide web (pp. 677-686). ACM.

Zuiderveen Borgesius, F., Trilling, D., Möller, J., Bodó, B., De Vreese, C. H., & Helberger, N. (2016). Should we worry about filter bubbles?. Internet Policy Review. Journal on Internet Regulation, 5(1).