用AI让课本里的古人动起来:兵马俑活了,黛玉却被美了颜?

编者按:本文来自微信公众号“大数据文摘”(ID:BigDataDigest),作者:刘俊寰,36氪经授权发布。

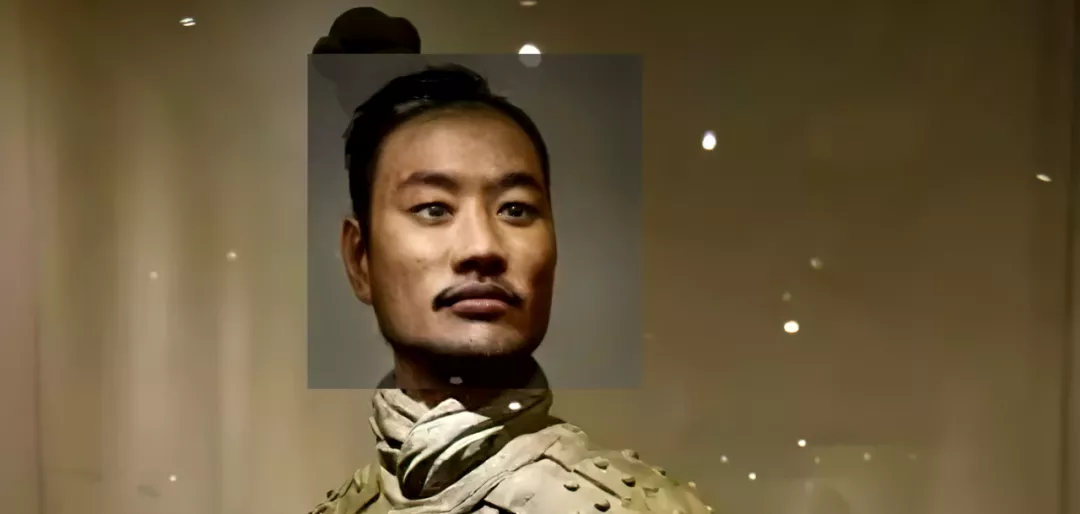

看到下图这位中年男士,你会不会觉得有种“在哪见过”的似曾相识感?

没错,你肯定见过他。

要是文摘菌告诉你,这是兵马俑的“现代版面貌”,你信吗?

可还别不信,在微博博主“大谷Spitzer”的最新作品中,他复现了各种老雕塑、人物画像的“现代版”,从上边的兵马俑跪俑、到大禹治水图和林黛玉画像,还让他们都活了过来。

是的,这次大谷没有修复老视频,跑去修复“古人脸”去了。

那么我们还是先来看看兵马俑小哥到底是怎么被还原的:

除此之外,还有“现代版“林黛玉,这一颦一笑,真是太真实动人了:

甚至徐悲鸿,眉宇间还有一丝少年的青涩:

网友们纷纷表示,“大谷玩得越来越有意思了”,也有人说,想看圣人、神仙和四大美女。

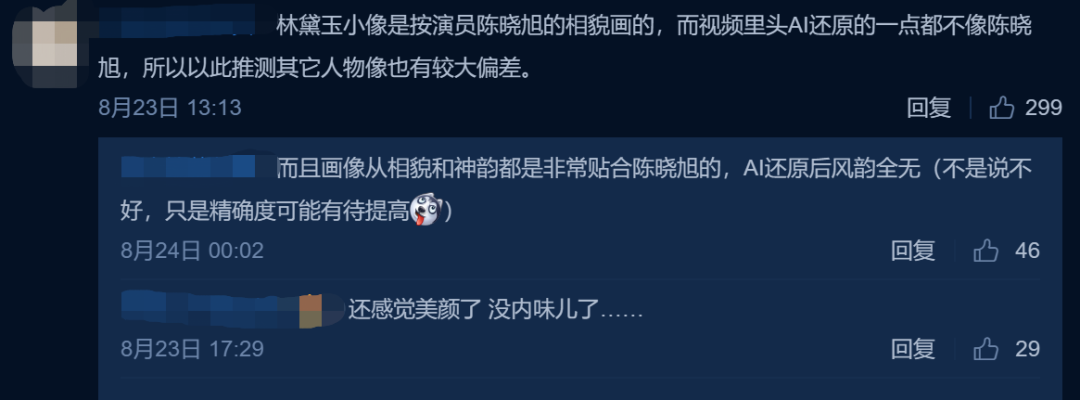

不过,眼尖的网友也发现,AI还原的人物存在较大的偏差,“感觉美颜了,没内味儿了”。

甚至还有人表示,以后抓通缉犯就可以公布AI动图了。

文摘菌在第一时间再次联系到了这位正在“用技术为社会做一些有意义的事情”的作者,来看看大谷这次又为大家带来了哪些更新的内容吧。

不断试错:黛玉被美颜,大禹被换了发型?

以兵马俑为例,我们也先跟随大谷,简单了解一下整个项目的制作流程。

根据大谷介绍,这次他使用的AI项目包括Artbreeder、Stylegan-Art、Realistic-Neural-Talking-Head-Models以及First-Order-Model,当然用于补帧和提高分辨率的DAIN和Topaz Lab的AI也是不能少的。

第一步,需要从兵马俑中截取出头部的方形照片。

为了更好地让系统识别,大谷用PS简单给“金属质感”的兵马俑先上了皮肤的颜色,然后利用Artbreeder进行人脸识别,输出一张写实风格的人脸,再在Artbreeder内调整一些细节,用PS做最后的微调,最后再导入First-Order-Model,就生成了我们所看到的动态图。

看似很简单就完成了,但真正实施起来,因为是第一次做这种项目,每一步都要进行多次试错。

首先,第一步照片的选择上就有很大的问题。

可能大家也能猜到,正脸的人脸识别效果当然是最好的。除此之外,人脸是否在整个画面中也会影响最后的效果,比如大家可以对比一下梦露和黛玉,梦露的头发有部分在画面外,这就会导致生成的动图看上去像是头发黏在了背景上,甚至有时候分成了两层。

眼尖的同学可能也发现了,在大禹治水的图中,背景是全黑的,这其实也是大谷做的一个小调整。因为本身人物戴了个帽子,但是Artbreeder把帽子识别成了头发,如果在这个基础上直接进行后续操作的话,看上去就像是脑袋被削掉了一块,大谷就干脆把背景换成了纯黑,只保留了脸部。

这样做出来的动图肯定也还有一些瑕疵。

就像上文提到,有人在微博下方评论到,“没内味儿了”,黛玉的效果图看上去像是被美颜了一样。

大谷表示,这其实是由于First-Order-Model输出图像大小只有256×256,像素太低,输出后他用Topaz Lab提升了一下分辨率。

如果只生成静态图的话,可以看到很多细节,甚至毛孔都清晰可见,但是用First-Order-Model转动态后,像素就太低了,后期不得不用其他的AI进行补帧和分辨率提升。

除此之外,因为这次的项目取材范围很广,涉及到了不同年龄层和不同的年代,除了黛玉,老年人的“美颜效果”就还蛮明显的。

这也正是需要不断去试的原因所在。不过大谷表示,一些失败的案例还挺有趣的,下次会整理一个失败合集,附在视频最后。

这里我们也可以先剧透一下,一睹失败的案例到底能失败成什么样子?

大谷表示,这也是因为这次使用的是一个pre-trained模型,如果要彻底解决低像素输出问题,需要额外训练一个2048的模型。

据了解,这次的项目“断断续续做了两个月”,不过,有了第一次的经验,大谷表示,下次准备自己录点表情去做,这样能省去找合适的图片的问题,同时他最近也看了很多这类技术的视频和帖子,可能在修改代码后,能够让这些技术更好地贴合目前的流程,下次视频或许就有更好的结果了。

修复神器First-Order-Model,动动手指就能让人“活”起来

这次的项目,大谷仍然主要参考了海外技术博主Denis Shiryaev,不过在实际操作中还是有一些差别,比如Shiryaev主要处理的是西方油画角色,大谷主要针对东方历史人物进行了修复处理。

不过,他们的大体流程是类似的,用到的工具也都主要是First-Order-Model。

说到First-Order-Model,可不要以为这个系统只能做脸部动态转换,大谷介绍道,First-Order-Model可以生成打太极的动作,还支持五官局部的替换,比如你可以把钢铁侠的胡子换到特朗普脸上。

其实这项技术已经在国外很火了,但大家更多利用到的是GoogleColabNotebook上的简化版模板,不需要写代码,只需要按按钮就可以运行。

而且国外的网友往往都是把一些明星唱歌的片段替换到各种历史人物、电影角色、游戏角色上去。

除此之外,大谷说到,First-Order-Model还可以支持服装模特的转化,不过这个功能更像是处于婴儿阶段,没有特别成熟,大家可以看下图自行体会一下:

“现在的人工智能技术激发了人们的创造力。”大谷感叹道。

“不会拘泥于某一方面,也不会说突然就不做了,(各个方面)都会去做一做,主要是想把中国文化用现代技术结合起来,分享给大家,给大家带来独特的感受。”

大谷的AI修复系列视频

说到大谷利用AI修复老视频,相信大家一定都不会陌生了。

5月,系列修复视频第一弹上线,迅速在互联网上引起热议。

当时,大谷主要针对画面进行了修复,整个过程分为补帧、扩分辨率、上色三个环节,虽然效果十分经验,但还是存在不足,比如画面中的颜色会出现跳来跳去的情况,红绿服装等方面的真实性也有待商榷。

随后,7月,大谷带来了老北京修复视频的第二弹,这次他把目光聚焦于修复老视频中的声音,还原了近百年前最真实的京片子。

有了上次的经验,这次画面上的效果更好了,大谷表示,这次主要使用到的是Topaz和DeepRemaster,前者在边缘的处理上更加平滑,后者在静帧和平移的画面修复上的效果会更好。

针对第二次的修复效果,大谷本人也十分表示满意,不过可以看出,其实在画面颜色上还存在部分闪烁,分辨率也还有提升的空间。

在声音的修复上,视频本身的录音效果就已经足够好,他主要利用到的是AE和PR里的去噪功能,但去噪主要针对以低频为主的声音,处理后整体的声音效果听上去就会比较“干”,所以在去噪后,大谷还加入了一些混响,让声音听上去更自然。

而在盲人演奏的音乐部分,大谷主要加了一些混响,没有再做过多处理,他表示,音乐本身的混声就比较严重了,如果再去噪的话,低音乐器的声音就会被掩盖住。

然后就是在8月初,大谷从老北京“转战”到了老上海,为我们带来了百年前老上海的时装秀表演,视频中,三位1929年的上海小姐姐现场为你讲解当时上海的流行时尚趋势。

在这次的技术实现上,大谷表示,他主要利用的也是DAIN、DeOldify、Topaz和DeepRemaster,对原片进行了上色、补帧、扩大分辨率等操作。

正如在最新一期视频下方有网友留言表示,“大谷玩得越来越有意思了”,AI技术本身存在无限可能,再加上大谷勇于探索的精神,相信他还会为我们带来更多有趣的作品。