霍金、马斯克警告:AI是人类最大的威胁

本文来自微信公众号“笔记侠”(ID:Notesman),作者:Pieter Abbeel,36氪经授权发布。

人工智能

先思考:

人工智能如何学习?

未来的人工智能,将会如何发展?

2015年,AI进入大众视野。

霍金警告:人工智能可能毁灭人类。

埃隆·马斯克警告:AI是人类文明面临的最大风险。然而就在同年,他却与诸多科技巨头投资10亿美元,用于人工智能研发。

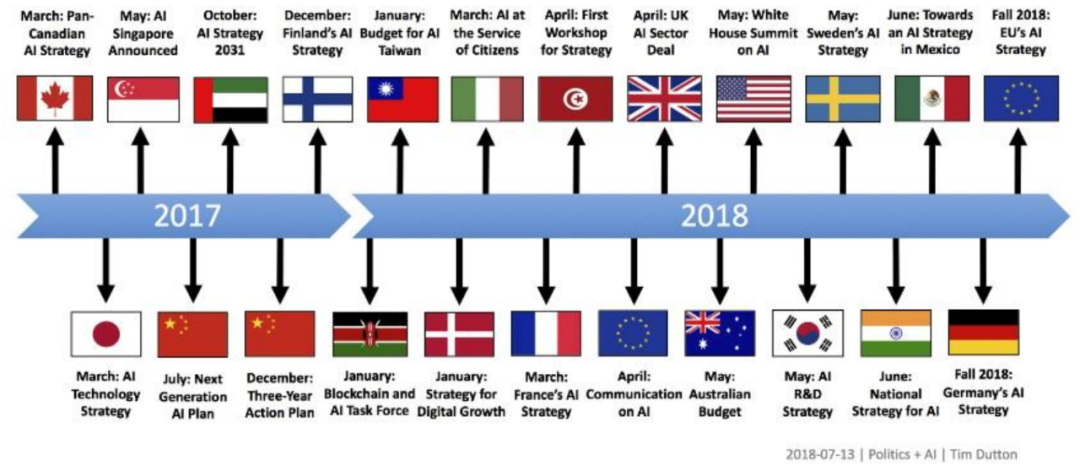

2017年,各国政府开始关注人工智能。

例如普京在俄罗斯“知识节”上对孩子们说:“得AI者得天下”。

如迅雷之势,多国政府已忙着在AI领域进行战略部署。

同频落地的AI初创企业,数量也在不断上升中。

例如谷歌斥资逾5亿美元,收购人工智能初创企业DeepMind。

毋庸质疑,投资界也与此实时共振中。

据数据分析,AI初创企业融资交易量,绝大多数都流向中国。而且,全球最具价值的AI初创企业,已在中国闪耀发光。

不否认AI存在一定的光环效应,但究其本质仍具有变革性和根本性的进步。

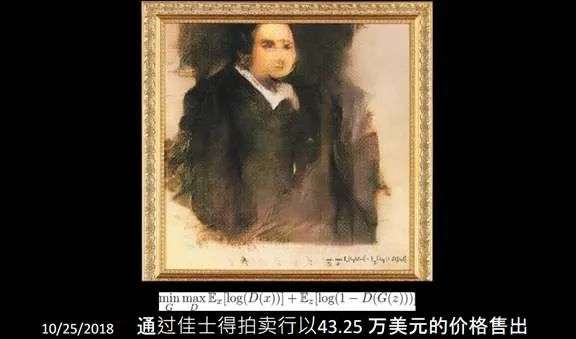

与其他研究学科相比,AI领域从研究到商业转变,几个月就能实现。也就是几个月前还在实验室里,转眼就可以成为商业产品。比如人类第一幅由AI出品的画作,在佳士得拍卖行,就以43.25万美元的价值售出。

今天就以下几个主题,与大家分享目前AI的一些动态:

有监督的深度学习

无监督的深度学习

深度强化学习

应用于科学与工程学领域

未来展望

一、AI的基础:有监督的深度学习

1.AI的构建难点

① 计算机视觉

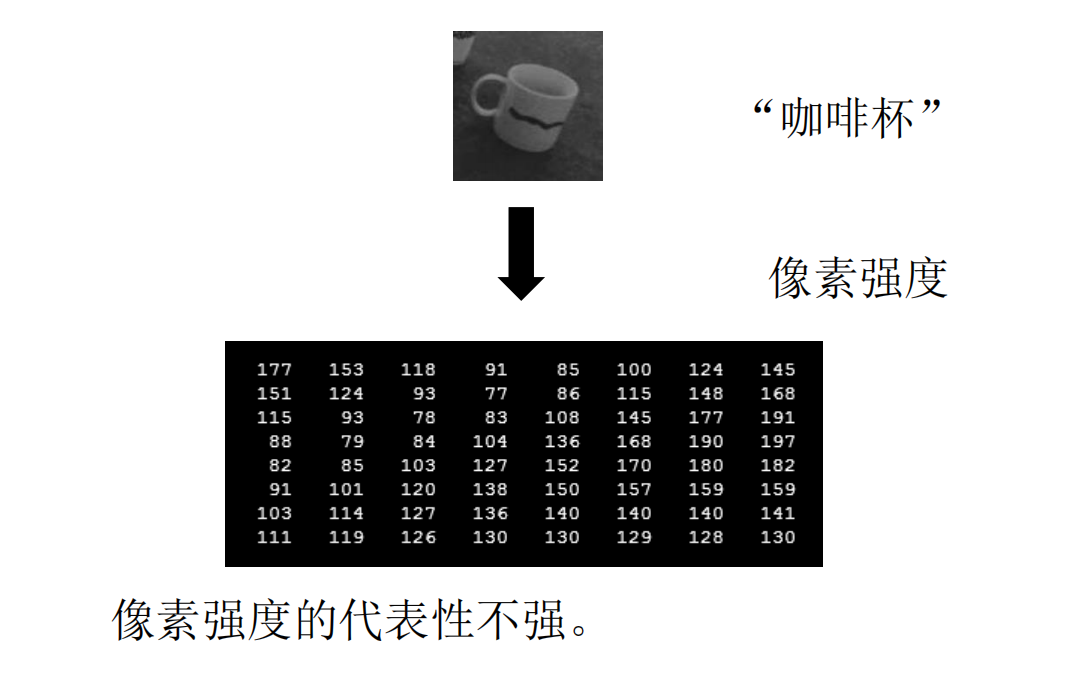

让AI自动识别出咖啡杯,就需要识别另一张图像,需要计算机设定程序。我们看到是照片,它看到的是像素强度,看东西方式跟人类的肉眼完全不一样。所以,需要考虑如何写这个程序,让计算机能够识别出这是一只咖啡杯。

技术人员曾努力做过很多尝试,但是没有人能够写出一套程序,让计算机能成功识别出一条人行道,一辆汽车、一只咖啡杯。

后来,意识到也许该换一套方式,而不是直接写程序。训练计算机学会自动识别的方法,事实证明确实是一个可操作的成功之道。

② 多层神经网络

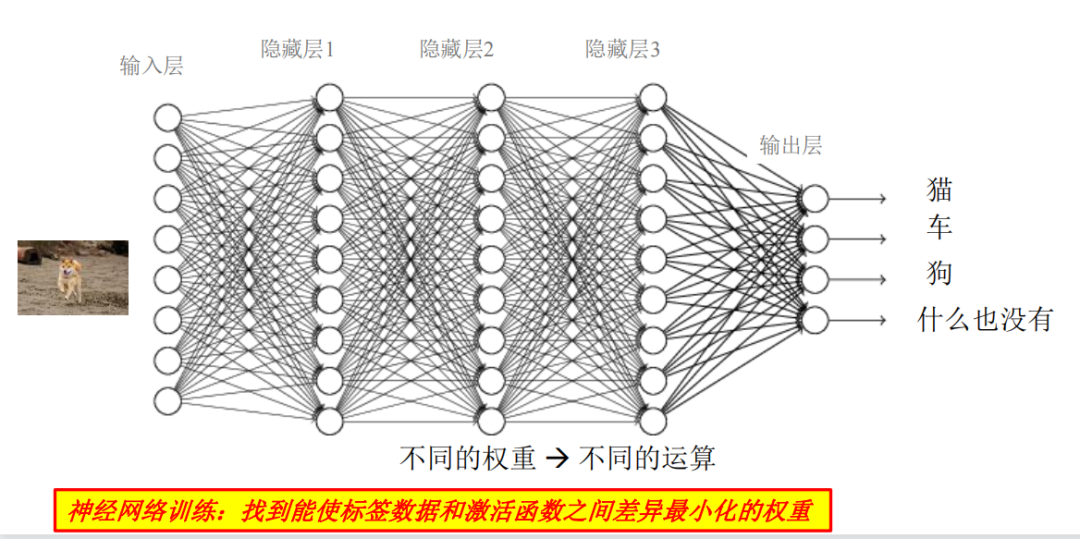

运用神经网络学习,处理一幅图像。

识别一只狗,需要经过很多层分析。虽然我们无法确切知道大脑究竟是怎样工作的,但能了解到大脑里面包含很多神经元,神经元是互相沟通的,而且中间存在着大量的隐藏工作。大脑怎么做决策,就是神经元之间的沟通和互动,以及判断哪些有联系,哪些没有联系以及联系的强度。

所以,最左边是第一层神经元,当拿到初始图像,就做开始分析,再传给下一层,下一层做计算或分析,再层层传递下去,直到最后一层出决策。

联系强度会决定神经元,看到一幅图像时的处理方式。在AI系统中,应用的神经网络相当大。可能是几千万甚至上十亿,甚至比十亿还多的神经元联接数量。

③ 神经网络学习图像识别

数据,就是神经元网络自动处理背后的秘诀。

当拿到数据,把是车、猫、狗等照片传递给系统。通过不断试错的方式训练,直到系统能够自动识别,并且还能够预测出以前没有看到过的照片。

④ 错误率

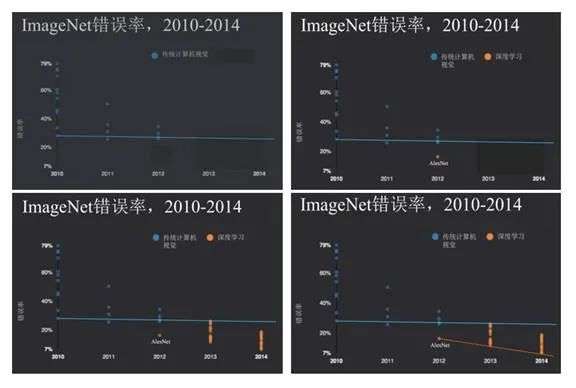

不同神经元网络之间,不同AI之间的PK。例如斯坦福大学的一位美国教授发起了一项竞赛,当把计算机程序传给教授和他的同事们,他们会用这些程序做一些图像处理,不会告诉你具体的图像,但会告诉你错误率。

可以看到在2010年的第一轮竞赛中,传统计算机视觉系统的最好参选者是30%错误率,2011年没有太大改善。但是,到了2012年就发生了比较大的变化,参选者是多伦多大学的亨特,他甚至因此拿到了图灵奖。

如果能够迅速拿到海量数据做分析,看到的结果将相差很大,错误率也会大大减少。

⑤ MS COCO图像字幕挑战赛

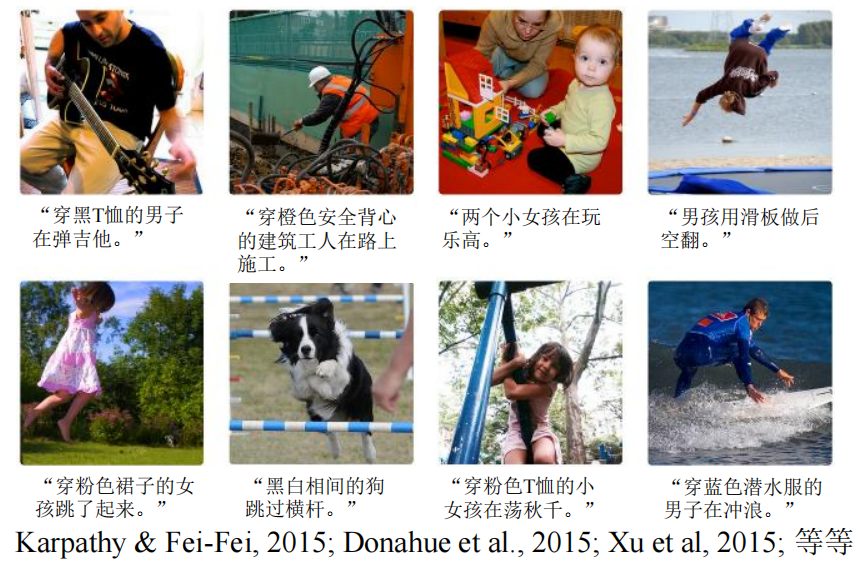

具体的做法是通过事例训练神经网络,而不是只投入和产出。用一句话来述具体图像,经过培训之后,进行下一个例子时,会自动找到相应图像。

例如输入网络图像,就会自动生成“穿黑T恤的男人在弹吉他”或“穿粉色裙子的女孩跳了起来”。

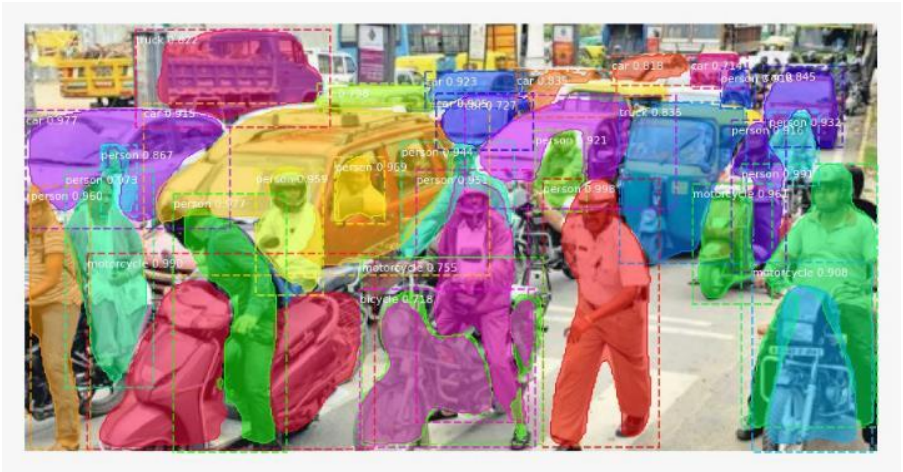

⑥ 图像分割

也就是只要输入图像,就会自动转换出文字,也就是根据每一个图像象素可以分析出,这是一个行人、一辆摩托车还是一辆轿车等等场景主题。因此,图像分割学习,对于自动驾驶技术非常重要。

⑦ 视觉 + 机器翻译

另外,人脸识别、语音识别和机器翻译只要有足够多的训练以及数据源,根据相关的例子就能找到规律,可以把声音与文字联接识别出来,或是翻译出新的句子。

更进一步,把视觉和机器识别结合起来。例如在街角拍一张照片可以直接转换成文字,而且是被翻译成另外一种语言的文字。

2.编程范式正在发生改变

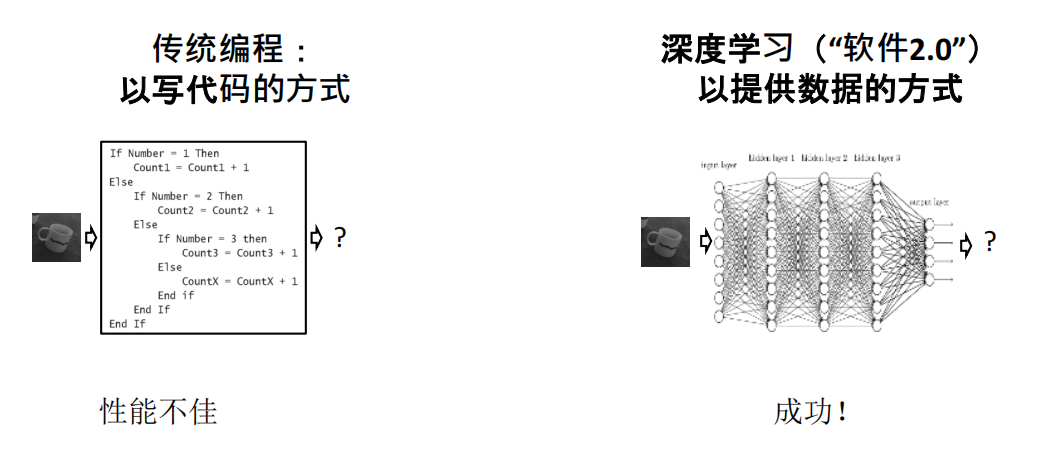

① 传统编程VS 人工智能

传统编程主要是通过写代码的方式,已持续了五六十年。不同的是,人工智能是以深度学习提供数据的方式。就是用数据培训神经网络,通过数据培训程序就会成为神经网络本身,或者说神经网络本身就成为了程序本身。

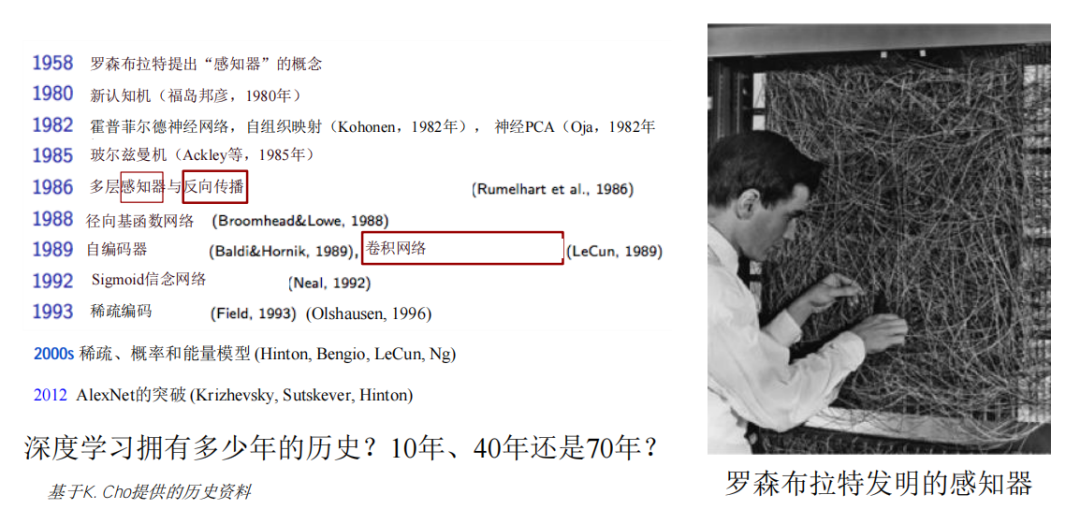

② 发展史

今天如此追捧迎的神经网络,实际上在60年前就已发明。

图中Rosenblatt(罗森布拉特)在建立神经网络,50年代他就能编织网络,对神经网络进行培训。知识网络,30年前就已提出来。此时此刻火爆的神经网络学习,60年前却无人问津。

③ 数据+算力+创新力

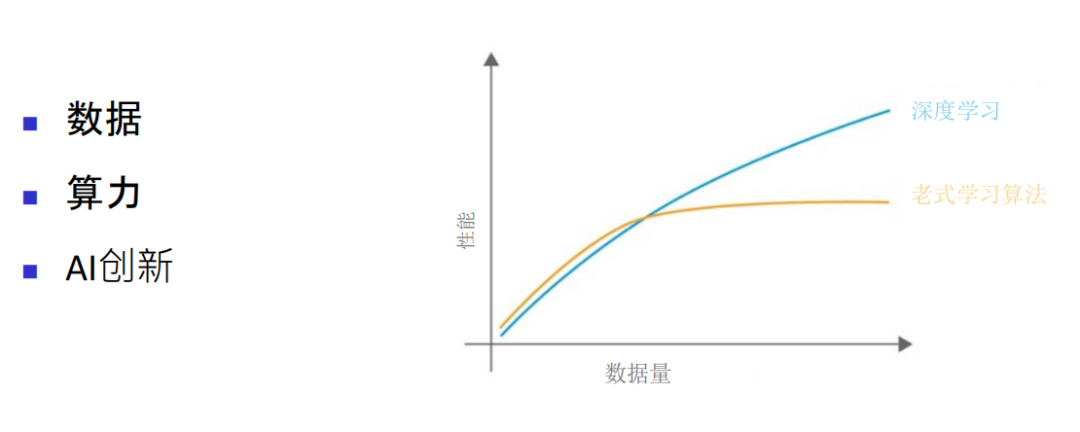

如果看一下神经网络表现,就可以了解到培训网络的性能越来越好。即数据越来越多,性能就越来越好。数据少的时候看不出效果,当2012年突破一个临界点,开始处理足够多的数据时,神经网络开始发光。

数据量非常重要,计算能力也得并驾齐驱,才能够实现数据培训神经网络。另外,还有一些创新,也是基于足够多的数据和计算能力才能完成。

3.自动预测的重要性

除了图像识别、语音识别、机器翻译,用新的强大的AI工具还能做什么?实际上,除了通过给它提供范例的方式,还可以用人工智能改善任何事情,包括公司运营。

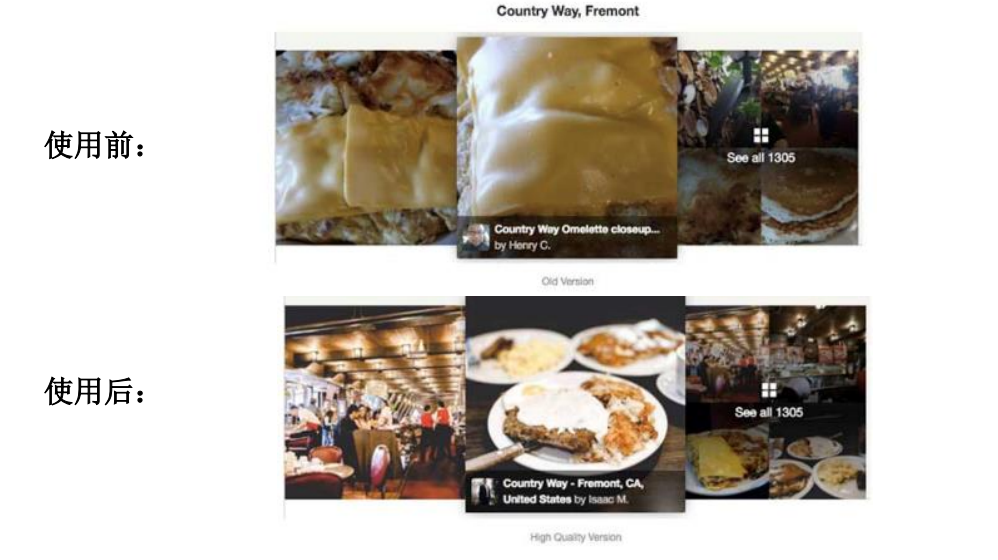

① 点评

例如美国最大点评网站Yelp,去餐厅后可以拍照片给餐厅打分。

餐前,可以浏览别人上传的照片,选择中意的餐馆。

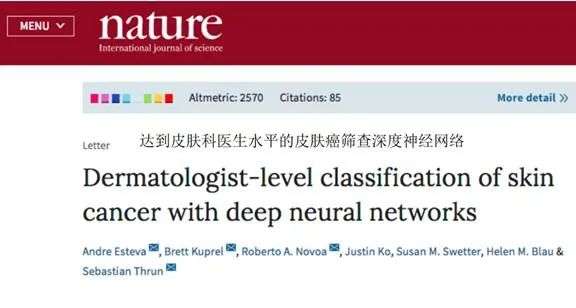

② 医药

在医药领域也是非常重要,比如当你皮肤上有一个棕色点,可以用AI系统筛查皮肤癌的可能性。

神经网络跟医生一样,经过培训之后,也可以学习并分析X光扫描结果。在X光上面的显示有没有肺炎的可能,对医生来讲是并不轻松的学习过程,而神经网络就不难完成。

③ 能源

预测天气的规律,神经网络可以学习以预测风的方向和规律,据此在适当的时间切换风力发电或其他能源的供给,大概会节约30%的成本。而之前需要花很长时间,才能够非常精准地知道什么时候该切换。

④ 商业

在银行业,也有诸多案例:

通过培训神经网络,电商平台可以预测人们预定的东西和时间,仓库就可以据此信息快速配发货。

银行系统可以预测一些贷款是否存在欺诈等行为。还有一些人申请贷款,AI会预测对方是否能按时还清。

以上,都是有监督的深度学习。需要用非常大且非常深度的神经网络来培训它,用各种例子培训,有投入又有产出。

4.有监督的深度学习战略

① 机会

投入和产出结合培训神经网络,可以做预测。一旦完成培训有新的投入之后就可以预测新的产出,无论是图像还是语言、文字,都可以自动识别。

② 操作系统

建立一个系统需要带注释的数据、一定算力、一个开放式问题、AI专家或AI服务外包供应商做。也就是说,不需要打造自己的团队,可以利用他人的服务,就可以帮助需要解决的问题。

③ 前瞻性

可以积极探索预测的价值,要用更加易于访问的格式记录数据,数据需要调取的时候更加容易调出,同时建立数据飞轮。

用AI做产品,需要更多数据,监督改善系统循环往复,就是数据飞轮。不断随着时间的推移改善系统,使得竞争对手很难超越。

④ AI API供应商

AI服务商可以做API(Application Programming Interface,应用程序接口)调动需求、图像识别、语言理解等,无须自己做,云服务就可以帮助完成。问题是否相匹配,往往取决于普遍性还是特殊性。

比如可以用于人脸识别的API、用于情感分析的API等需求调用,但是无法用于专业医学分析的API。当专业性要求非常高时,必须有相应的数据组合解决方案。

评估AI API供应商时,要能认识到没有完美的AI识别系统,同时也必须清楚自己对性能的需求。比如对错误容忍度是多少,是99%还是99.8%?

用AI于无人驾驶汽车领域,需要车里绝对的安全,如果做不到,实际上还是得有驾驶员。

有时供应商宣传的AI API性能与你使用的情况并不一定相符。现代AI系统经数据训练而得,需要了解其与你自己数据的一致度。例如一个人脸识别系统是基于亚洲面孔做的培训,测试时用白人面孔,就会有问题。

所以必须确保用于培训AI的数据,跟你自己数据相匹配,跟你的问题相匹配。

高度一致→ 可能非常适合(认定为优质供应商)

一致度低→ 可能不适合 → 需聘请供应商作顾问或内部解决

另外,数据= Money。数据源不能直接扔给供应商做,务必始终掌握自有数据的所有权(如果供应商使用你的数据),以保障数据的可移植性。

二、使用更少标签:无监督的深度学习

1.无监督的深度学习

无监督的深度学习最有可能使用,但是成本高又投入大。如何省时、省钱、又省力的实现,是如今被关注的重点。

也许AI可以跟人一样,就是让神经网络像小婴儿似的,通过广泛看世界来学习,而不是把所有的标签范例都给它看。

无监督的深度学习就是用更少的标签来学习。

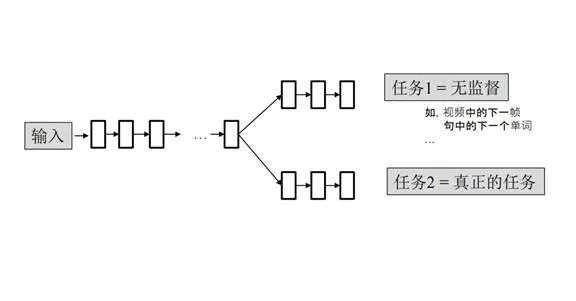

例如一个输入,小孩子还在看图片,神经网络处理时,任务1就进入视频下一帧,并且可以预测下一个会看到什么。虽然任务较难,需要很多学习,但是这项任务不需要给任何数据加标签,通过大量视频让网络预测下一帧是什么,需要使用无限多互联网上的数据。任务2真正的任务,比如看马路上现在有没有车或是往来实物。

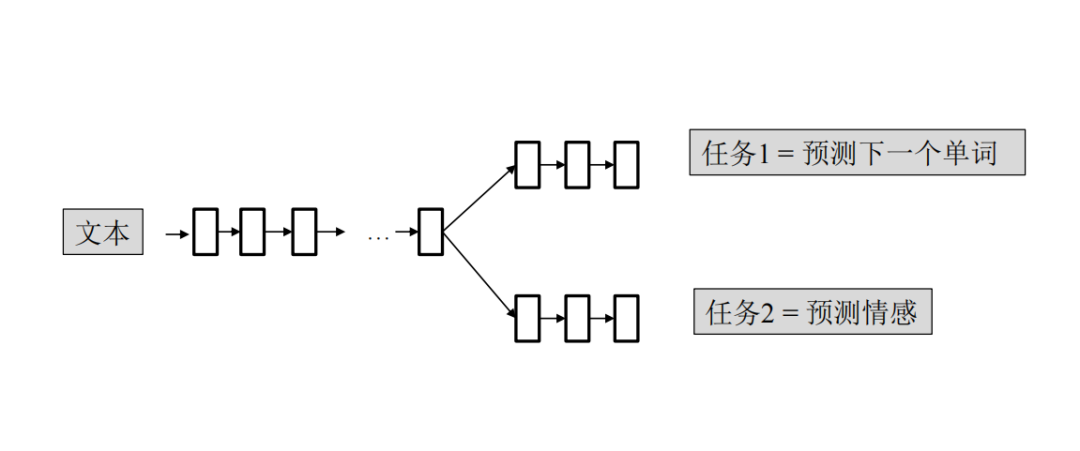

文本也可以这样处理。

比如一句话或一段文章,任务1是预测下一个单词。在互联网上有无限多数据,可以自行下载并预测,无需人的监督。

任务2是预测情感,是OpenAIGPT-2的算法,也是一个神经网络,主要针对文字和文本预测。首先给出一个提示,算法会告诉它接下来会干什么,接下来又会发生什么,类似互联网上常见的文章套路,不需要死记硬背每一个例子。

做了这样一个训练以后,还可以进一步,给它带一定正面或是负面的情感。例如这个是书评,书写得非常棒,但是电影拍得很烂等等,带有强烈情感色彩。

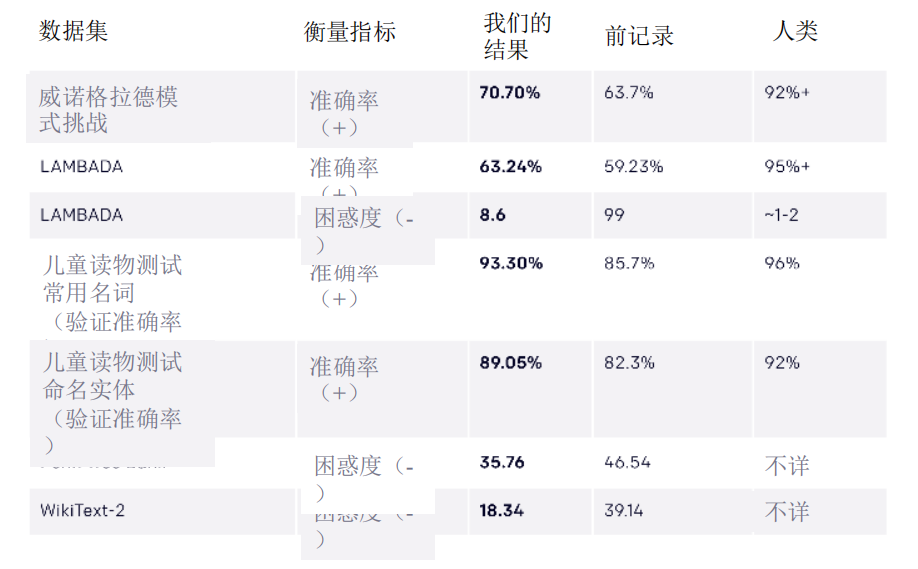

在语言处理方面有很多基准。比如儿童读物测试、常用名词、模式挑战等等,都是自然语言处理(NLP)处理基准。

OpenAIGPT-2的算法,记录表现好,训练量小,需要人的努力少,比高度专业化训练做得更好。

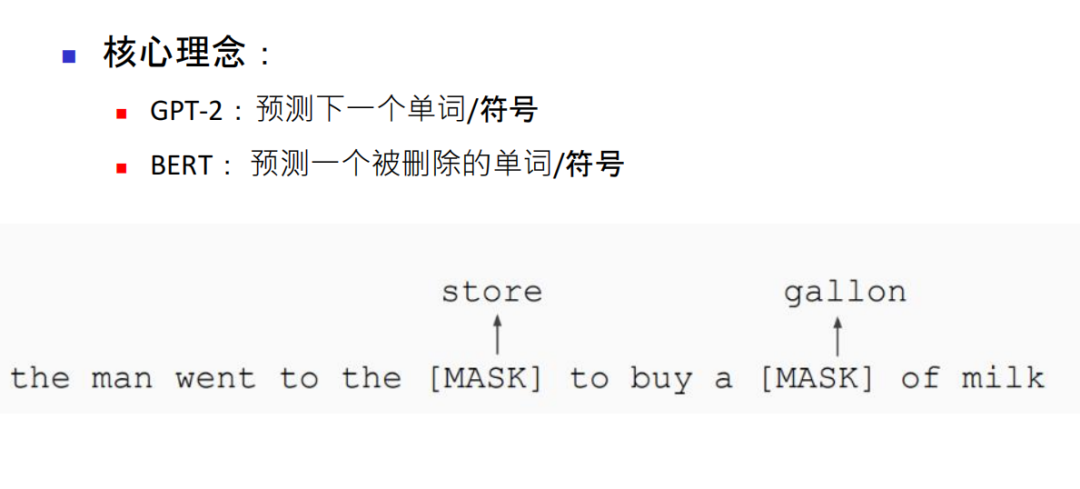

谷歌也有与GPT-2类似的算法,是BERT模型,当中有一个MASK是遮蔽,把单词遮蔽起来,让算法猜,也是一种非常自由式,无监督的深度学习。

对比之下,在所有基准里相对其他算法,谷歌BERT模型表现更好一些。以下每一张图横轴是神经元网络大小,越往右表示神经元网络越大,纵轴越往上走绩效表现越来越好。

人工智能领域最重要的趋势是神经网络越大绩效越好。无监督深度学习找数据很简单也不需要投喂,可以尽情享用互联网资源,就有足够数据可以训练。

自然语言处理(NLP),是AI下一个五年,非常大且会改变一切的领域。

2.视觉领域的无监督学习

仅有文本还不够,还需确认图像的识别,在无监督学习下能不能处理。比如填补图像或视频中一个帧的缺失。

可以训练神经网络填补缺失部分、填拼图、恢复、已经旋转变形照片还原等,可以训练神经网络完成。不需要人为添加标签,下载这些数据,生成任务即能搞定。

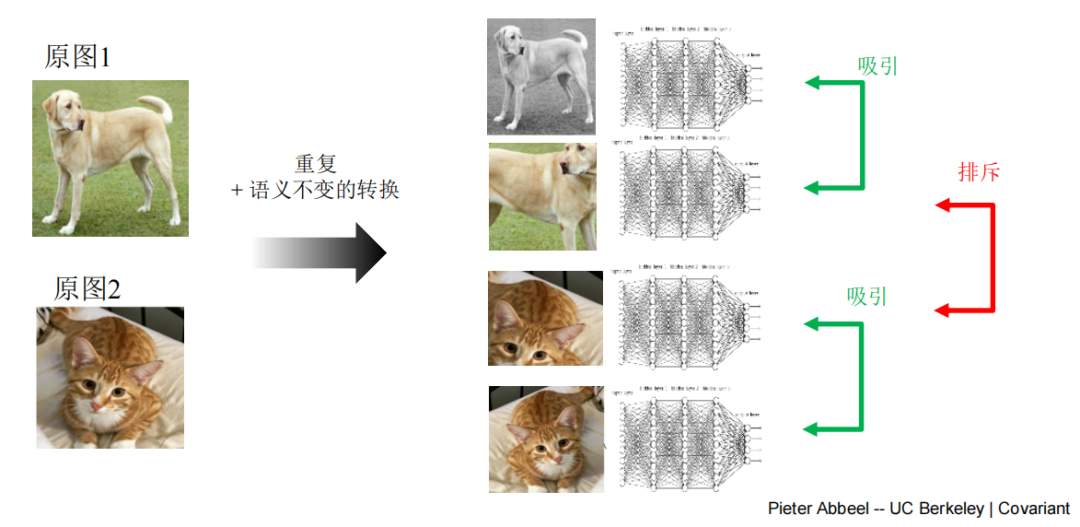

对比学习的核心理念比较新,一年前完全改变了计算机视觉领域。

先从互联网上下载照片,但不要花时间贴标签。计算机就把上面照片分成两张,左右翻转,颜色象素变化一下,接下来训练神经网络做处理,在最后一层完成处理,这两张分别比较相像,就做归类。所以几十亿张照片都可以这样处理,不需要做注释或标签,就是解放式视觉系统。

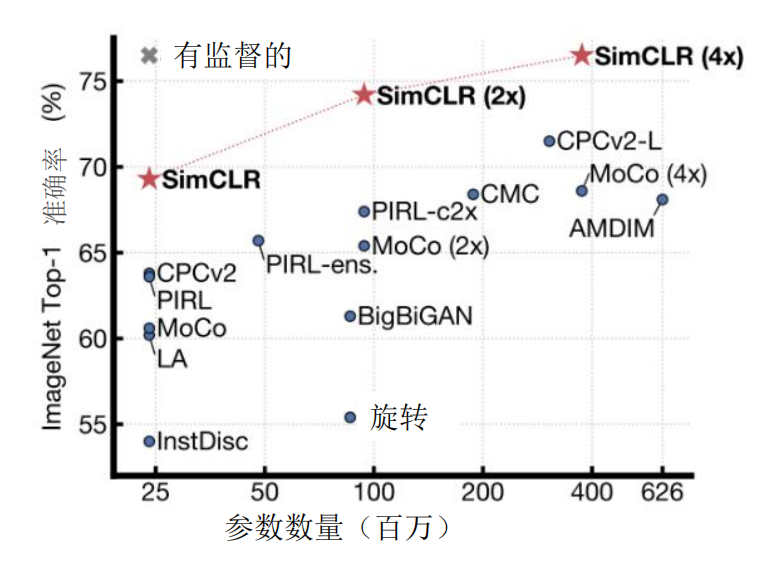

SimCLR + 线性分类器

观察星号SimCLR,网络横轴越大,纵轴表现越好。

3.无监督的深度学习的战略

① 机会

减少人的工作量,不再需要贴标签或者是注释。

② 操作系统

需要AI专家团队和庞大算力。

③ 前瞻性

懂得没有注释的数据同样有价值。未来无监督深度学习,渐渐使用得越来越多,数据注释的未来价值会有下降趋势。

三、超越模式识别AI:深度强化学习

1.深度强化学习:有目标的AI

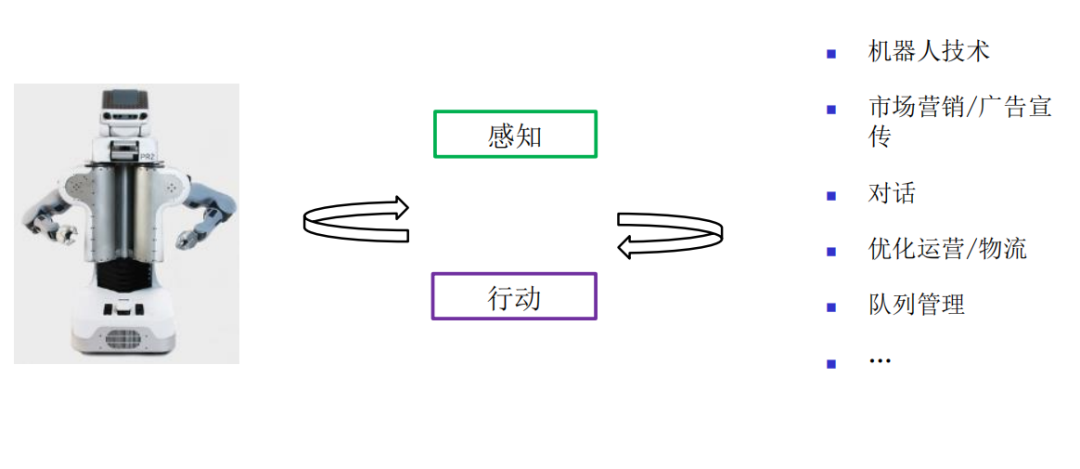

例如你想拥有一台机器人,让它在家里给你提供清洁、洗碗、烧菜等等服务。目前可以造这样一台机器人,但是还需要让它足够智能。足够智能的机器人必须要了解,整个世界是如何运作,能够在真实世界里面生存。

同样,在市场营销、广告宣传以及运营物流等行业也是如此,各项工作都是一个闭环,需要先感知世界,得到反馈后再对应调整行为,再去感知,再去反馈,再去调整,循环往复的一套系统,能够让机器人更深层次了解这个世界,而不仅仅只是表面一个模式的识别。

2.有关深度强化学习的成功案例

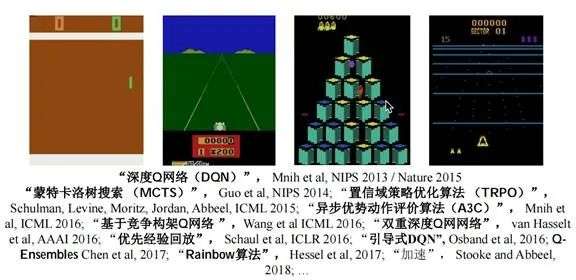

深度强化学习非常难,但是已有一些鲜活且成功的迹象浮现。

2013年深度学习发现神经网络可以打游戏,其原理就是处理图像做决策。有所不同的是,训练它去玩这些游戏,练得越久游戏水平越高。

在伯克利有一个学习运动能力的课让机器人学习,就像人的小时候一样,先练习走、快走、慢跑等不断迭代慢慢学会跑步。

3.AI应用于现实

① 节能

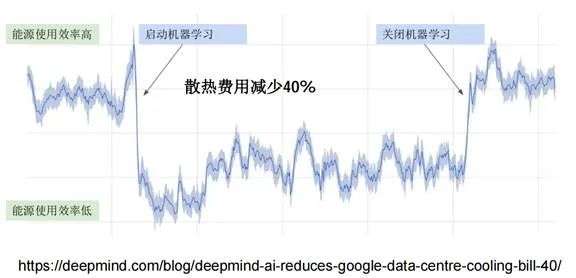

谷歌也在训练神经网络,管理什么时候打开或者关闭数据中心空调,以节省很多能源成本。

② AI机器人

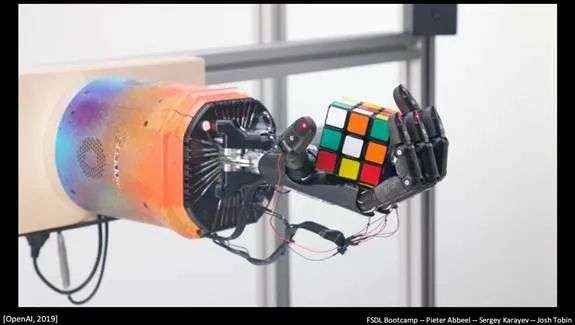

OpenAI的展示说明,如果机器人有足够多训练和练习,甚至可以单手玩魔方。

AI机器人技术是进入现实世界的切入点。

在仓库分货的机器人就可以完成仓库幕后工作,具体的流程操作会转型成自动履行订单。

随着深度强化学习越来越娴熟,机器人在现实中可以完成更多工作。

据统计,每年有两万亿美元,支付于需要用手完成的工作中。目前已经在训练机器人做这些工作,它的现实价值就达到每年有两万亿美元,高于绝大多数人的年薪。

4.深度强化学习的战略

① 机会

以目标为导向持续改进AI。

基于网络用户互动,可以优化大规模系统。

在目标明确但创作内容不明确的情况下,加快创作进程。

机器人不断试错以提升自身技术。

② 操作系统

奖励系统+AI专家团队+算力+“执行中”数据收集,相当于及时让机器人学习,让它一边做一边实践一边收集数据。

③ 前瞻性战略

需要找更多早期应用案例模拟环境,而且成本也相对容易控制。另外,如果已有人工完成,可以先拍摄下工作场景,再示范引导和训练机器人。

四、AI在科学与工程学领域的应用

我个人认为,在未来几年中,AI将会影响科学工程领域。

大多数人认为,科学和工程学领域都是非常先进的学科,需要受优质的教育才能有所突破和贡献。事实是,AI就可以发挥非常大的作用以推动工程科学和技术发展。

1.在生物领域取得重大成果

6个月之前,深度学习成功破解了蛋白质的结构,的确是一个巨大的飞跃。

人体如果生病了,健康的蛋白质会去打击导致疾病的蛋白质。这些蛋白质是一些原子组合,形成了分子。它们自己以复杂方式纠缠在一起,通过3D的分子结构,可以知道哪一部分分子是在内侧,哪一些暴露在外侧,形状以及其暴露面决定蛋白质功能。

因此,第一步还是要了解3D结构。传统方式是,把冷冻过的蛋白质,放在X光里扫描,得到具体形象后,通过一些复杂的处理,就可以恢复其3D结构。可是这个程序非常昂贵,多年来仅有很少一部分蛋白质得到过X光扫描,剖析其3D结构。

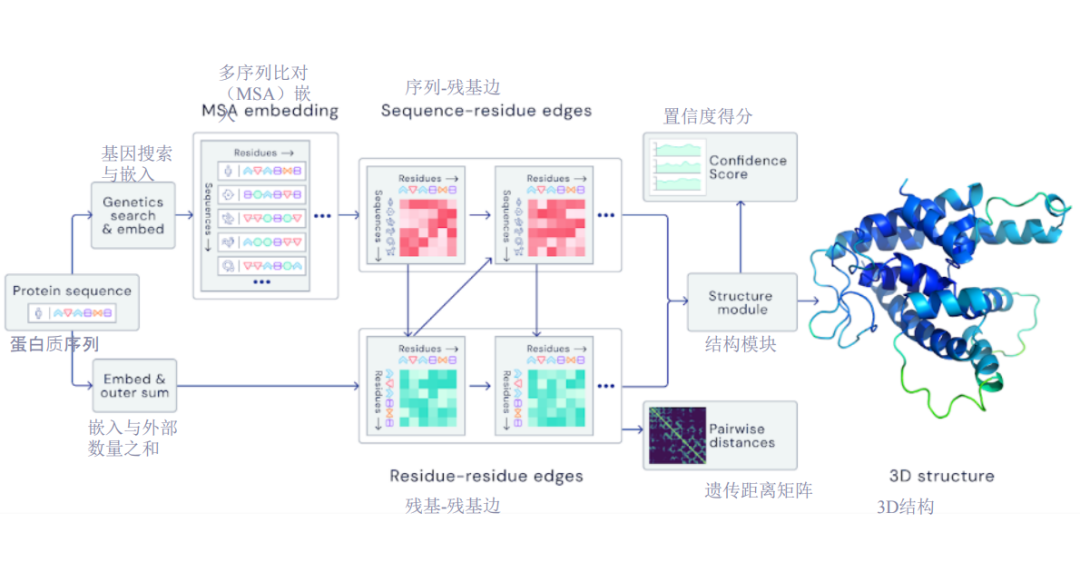

然而,今天可以通过有监督的深度学习预测3D结构。一个图像输出一个标签,或者输入英文文字输出中文,对于蛋白质而言,要了解其原子序列,非常容易且成本很低。

测量的顺序,用X光把原子序列投入进去,产出时就是3D结构。从一边投入一个原子序列,另一边输出3D结构,这样的投入输出,是事先已对神经网络进行过培训。

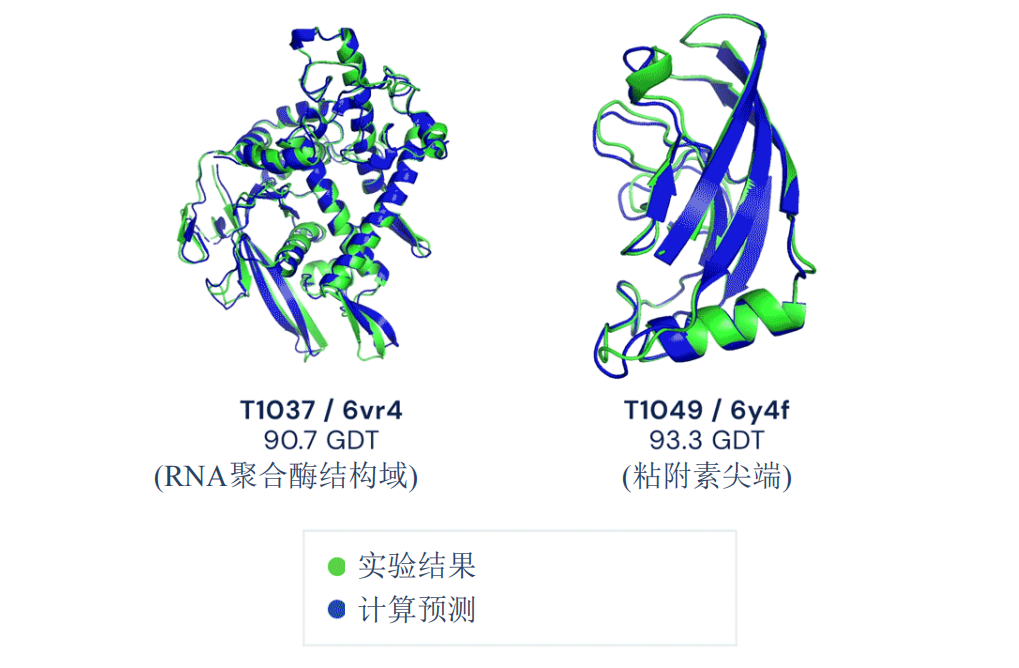

X光告诉我们两个蛋白质的情况,绿色就是3D结构,蓝色是神经网络预测,蓝色基本上和绿色是一致的。

以下是2020年国际蛋白质结构预测(CASP)竞赛。深度学习在2008年只是表现出某种潜力,但是到2020年的时候,达到的性能表现已被认为是重大突破。可以说是AI领域最大的贡献,也是生物领域过去5-6年最大的成果。

有监督式学习,投入是原子序列,输出是3D结构。让学习预测,蛋白质序列放进去会进入数据库,数据库里有大量蛋白质序列,找到一个最接近的序列。

因为进化,当看到一个非常类似的蛋白质,就可以分析哪一部分发生了进化,哪一部分在进化当中没有发生改变。如果没有进化,很有可能就是蛋白质所要完成的功能。有一些动物进化出现问题,就死掉了,因为蛋白质不能完成它要完成的功能。

进入深度学习,需要在非常复杂的环境中来来回回学习,确保用这些序列预测3D结构。

2.深度学习能否加速科学与工程学的发展?

① 蛋白质折叠预测

可以加速科学与工程学发展,现在已经看到蛋白质折叠的预测。

② 加速设计(目前依赖于昂贵/缓慢的模拟器)的一般方法

在伯克利已开始把它用于芯片设计上,集成电路设计上,一个人可以选择一个设计,可以进行模拟。可以获得一些量化指标,进行重新设计,做设计就像打游戏一样,这个设计可以得到一个打分,还可以改进下一步集成电路设计,直到最后得到一个好的设计。目前,通过这个方法已经设计出非常好的集成电路。

③ 数据生成

用于高能物理的生成对抗网络(GAN),用加速器可以帮助收集数据,以推动物理学的发展。

④ 符号数学

现在做微积分可以用AI做,而且可以做得非常好。这种最新的发展,里面蕴藏着大量机会。

五、未来展望

我相信,只要持续做AI,就会有新发展。

1.AI的持续发展

AI的持续发展是靠数据,计算能力和专业知识。每天都在生成更多数据,数据越多,AI也会越来越厉害。

① 摩尔定律

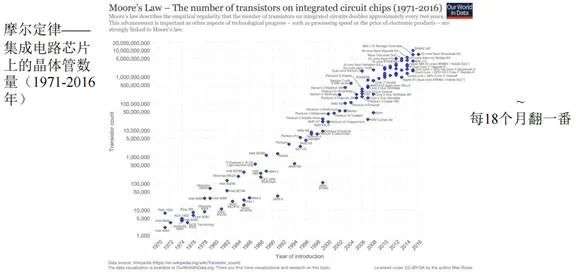

摩尔定律告诉我们,计算能力芯片会越来越厉害,晶体管数量随着年代推进,可以看到一个芯片当中晶体管的量是指数级增加,每隔18个月翻一倍。

尽管众说纷纭,仍存在摩尔定律会终结的50%可能性。

② AI芯片

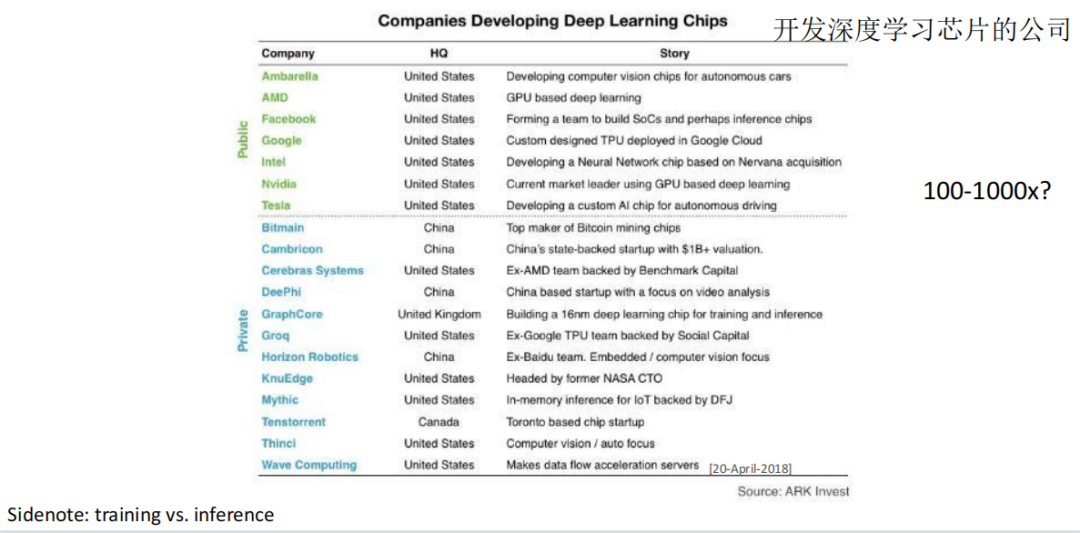

一些公司已在开发神经网络芯片,而大多数的神经网络计算都是在视频GPU(graphics processing unit/图形处理器)里。这种只用于AI的特别芯片,仍然可以获得上千倍的改进(100-1000倍改进)。

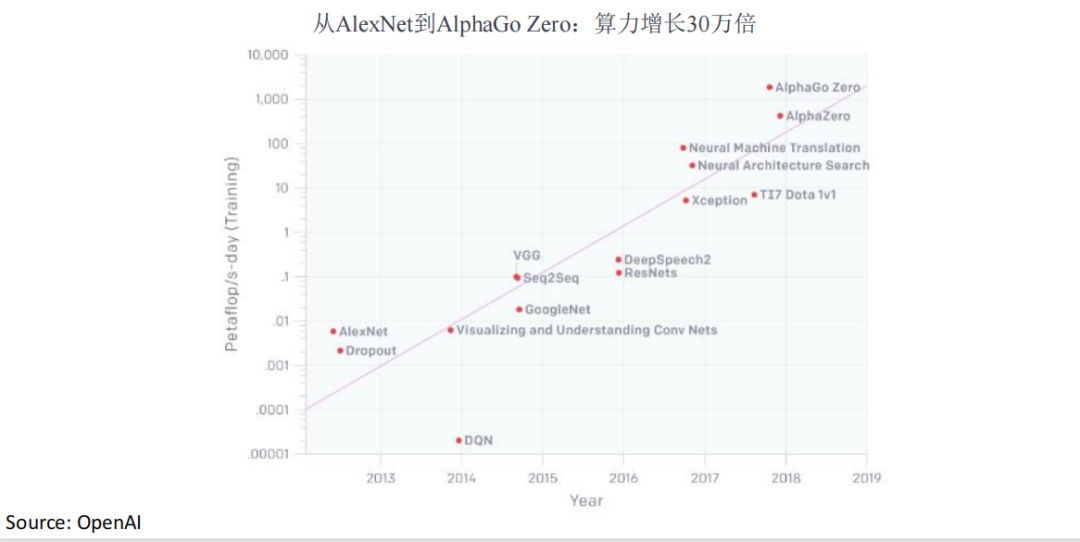

③ 指数级增长

AI的创新仍有很多可能性,会继续释放出更大算力,近年实验规模也是呈指数级增加。

因此,我个人认为AI将不会很快迈入冬天:

算力资源未来至少还有5-10年的快速增长。

将有可能完成以前无法进行的实验。

AI领域将快速取得更多突破性成果。

2.电脑 VS 生物

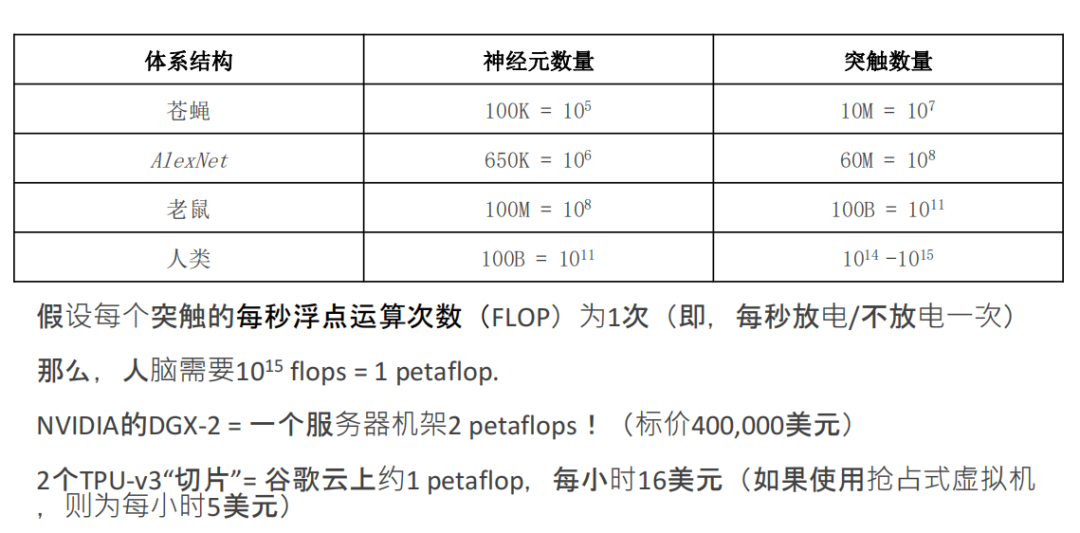

建立越来越多AI系统后,电脑与生物界相比如下:

设计一个神经网络比苍蝇大一点,但只会识别图像,而苍蝇看到的世界是丰富多彩的。

所以潜力空间非常大,其实AI智能可以胜过苍蝇,胜过老鼠,以及触及到人的大脑范围。

再看一下算力,怎么样去计算大脑当中运算的次数,实际上有一个单位每秒的符点运算次数,人的大脑每一个或者每一对神经元通过突出进行联接,就是算每秒是联接一次还是不联接一次。

但是,目前AI系统还没有达到人类大脑级别,估计再过五年会有可能。终有一天会实现:人工智能系统更便宜,计算机应用软件更智能。

3.优势 & 弊端

① 颠覆性力量–优势

不再有车祸;

数学、物理、化学、生物领域的新探索;

消除许多疾病;

AI将助力我们完成创举(比如去火星);

创造更多财富。

② 颠覆性力量–弊端

虚假新闻 or 故事(大话连篇、深度造假、文字故事等);

人脸识别、自动监控等缺乏隐私保障;

无意造成的不良后果(如所有自动驾驶汽车均告失败);

在自动化与数字化的情况下,部分工作岗位的消失;

财富极度聚敛于领先AI公司。

4.书籍推荐

① 《第二次机器时代》

通过这本书,大家可以了解怎么让机器带来生产效率。现在的AI革命,这本书里面有解释,每一次生产效率发生大转变时都发生了什么,并且在此基础上预测AI和人类将来。

② 《超级智能》

这本书有意思的地方在于作者抛出一个问题,他说如果有一天AI比我们更聪明了该怎么办?

有人就觉得是杞人忧天,想着只要把AI开关关上就可以,其实没有那么简单,如果这AI足够聪明,就不想让你关掉,会想尽办法阻止你。

所以世界会变得非常复杂,人造出来的系统或许会比我们自己还聪明、更智能。所以,2015年的新闻媒体说,AI是人类文明上的最大破坏力。

当然,目标是希望AI变得越来越好,此书也是给我们敲响警钟。

5.首鼠两端的终极思考

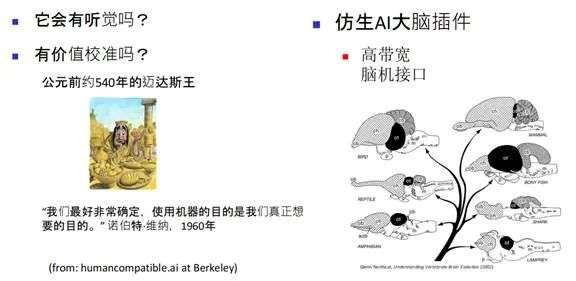

将来人类如果和超级智能体共处,我们有两条路径:是否有听觉;价值观是否一致。

例如很多年前古代有个迈达斯王,他有点石成金的力量。但是他不能和人拥抱,也不能和人握手。

有一位伯克利学者曾说,“我们最好非常确定,使用机器的目的是我们真正想要的目的。”

有一家公司走了另外一条路径,他们做的是仿生AI大脑插件,已经用上了初级AI,每天做着各种各样事情。

从某种程度讲的仿生,就是直接接入大脑里作为大脑插件,这也不是没有可能的。回顾人类进化史,人的大脑发展,也是一步步演变过来。类似的插件移植进大脑里,大脑会越来越大,也越来越强壮。

也许,有可能是一个无线联接,连接到某台计算机,让插件在大脑里面生存。就等于人类自己可以很智能,但大脑也会越来越大。

非常感谢大家仔细聆听!

*文章为作者独立观点,不代表笔记侠立场。