腾讯研究院报告:未来的自动驾驶能有“责任心”吗?

编者按:本文来自微信公众号“腾讯科技”(ID:qqtech),来源:腾讯研究院 & 腾讯科技,36氪经授权发布。

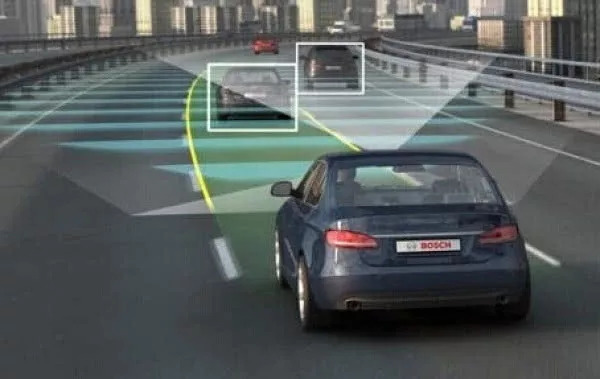

自动驾驶会影响人们的传统驾驶伦理观,而且还会创造出新的驾驶伦理观念,因此对自动驾驶的伦理决策制定基本框架是具有前瞻性的。

设想,一个醉汉突然冲向马路,因撞上了正在行驶的自动驾驶车辆而死亡。在现有的法律框架下,人们不会苛责任何一个正常的理性人,因为几乎没有可能避免这样的意外事故。但是自动驾驶汽车,可能会改变人们对过错的判断标准,因为未来,这个标准将是合理机器人(reasonable robot)标准。此外,相较于人工驾驶,自动驾驶更具有“可责性”。

因为,自动驾驶车辆的决策基础是事前的系统编程,所以可以理解为,对于交通事故的损害结果具有事前的“预谋”和“故意”。

由腾讯研究院发布的《2018年全球自动驾驶法律政策研究报告》关于全球政策分析第六章《伦理:自动驾驶的阿喀琉斯之踵》中,针对相关政策给出了分析与答案,以下为具体内容:

探索自动驾驶的具体伦理规则

在自动驾驶汽车伦理问题上历来存在巨大争议。像“电车难题”这样的伦理困境,人类尚且难以给出两全之策,机器又该如何妥善处置呢?

有学者指出对电车难题的讨论是没有意义的。德国车辆制造商梅赛德斯更是直截了当地给出了自己的答案,即梅赛德斯将优先保护车上人员安全,同时指出电车难题不是一个真正的问题,因为该公司将“致力于提高和完善技术和风险防范策略,完全避免两难情况的出现”。

美国交通部2016年将伦理问题作为自动驾驶汽车15项安全评估标准之后,2017年却将其从中删除,这一转变表明伦理事项并非当前的核心问题。然而,德国则尝试应对自动驾驶汽车带来的伦理问题,并为自动驾驶汽车提出了20项伦理准则,但这些原则能否落实到技术层面也备受争议。

2017年6月,德国联邦交通部自动驾驶伦理委员提交了《自动驾驶汽车伦理报告》,该报告指出三项宏观伦理要求:

其一,自动驾驶的首要目标是提升所有交通参与者的安全,在同等程度上降低所有交通参与者的风险;

其二,认为自动驾驶系统发生事故并不超出伦理界限;

其三,虽然自动驾驶技术能够降低风险,提高道路安全,但如果以法律命令要求必须使用和普及这种技术,在伦理层面就是有问题的。

在微观上,该报告从伦理困境,网联安全和车辆数据保护,人机交互,新技术背景下其他领域的伦理问题,责任认定等角度提出了多项具体要求,主要包括以下三方面:

(1)明确优先选项并进行限制

诸如“电车难题”这样的伦理困境,其核心在于不同利益具有各自合理性的同时又相互排斥,不论从功利主义还是义务论的角度解释,侵犯任何一方的权益均难具说服力。例如,小孩和老人的生命,乘客和行人的生命,五个人和一个人的生命等等。因此,在讨论伦理抉择时,需要首先明确的是,所谓“优先选项”并非“否定选项”,因为伦理绝对不鼓励损害任何一方的利益,且任何一方的利益都具有合理性和正当性,任何抉择都将产生道德遗憾。

在具体规范中,明确和限制对优先选项的选择主要体现在两个方面,其一是对人的保护优先于所有其他利益考量,即在用尽所有技术防御仍无法避免的危险中,对人类生命的保护在法律上高于一切。也即,在技术可行性框架范围内,为了避免人身伤害,接受对动物或财物的损害。

其二是禁止歧视,即在发生不可避免的危险时,严格禁止将个人特征(如年龄、性别、身体及精神状况等)作为评判标准。禁止对受害者进行区别对待,禁止对被害人进行相互抵消,禁止认为根据主体数量决定“五个人的生命价值高于一个人的生命价值”。

(2)保留人对车辆的控制权并禁止事先编程

在以个人为中心、促进自由发展的同时,关于技术的立法策略应该是追求个人选择权最大化。如果要求每个驾驶员都按照编程做出伦理决策,等于剥夺了驾驶员自主选择的权利。德国自动驾驶伦理原则第1条指出,技术应遵循个人自治原则(the principle of personal autonomy),个人也应对自身享有的行动自由负责。与此类似,阿西洛马人工智能原则的第16条也指出,人类应该来决定如何和是否让人工智能系统去完成人类选择的目标。而这一点,也是确保车上人员能够长远地享有车辆绝对控制权的重要途径。

保留人对车辆的控制主权同时还体现在禁止程序开发人员对伦理抉择进行事先编程。德国自动驾驶伦理原则指出,对于两难局面,即必须在人的生命之间做出损害甚至牺牲一方以拯救其他当事方的选择的极端情况,两难决策(dilemmatic decisions)不能被标准化和编程化,具体决定应视具体情况而定。

(3)强调通过技术防范伦理困境

政策不该将机器人或者学习算法置于人类生命决定者的角色,而应积极探索其他解决思路。目前主要的思路,就是技术手段。通过技术防范伦理困境主要体现在三方面:

其一,自动驾驶技术应尽量避免事故的发生,对于两难局面(dilemmatic conflict),应该事先就做出防范此类风险的策略。因此,从车辆的设计和编程开始,就应考虑以一种具备防御性和可预期的方式驾驶,并全面应用和完善技术,尽可能地降低可能给交通弱势群体(vulnerable road users)造成的风险。

其二,公众对于自动化技术的研发情况享有知情权,应该以尽可能透明的形式整理出自动驾驶车辆使用及编程准则,并告知公众,同时由专业的独立机构对其进行审查。

其三,制造商或运营商有义务在技术可行及合理的范围内,对已交付的系统程序进行监督,并及时改进和更新系统,以确保和提高自动驾驶车辆防范伦理风险的能力。

自动驾驶技术未来发展绕不开人机伦理争议

虽然当前各国纷纷认可自动驾驶技术的法律地位,但将来是否以法律命令要求必须使用和普及这项技术,现在还未达成共识。

2015年,伊隆·马斯克在一次采访中表示,汽车技术的进步有朝一日可能使人类操作的汽车成为非法。这引出了一个问题,未来谁将成为合法的司机,未来的法律政策在人机之间作何选择。

虽然各国的自动驾驶汽车法律政策无论是针对测试还是商用都强调人类司机的绝对控制权,在自动驾驶模式下是如此,在辅助驾驶模式下更是如此。但如果将来自动驾驶技术的安全性可以达到非常高的安全水平,在所有的驾驶环境中都能够作出比人类更优的决策和判断,使得交通事故成为小概率事件,法律政策又该作何选择?届时,考虑到人类驾驶显著的负外部性,允许人类驾驶将比允许自动驾驶更不道德?

当前来看,在人机切换的选择下,将司机从驾驶活动中解脱出来,又希望其在必要时介入,是一个充满悖论的选择。业界对困扰人机切换的“离手”(hands-off)问题尚未找到有效的解决方法。无论是辅助驾驶还是自动驾驶,很多事故其实是在人机切换时司机反应不及时、注意力不集中而导致的。未来的汽车设计是否可以不用再考虑人类驾驶这一因素,这既有来自当前法律的障碍,也有来自于伦理的障碍。

德国等欧盟国家强调技术应遵循个人自治原则,不应限制个人行动自由。德国自动驾驶汽车伦理报告承认,具备防撞功能的高度自动化系统能降低风险、增强安全性,这是社会和伦理层面需要鼓励的,但如果以法律命令要求必须使用和普及这种技术,则会引发“人受制于技术、人的主体地位受到贬损”等道德争议。当然,无人驾驶汽车的设计选择还面临着来自司机群体的压力和反抗。想必随着技术的成熟和普及应用,自动驾驶取代人类驾驶、自动驾驶优先于人类驾驶等伦理道德争议将热烈起来。

无论如何,可以的肯定是,无人驾驶汽车的设计选择将深刻影响汽车制造、保险等相关产业和人类世界。虽然我们无法准确预知未来,但却可以选择对自动驾驶汽车未来发展路径保持开放,可以选择不把人类驾驶员这一紧箍咒加诸其上,让技术和市场决定谁来主宰未来交通。