即将改变一切的计算趋势

大家都很熟悉摩尔定律(参见

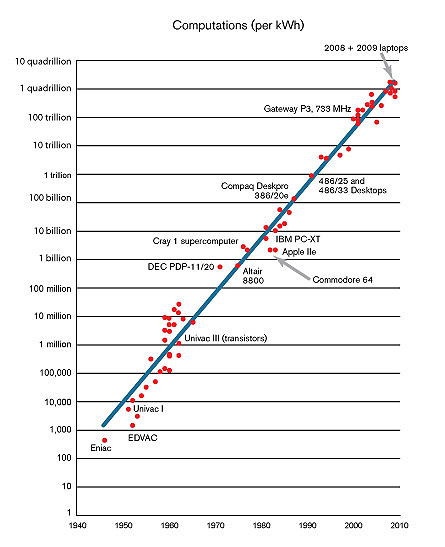

极客须知的十大定律),即自上世纪七十年代以来,计算机的性能每18个月翻番。但是却很少人留意到另一个跟摩尔定律变化曲线相当的效应:自计算机诞生以来,其电效率同样是每18个月翻一番。

笔记本与智能手机之所以存在要感激这一趋势,正是因为这个隐藏的摩尔定律导致这些电池供电设备耗电量的大幅削减。从下图可见,执行固定运算次数所需的功耗在未来仍将稳步且高速地下降,如果你需要直观一点的印象,我们不妨把时间放到10年后,到那时执行相同次数的运算所需的能耗将会是今天的1/100!其结果必定会是更小型的、能耗更低的计算设备的大幅扩散,从而为新的移动计算和通信应用铺平了道路,而后者则可以极大地提高我们实时收集和使用数据的能力。

超低功耗计算的一个例子是华盛顿大学的Joshua R. Smith发明的无电池无线传感器,其所需的能量是从杂散的电视和无线电信号那里捕获的,每5秒钟会将数据从气象站传送到一个室内显示屏。这种设备由于用电量极低(平均50微瓦)所以不需要其他电源。

能够收集环境能量(如环境光线、运动、热量等)为无源移动传感器的运作打开了机遇之门,这意味着可用数据的大爆发。颗粒度精细的定制化数据(如个体特征数据、交易数据、信息流等)必将全面扩张,这种数据被麻省理工学院的Erik Brynjolfsson教授称为是

纳米数据(nanodata)

。

这种能耗下降的趋势究竟能持续多久?1985年,物理学家Richard Feynman曾做过计算,认为最终计算设备的能耗效率会提高1000亿(10的11次方)倍(相对于当时的计算机能耗)。而根据

统计从1985到2009年间,计算设备的能耗效率提高了40000倍。这个数字听起来有点吓人,但是跟10的11次方相比,说明这个趋势才刚刚开始。

[caption id="" align="aligncenter" width="445" caption="相同能耗下计算机执行的运算次数每1.5年翻一番"]

我们再举个具体一点的例子,如果把今天的MacBook以1991年的能耗水平来运行,那么这台笔记本电脑完全充好电的电池只能够坚持2.5秒。我们再往前推演一下,再看看当今运算速度最快的超级计算机,日本的的京(Fujitsu K),其浮点运算能力达到1万万亿次/秒,但是能耗也达到了惊人的12.7兆瓦。这种能耗足以为一个中等规模的城镇供电。但是从理论上来说,如此计算能力的设备,在20年之后,其能耗不会超过一台烤箱。而今天的笔记本的能耗已经到达无穷小的地步。

这一现象驱动着所有硅基设备的发展。但是尚未有人能够确定数据传输的效率(比如传感器发送无线信号的能耗)是否也会有相匹配的提高。信息传输速率、通信频率、不执行任务时节能的方式,这些设计选择都会显著影响到移动设备的总体耗电情况。不过计算的效能改进也会推动其他领域的创新,因为这是完全发挥新计算和传感技术威力的唯一之道。

计算能耗长期持续的改进将会革新我们收集和分析数据的方式,也会影响到我们利用数据进行决策的方式。在这一趋势的推动下,物联网将会变成现实。工业过程的控制将会更加精细,评估我们行动的结果也会更加快速有效,反映新现实的体系和业务模型重塑将会加快速度。还能够帮助我们以一种更为实验性的做法与世界交互:即我们可以实时地取得真实的数据来验证假设,并能够根据情况调整假设。

从历史上看,最好的计算机科学家和芯片设计师关注都是尖端的高性能计算问题。但是现在计算能效正在逐步吸引顶级的设计师和工程师,他们面临的是一个新问题—如何进行全系统的集成设计,怎样提高用电和数据传输效率,以及如何将人类的关系演变为与宇宙的关系—这是一个迷人而又充满挑战的命题,如能解决,也许我们即将迎来阿凡达的世纪。