人脸识别道德危机:微软封杀情绪识别AI,IBM退出相关业务

编辑:桃子 如願

原标题《情绪识别AI竟「心怀鬼胎」,微软决定封杀它!》

【新智元导读】自人脸识别问世以来,饱受争议,现今,微软宣布淘汰这项可以识别情绪的面部识别工具。

今天,微软暂停提供能识别情绪的AI。

这不是好事吗?

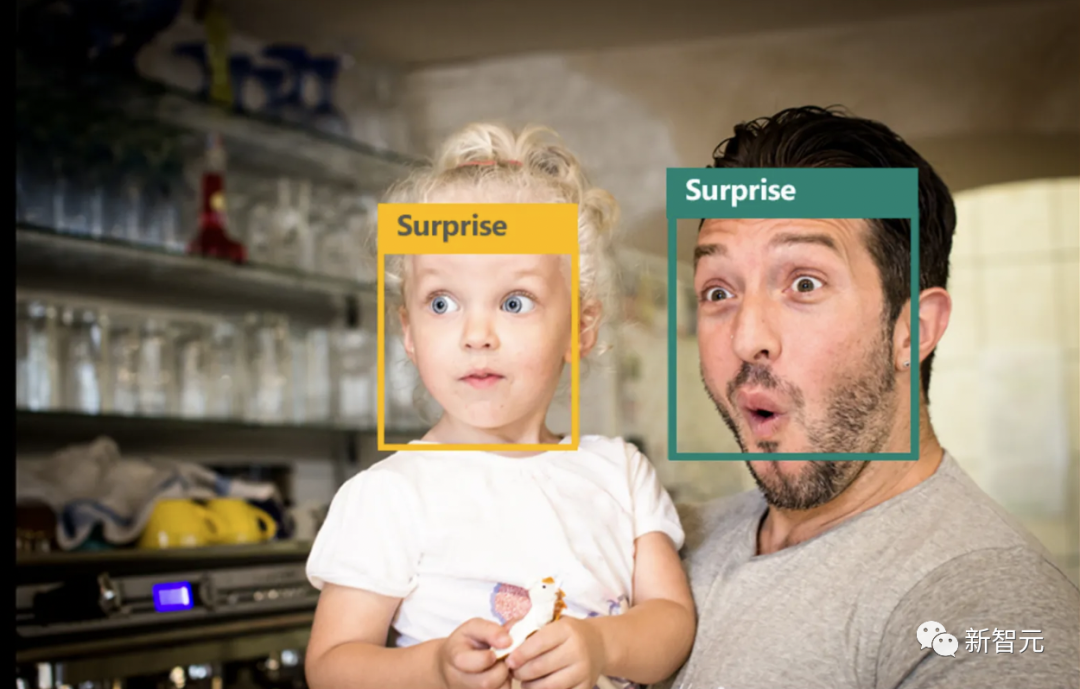

AI识别情绪还真的不太稳定,没准儿就会人工智障...

就比如近日网上流传的这张图,董宇辉和韦神的眼神对比。

AI可以识别出「希望」和「力量」吗?

还真不好说...

就在今天,微软宣布,逐步停止向公众提供基于AI进行面部分析的工具。

其中就包括可以从视频和图片中识别对象情绪的AI。

与此同时,微软将限制访问其面部识别服务Azure Face的一些功能,而且还会完全删除其他功能。

这意味着公众以后想用微软情绪识别工具的话,还得去申请才能使用。

不仅是情绪识别,还有能识别性别、年龄、面部毛发、化妆等能力也将被停止使用。

其实,微软做的这一决定是其在人工智能道德政策上面改革的一部分。

此前,微软在更新的责任人工智能标准中提出了问责制,来监督谁使用了自家的服务,并对人脸识别工具的应用场合进行了更多的人为监督。

一直以来,情绪面部识别工具受到了各界的批评。

人们在「情绪」的定义上缺乏科学共识,另外带来的隐私问题也令人担忧。

就拿笑来说,不同的人笑有千千万万,因人而异,而拿笑等同于内心感受是快乐的并不科学。

微软表示,从6月21日起将停止向新客户提供这些功能,而现有客户的访问权限将在2023年6月30日被终止。

说是这么说的,但是真的完全关了吗?并没有...

目前,微软旗下另一款产品叫 Seeing AI 仍能继续使用。这是一款为有视力缺陷的残障人士提供使用的APP。

正如Azure AI的首席产品经理 Sarah Bird在博客中提到,情感识别等工具在一系列可控的可访问性场景中非常有价值。

另外,微软对根据真人录音创建人工智能语音功能也受到了限制,深度伪造音频难了...

那么,微软的Azure Face能提供什么功能?

Azure人脸服务主要是提供用于检测、识别和分析图像中人脸的 AI 算法。

比如身份验证、无接触访问控制和实现隐私的人脸模糊等等。

-

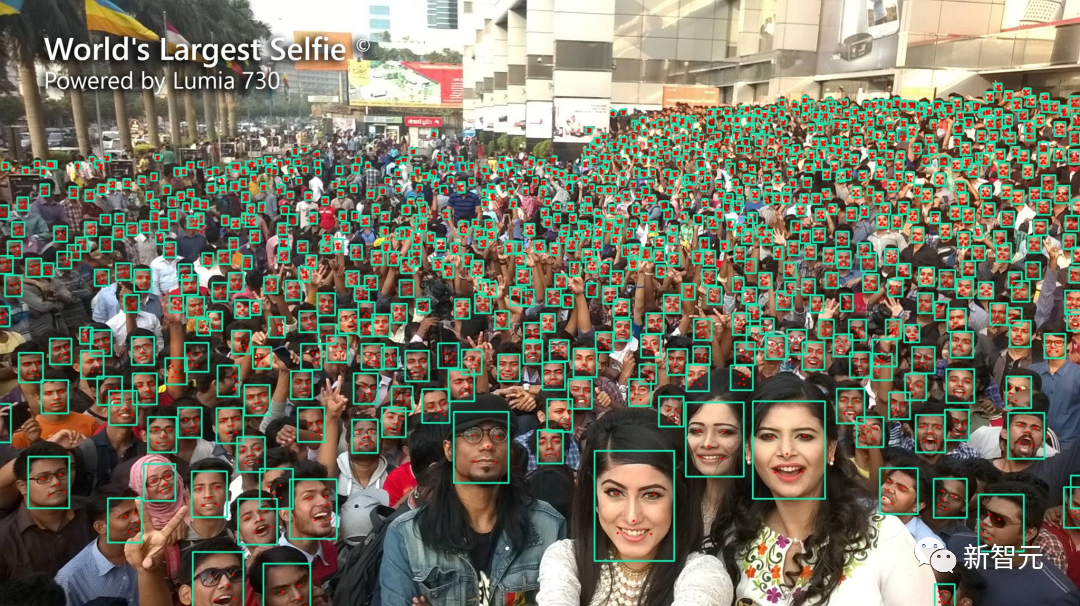

人脸检测

在所有其他情况下,需要将人脸检测作为第一步。

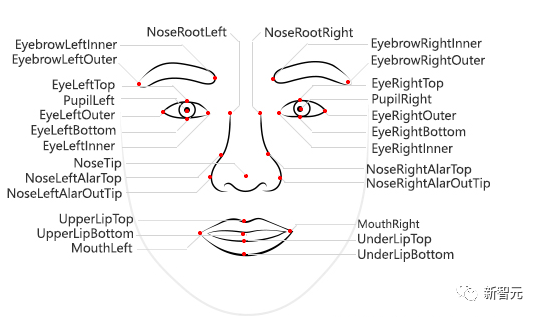

检测API可以根据人脸特征点(例如瞳孔或鼻尖。默认情况下,有 27 个预定义的特征点。)检测图像中的人脸,并返回其位置的矩形坐标。

这是一组像素坐标,用于检测脸部的左边缘、顶部、宽度和高度。使用这些坐标可以获取人脸的位置及大小。

当然,除了能够给人脸标出矩形框外,检测API还可以返回与这些人脸相关的一系列属性,例如:

年龄:年龄猜测

性别:男或女

情感:显示哪些情感

人种:白、黄、黑等

头发:头发类型和头发颜色

接下来,它还返回一个表示存储的人脸数据的唯一ID。该ID将在后续的操作中用于识别或验证人脸。

-

身份验证

检测出了人脸之后,我们就开始进行身份验证了~~

回想一下我们乘坐飞机过安检验证身份的时候。你的脸映射到一个小小的摄像头中,根据你的身份证信息进行匹配,那这背后又是怎么工作的呢?

验证是将图像中的人脸与安全存储库或照片中的一张人脸进行「一对一」匹配,以验证他们是否是同一个人。

该功能支持两种工作模式:matchPerson和matchFace。使用验证API针对同一人进行筛选后,matchPerson模式会返回相似人脸。

matchFace模式会忽略同一人筛选器。它返回相似候选人脸的列表,这些人脸不一定属于同一人。

这是目标人脸:

这是候选人脸:

matchPerson模式会返回A和B,它们与目标人脸显示的是同一个人。

matchFace模式返回 A、B、C、D,恰好四个候选项,即使某些选项与目标不是同一人或者相似度低,也是同样会被返回作为参考。

-

对人脸分组

人脸分组操作会基于相似性,将未知人脸的集合分为几个较小的组。

它还会返回单个「messyGroup」数组,其中包含未找到的相似性的人脸ID。

值得注意的是,返回的一个组中的所有人脸可能属于同一人,但一个人可能有多个不同的组。这些组按其他因素(例如表情)再进行区分。

自人脸识别面世以来,饱受争议。

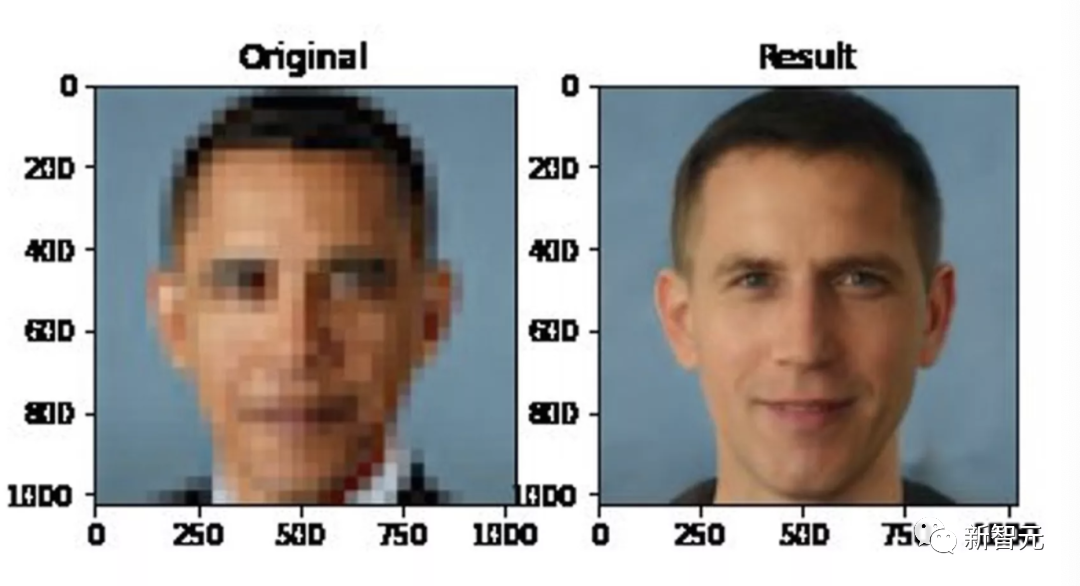

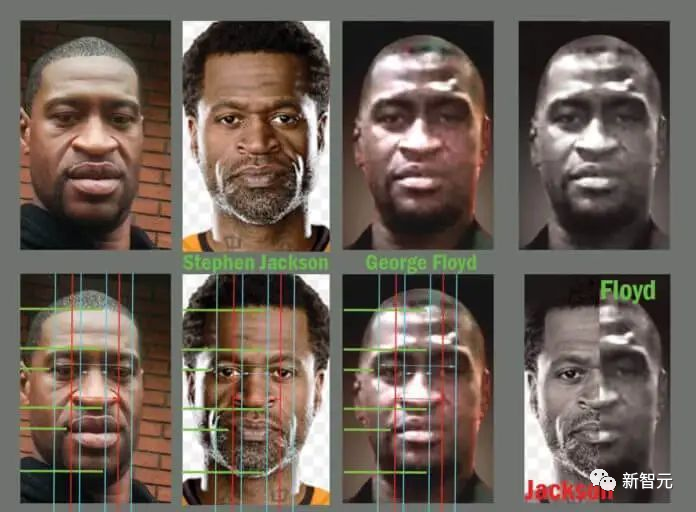

还记得2020年,黑人算法事件引爆人工智能社区一事吗?

该算法PULSE由杜克大学推出,可以将模糊的照片秒变清晰,效果出奇的好。

然而有人发现,将一张奥巴马的模糊照片,用PULSE洗出来以后,变成了一个白人!

当时美国网民直接不干了,纷纷将斗争的矛头指向了人工智能。

而一向敢说的Yann LeCun,就这张照片发推表示:

ML结果的偏差,原因在于数据的偏差。

一时间,LeCun又成为AI研究人员针对的对象。

外加上弗洛伊德之死在网上引起轩然大波。

甚至有人公布了一份长达23页的文件,声称弗洛伊德死亡视频是合成的Deepfake假视频!

在这样的环境下,IBM首先宣布正式退出人脸识别业务。

随后亚马逊紧接着发声,暂停向警方提供其人脸识别技术Rekognition一年时间。

另外,微软也加入阵列,并表示在有监管面部识别技术的联邦法律出台之前,不会向警察部门出售这种技术。

正是基于隐私安全和种族歧视两大原因,才导致了越来越多科技公司「弃用」了人脸识别技术。

参考资料: