指针走到了九点,凝视着时钟的技术招聘官Jasmine从昏沉中回到现实,她将咖啡连同叹息一口抿了下去,并端正坐在电脑前。又是一天的评卷日……

技术招聘已持续数周,公司筛选出了100位嵌入式工程师候选人的技术测评答卷,每份评卷需要30-45分钟,100份便是妥妥50个小时,想起来就头大。

审完十多份试卷后,她疲劳得实在需要休息一下,但恍惚间一个不安的念头闪过她脑海……自己前后的打分是否一致呢?缺乏客观标准,让她的打分异常艰难。

“如果AI能帮我评卷,那就好了......”

Jasmine两眼无神,回望向时钟.....

既然如此痛苦,为何Jasmine的公司还要采用问答题进行技术测评呢?

比起常见的选择题、编程题,问答题更多需要候选人书写答案。除了考察候选人的具体知识点外,能从其解题思路与观点中,更加深入了解他的设计思路、解决方案,和对概念的理解;从答案的逻辑性、组织性和完整性等方面,企业可以获得更多信息,了解候选人的深入思考、逻辑与创造性思维。

但这类问题却给技术招聘官的评卷带来了巨大的困难,原因有如下两点:

1. 耗费海量时间与精力

国外一份研究显示,在技术测评中,考虑到不同题型与难度,招聘官平均须花费30-45分钟来评审问答题,而面向高阶技术工程师的问答题评审,甚至会高达60分钟。

一份对谷歌技术面试官的采访也表示,他们往往每周都会花费数十小时以上的时间来评估问答题试卷,以决定候选人进入下一轮面试的资格。

从中可知,人工评估技术问答题,的确需要耗费海量时间。

2. 评审主观性强,招聘官间缺乏一致共识

问答题由于没有明确的正确or错误答案,导致每位招聘官对回答内容都有自己的理解。候选人是否具备某项能力,强烈依赖于该招聘官的个人观点;并且一个团队内招聘官A/B/C,针对一个候选人的一个答案,还会产生三种不同的观点,导致“一千个哈姆雷特“的问题,彼此很难有一致性。

曾发表于《国际选拔与评估》杂志的一项实验就显示:实验者让3名评审人以5分制,对两位候选人的答卷进行评分,结果候选人A的评分为5 、4、 2,候选人B的评分为 2 、3、 5,一个人的答卷,在不同人眼里存在着巨大差值,可见评审极易受个人主观因素的影响。

正如招聘官Jasmine所想 ,如果能将AI引入复杂的问答题中,将答案内容数据结构化,并依据算法建立准确明晰的评估标准,不仅能实现评分的一致性,还能通过自动化流程,节省海量的工作时间。

随着人工智能高速发展,AI早已融入日常工作之中。ShowMeBug深知AI的巨大意义,采用最新AI大模型,实现独有的问答题AI评分,打造全自动化、高可靠性的评分体系,评卷更加客观化、自动化,评卷时间0投入!

ShowMeBug自动AI评判功能的核心思路,在于设定了评分维度,并辅以AI自动化功能。通过更高效的自动化方式,节省海量评卷时间;并通过明确的评分标准,更客观地评价候选人的答案,保障高度一致性、可靠性、客观性的评分结果。

具体来说,AI评分的高一致性使得同样答案的每次评分都相同,屏蔽了主观因素干扰;可靠性保证了评分是根据设定的维度所作出,让评分有标准可依;客观性使得评分结果仅围绕着维度的内容展开,不会考虑与内容无关的角度。

我们可举一例来说明:

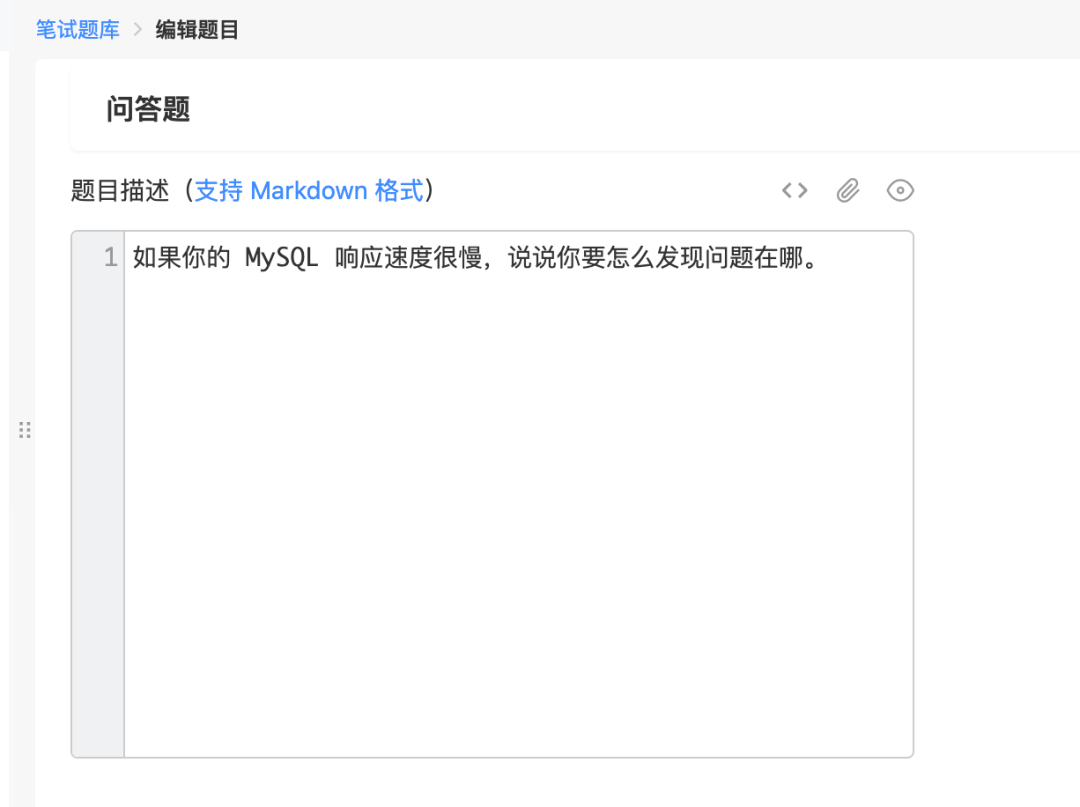

现在假设企业需要招聘 Java 后端开发工程师,那么技术面试官可以出题考察候选人SQL 优化的能力,这时候企业可以在 ShowMeBug 后台设置一道题来考核候选人在My SQL性能问题上的排查思路:

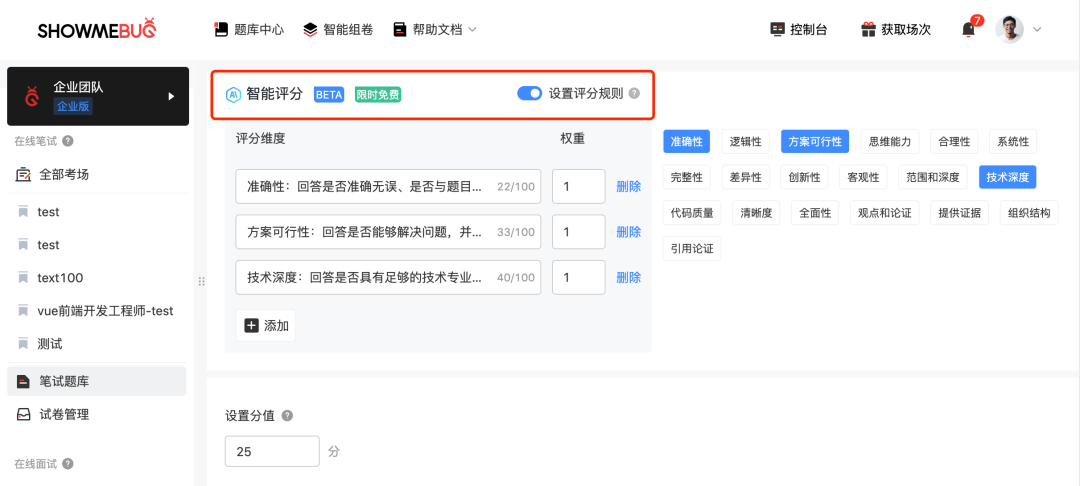

Jasmine作为这家企业的技术面试官,可在试题参数设置中,打开内置的AI智能评分功能。ShowMeBug 预设了19种常见的评分维度,包括答题的准确性、完整性、技术深度、逻辑思维等等。

同时,ShowMeBug 也支持企业根据自身需求自定义评分维度。设置多种评分维度的目的,是为了避免不同评卷官可能会因为判断标准不同,而给出不同得分,导致评分结果带有较大主观性的情况。

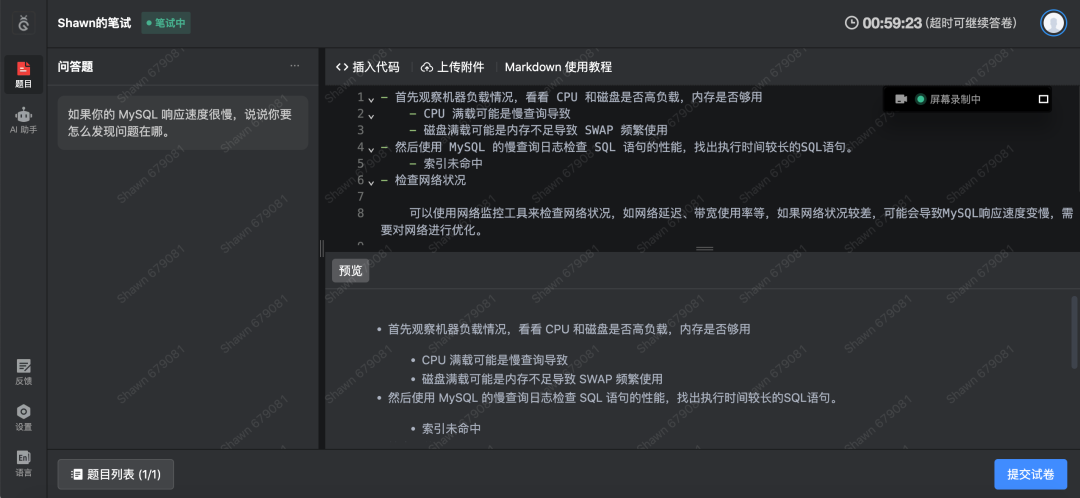

设置好试题、试卷和考场后,企业邀请候选人Shawn进行技术测评。候选人Shawn很快就在ShowMeBug 上提交完试卷。企业进入到了评卷环节。

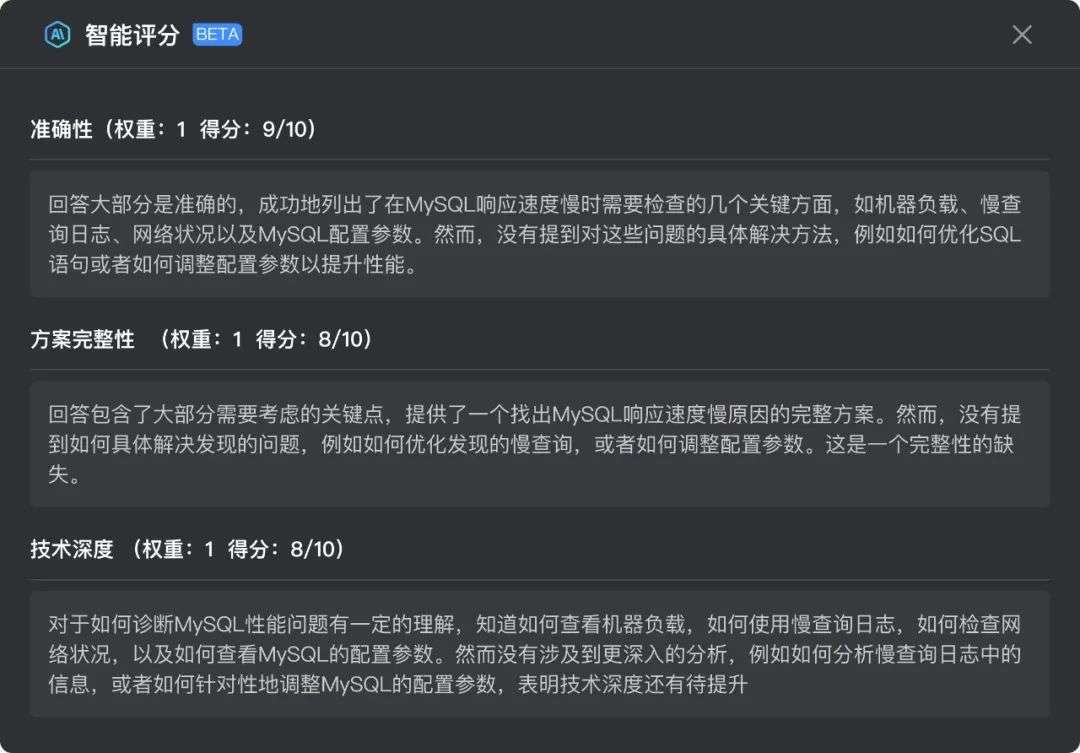

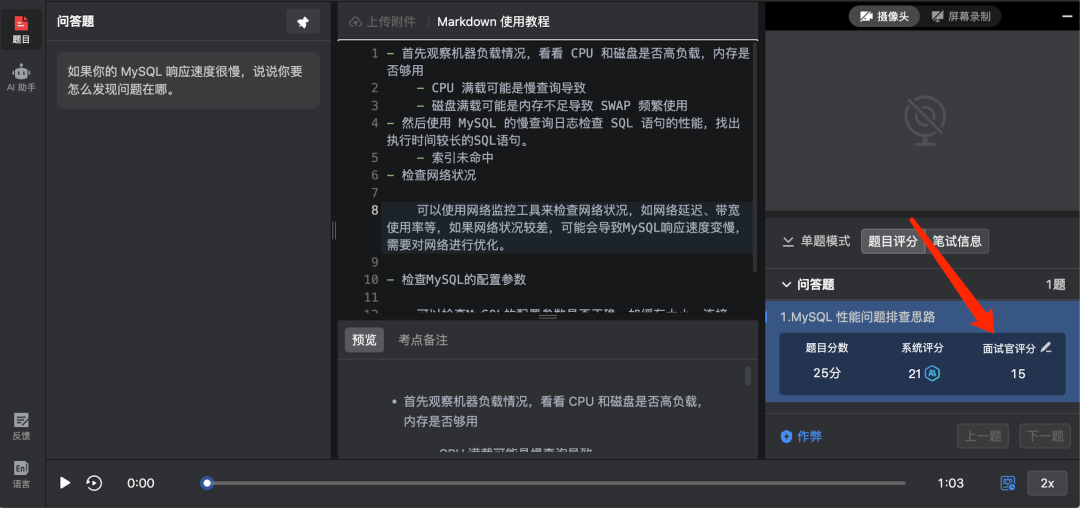

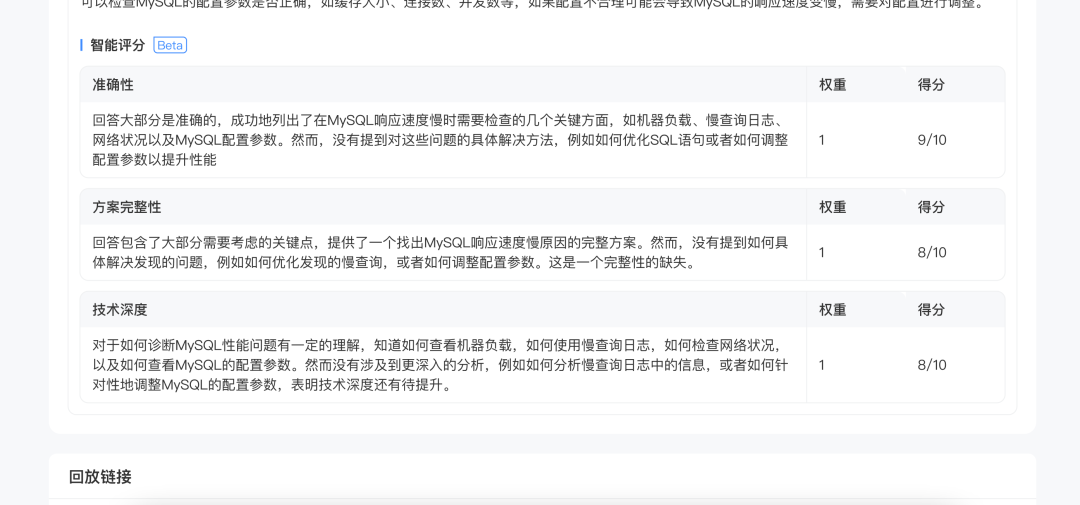

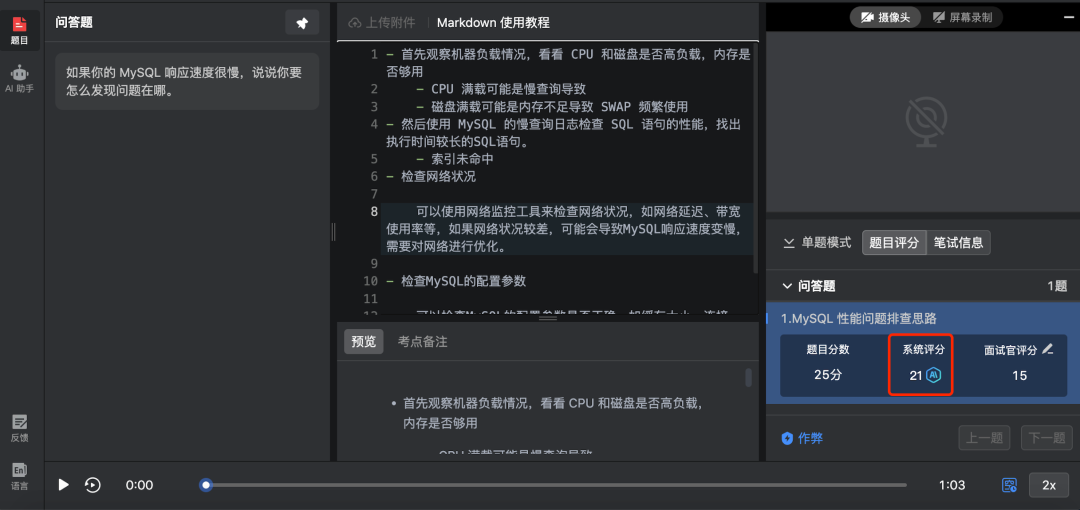

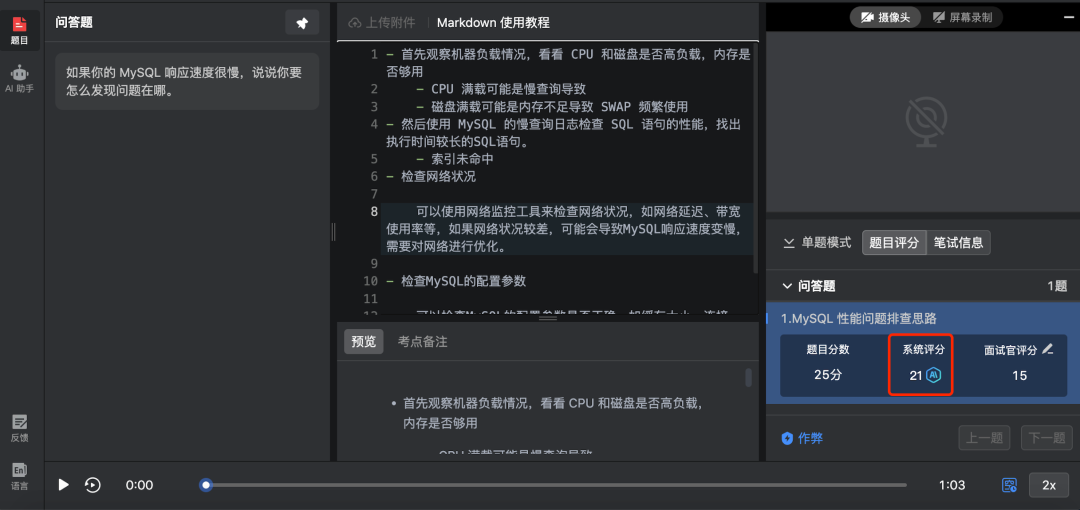

企业进入评卷界面,我们可以看到,AI已经根据刚刚我们设置的评分维度,对候选人的答案进行打分,并提供了每个评分维度的评分理由。

AI的运用,使得同一份答案多次测评,所得的分数完全一致,避免了招聘官面对同一份答案,在不同时间,或者不同招聘官之间,因个人主观因素所导致的评分差异,保障了每次测评的一致性与客观公正。

从上图可知,候选人Shawn针对该题在各维度上,均能满足基本要求,但在各维度上也有欠缺之处。当然,企业若针对该候选人,在这道题上的回答有自己的看法,也可在保持评分客观性的同时,根据自己的专业判断和经验,进行适当的调整。

评卷后,招聘官可一键生成人才报告,将Shawn与其他候选人对比,也可发给其他招聘官一同评测,减少个人主观判断的因素。

通过ShowMeBug 问答题AI智能评分,企业便能以AI自动化方式,通过不同维度,测评海量候选人问答题的答案,帮助她节省大幅的评卷工作量;也能让技术面试官和项目负责人之间拥有了一个客观标准,规避彼此之间主观分析产生的差异,对所评分数达成一致的共识;并最终深入帮技术面试官考察候选人实际工作与深入思考的能力。

看到这里,想必大家仍会对问答题AI评分功能产生疑虑:AI的结论靠谱么?稳定性怎么样?

安心,ShowMeBug 针对AI评分的可靠性、一致性与客观性,进行了完善的性能测试,测试结果为:问答题Al评分具有较高的一致性和客观性,评分行为稳定,具有高的可靠性。

今天这篇就介绍到这儿了。等下,就这样了?当然远远不够,技术测评+AI已经被我们卷出新高度了~有关如何实现技术评卷时间0投入,我们还有one more thing……敬请期待下一篇吧~:)